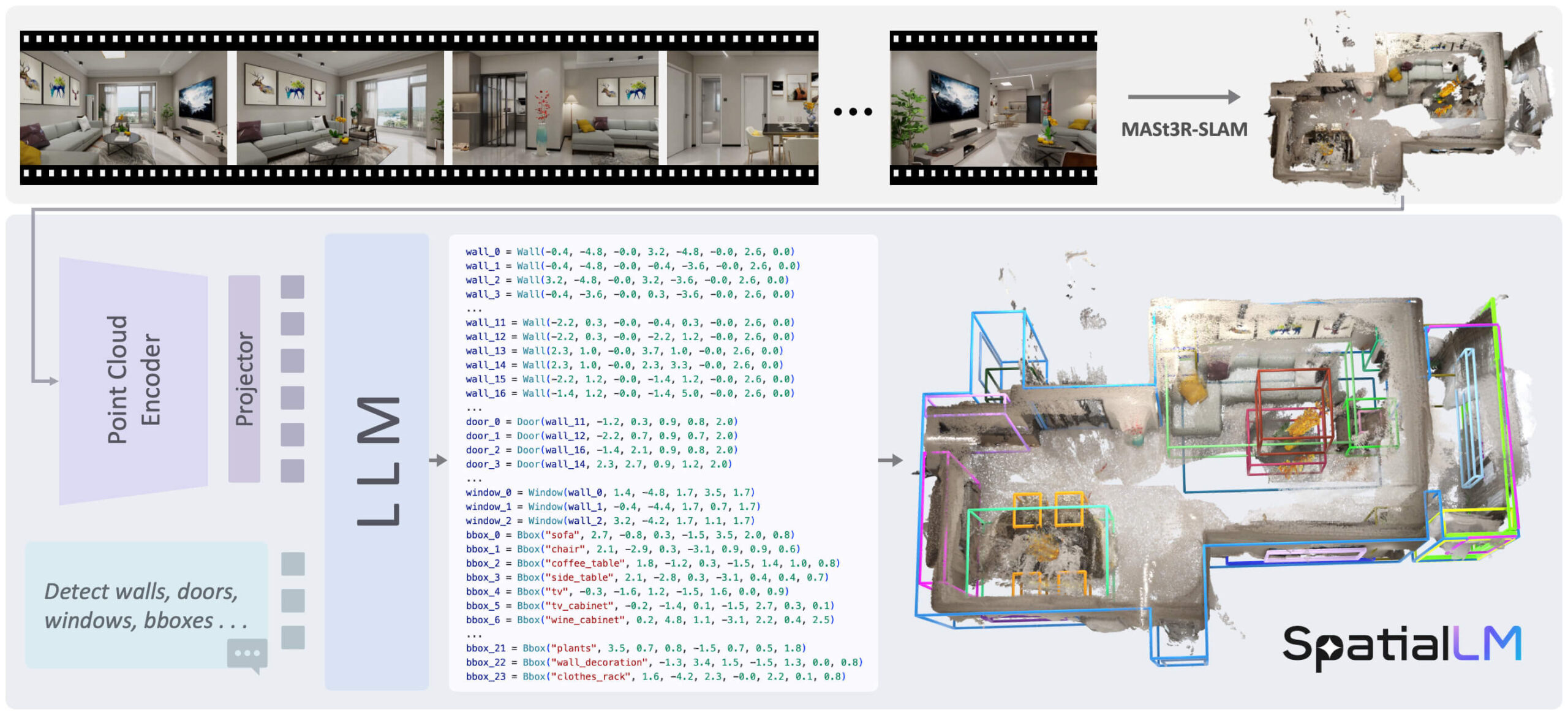

SpatialLMは、3次元(3D)点群データを処理するために特別に設計された大規模な言語モデルである。その中核機能は、非構造化3D幾何学データを理解し、構造化3Dシーン表現に変換することである。これらの構造化された出力には、建築要素(壁、ドア、窓など)と、方位とその意味カテゴリを持つオブジェクトのバウンディングボックスが含まれる。データをキャプチャするために特定のデバイスを必要とする多くのアプローチとは異なり、SpatialLMは、単眼ビデオシーケンス、RGBD画像、レーザーレーダー(LiDAR)センサーなどの複数のデータソースからの点群を処理することができます。このモデルは、3D幾何学データと構造化表現を効果的に接続し、具現化ロボット工学、自動ナビゲーション、および複雑な3Dシーン解析を必要とするその他のアプリケーションに高レベルの意味理解能力を提供します。

機能一覧

- 3D点群の処理3D点群を直接入力として分析し、理解する能力。

- 構造化シナリオの生成建物のレイアウトやオブジェクトの位置など、構造化された3Dシーン情報を出力します。

- 建築要素を特定する:: 室内の壁、ドア、窓などの基本構造を正確に検出し、モデリングします。

- 3Dオブジェクト検出:: シーン内の家具などのオブジェクトを識別し、向き、寸法、意味カテゴリ(例:"ベッド"、"椅子")を持つバウンディングボックスを生成する。

- マルチソースデータの互換性異なるデバイス(通常のカメラ、深度カメラ、LIDARなど)から生成された点群データの処理をサポート。

- カスタマイズされたカテゴリー検出ユーザーが興味のある物体のカテゴリーを指定すると、モデルはその特定のカテゴリーの物体だけを検出して出力します。

- 複数のモデル・バージョン:: LlamaやQwenのような異なる基礎モデルに基づく複数のバージョンが利用可能です。

SpatialLM1.1-Llama-1B和SpatialLM1.1-Qwen-0.5B。

ヘルプの使用

SpatialLMモデルを使用するプロセスには、主に環境のインストール、データの準備、推論の実行が含まれます。以下はその詳細な手順である。

環境要件

作業を始める前に、システム環境が以下の要件を満たしていることを確認してください:

- Python: 3.11

- Pytorch: 2.4.1

- CUDA: 12.4

1.インストールプロセス

まず、コードリポジトリをクローンしてプロジェクトディレクトリに移動し、Condaを使ってスタンドアロンのPython環境を作成し、有効化する。

# 克隆仓库

git clone https://github.com/manycore-research/SpatialLM.git

# 进入项目目录

cd SpatialLM

# 使用Conda创建名为 "spatiallm" 的环境

conda create -n spatiallm python=3.11

# 激活环境

conda activate spatiallm

# 安装CUDA工具包

conda install -y -c nvidia/label/cuda-12.4.0 cuda-toolkit conda-forge::sparsehash

次にpoetryツールはプロジェクトの依存ライブラリをインストールする。

# 安装poetry

pip install poetry && poetry config virtualenvs.create false --local

# 安装项目主要依赖

poetry install

使用している SpatialLM のバージョンによって、インストールが必要な特定の依存ライブラリが追加されます。

SpatialLMバージョン1.0に依存する。

# 该命令会编译torchsparse,可能需要一些时间

poe install-torchsparse

SpatialLM バージョン 1.1 に依存する。

# 该命令会编译flash-attn,可能需要一些时间

poe install-sonata

2.操作的推論

推論を実行する前に、入力データを準備する必要がある。SpatialLMは、入力点群データが軸合わせされていること、つまりZ軸が垂直上向きであることを必要とする。

サンプルデータのダウンロード:

このプロジェクトでは、テストデータセットを提供しています。huggingface-cliツールを使ってサンプル点群ファイルをダウンロードしてください。

huggingface-cli download manycore-research/SpatialLM-Testset pcd/scene0000_00.ply --repo-type dataset --local-dir .

推論コマンドの実行:

以下のコマンドを使用して、ダウンロードした点群ファイルを処理し、構造化されたシーン記述ファイルを生成します。

python inference.py --point_cloud pcd/scene0000_00.ply --output scene0000_00.txt --model_path manycore-research/SpatialLM1.1-Qwen-0.5B

```- `point_cloud`: 指定输入的点云文件路径。

- `output`: 指定输出的结构化文本文件路径。

- `model_path`: 指定使用的模型,可以从Hugging Face选择不同版本。

### 3. 按指定类别检测物体

SpatialLM 1.1版本支持用户指定想要检测的物体类别。例如,如果你只想在场景中检测“床(bed)”和“床头柜(nightstand)”,可以使用以下命令:

```bash

python inference.py --point_cloud pcd/scene0000_00.ply --output scene0000_00.txt --model_path manycore-research/SpatialLM1.1-Qwen-0.5B --detect_type object --category bed nightstand

detect_type objectタスクタイプを3Dオブジェクト検出のみに設定します。category bed nightstandベッド」と「ヘッドボード」のみを検出するように指定する。

4.結果の視覚化

モデル出力の効果を視覚化するにはrerun視覚化のためのツール。

まず、モデル出力のテキストファイルをRerun形式に変換する。:

python visualize.py --point_cloud pcd/scene0000_00.ply --layout scene0000_00.txt --save scene0000_00.rrd

layoutを生成する推論ステップを指定します。.txtレイアウトファイル。saveの出力を指定する。.rrdファイルパスを可視化する。

その後、rerunを使用して結果を表示する。:

rerun scene0000_00.rrd

このコマンドは、元の点群と、モデルによって予測された壁、ドア、窓、オブジェクトのバウンディングボックスを表示するビジュアライゼーションウィンドウを起動します。

アプリケーションシナリオ

- 身体化された知能とロボット工学

ロボットはSpatialLMを使用して、自分たちがいる室内環境を理解することができる。例えば、部屋の点群を分析することで、ロボットはドアや障害物、ソファやテーブルの正確な位置を特定することができ、よりスマートな経路計画やインタラクションタスクが可能になる。 - 自動ナビゲーションと地図作成

ショッピングモールや倉庫でのサービスロボットのような屋内オートナビゲーションアプリケーションでは、SpatialLMはセンサーデータから構造化された3Dマップを迅速に構築するのに役立ち、従来のSLAM手法よりも豊富な意味情報を提供できる。 - 建築・エンジニアリング・建設(AEC)

建築家やエンジニアは、ポータブル・スキャニング機器を使用して室内を素早くスキャンし、SpatialLMを使用して壁、ドア、窓の位置などを含むその部屋の構造化モデルを自動的に生成することができ、インテリア・マッピングとモデリングのプロセスを大幅に簡素化することができます。 - 拡張現実(AR)とゲーム

ARアプリケーションでは、仮想オブジェクトを環境内にリアルに配置するために、現実世界の空間レイアウトを正確に理解する必要があります。 SpatialLMは、この正確なシーン理解を提供し、仮想家具やゲームキャラクターが現実シーンと自然に相互作用することを可能にします。

QA

- SpatialLMとは?

SpatialLMは、3D点群データを理解し、壁、ドア、窓などの建築要素や注釈付きオブジェクトを含むインテリアシーンの構造化された記述を出力する3Dビッグ言語モデルである。 - このモデルはどのような入力データを扱えるのか?

単眼カメラの映像、KinectのようなRGBDカメラ、レーザーレーダー(LiDAR)センサーで撮影したデータなど、さまざまなソースからの3D点群データを処理できる。 - SpatialLMを使用するには、どのようなハードウェア構成が必要ですか?

ディープラーニングモデルの計算を含むため、NVIDIA GPUを搭載したマシンで実行し、対応するバージョンのCUDAツールキット(CUDA 12.4など)がインストールされていることを確認することを推奨します。 - SpatialLMと他の3Dシーン理解手法との違いは?

大規模な言語モデルの力を組み合わせ、単なる幾何学的情報ではなく、構造化され、意味的にラベル付けされた出力を直接生成する。さらに、ユーザーが指定した検出カテゴリをサポートし、より柔軟な検出を実現する。 - モデル出力ファイルの形式は?

モデル推論は.txtシーン内の各要素(壁、ドア、オブジェクトなど)の位置、サイズ、向き、カテゴリー情報を構造化して記述したテキストファイル。