SimはオープンソースのAIエージェントワークフロー構築プラットフォームであり、様々なツールを接続する大規模言語モデル(LLM)の迅速な作成と展開を支援するように設計されています。Sim Studioは、クラウドとローカルの両方のデプロイをサポートし、幅広い動作環境に柔軟に対応します。シンプルなNPMコマンドやDocker Composeで素早く起動することも、コンテナの設定や開発によって手動で実行することもできます。Sim Studioは、AI主導のワークフローを迅速に開発するための軽量設計とユーザーフレンドリーな操作性を重視しています。

機能一覧

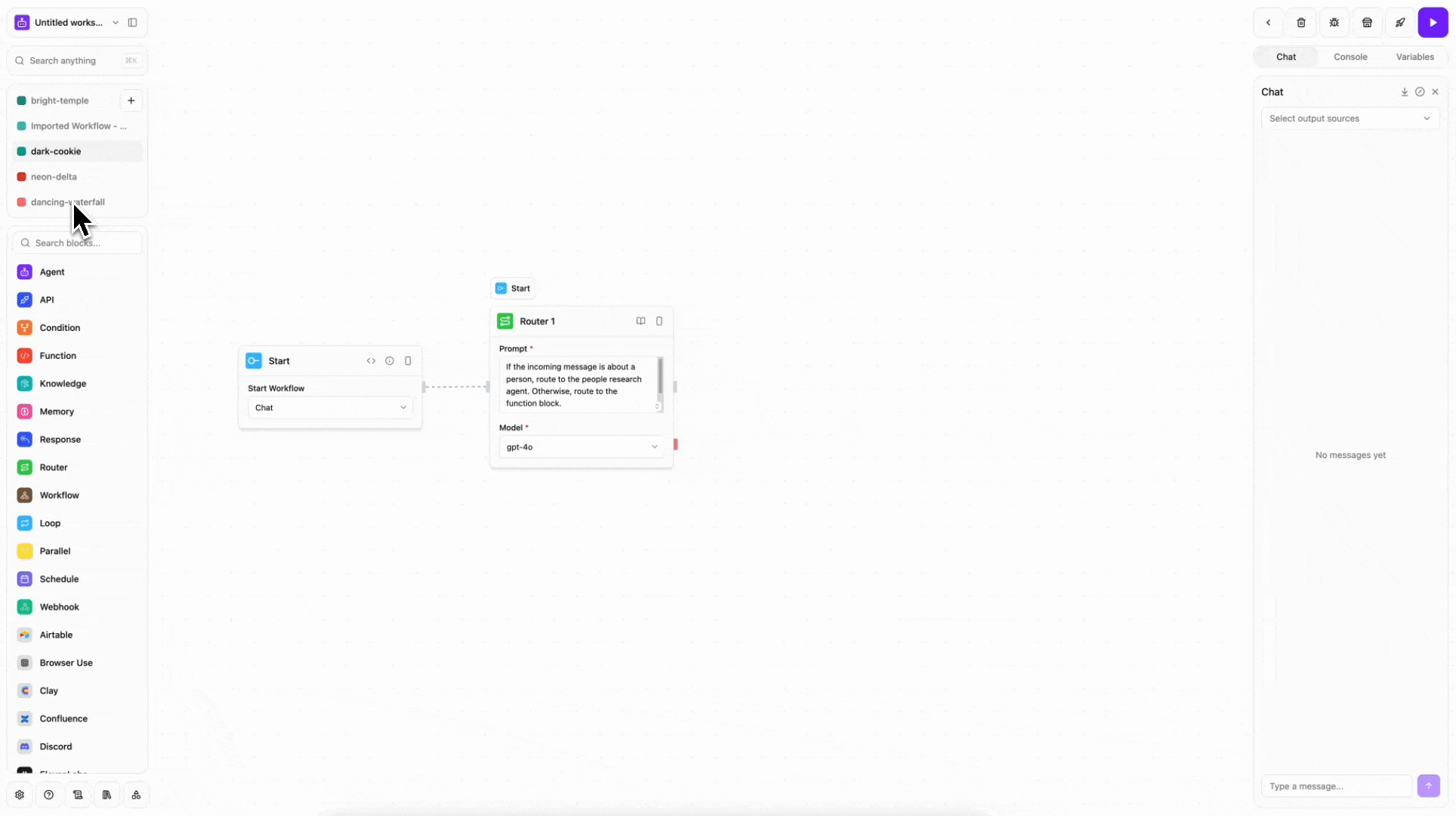

- ワークフロー構築AIエージェントのワークフローを迅速に設計し、直感的なインターフェースで外部ツールやデータソースに接続します。

- 複数の配備オプションクラウドホスティング、ローカルでの実行(NPM、Docker Compose、開発コンテナ、手動設定)をサポートします。

- 現地モデルのサポートネイティブの大規模な言語モデルを統合し、スクリプトを介してそれらを引き出し、GPUまたはCPU環境に適応させます。

- ライブサーバー動的なワークフロー調整とデータ相互作用をサポートするリアルタイム通信機能を提供する。

- データベース統合Drizzle ORMを通してデータベースの設定をサポートし、データ管理を簡素化します。

- オープンソースとコミュニティへの貢献Apache-2.0ライセンスに基づき、コミュニティによる開発と最適化が奨励されています。

ヘルプの使用

インストールと展開

Sim Studioは、さまざまなユーザーのニーズに対応するため、さまざまなインストールおよび配備オプションを提供しています。以下に詳細な手順を示します:

方法 1: NPM パッケージを使う (最も簡単)

Dockerをインストールするだけで、ローカルにデプロイできる。

- Dockerがインストールされ、実行されていることを確認する。

- ターミナルで以下のコマンドを実行する:

npx simstudio - ブラウザを開き、次のサイトにアクセスする。

http://localhost:3000/。 - オプションのパラメータ:

-p, --port <port>実行ポートを指定します(デフォルトは 3000)。--no-pull最新のDockerイメージのプルをスキップします。

方法2:Docker Composeを使う

よりコントロールが必要なユーザーに最適。

- クローン倉庫

git clone https://github.com/simstudioai/sim.git cd sim - Docker Composeを実行する:

docker compose -f docker-compose.prod.yml up -d - インタビュー

http://localhost:3000/。 - ローカルモデルを使用する場合

- モデルを引っ張る:

./apps/sim/scripts/ollama_docker.sh pull <model_name> - ローカルモデルをサポートする環境を整える:

- GPU環境:

docker compose --profile local-gpu -f docker-compose.ollama.yml up -d - CPU環境:

docker compose --profile local-cpu -f docker-compose.ollama.yml up -d

- GPU環境:

- サーバー展開:編集部

docker-compose.prod.yml設定OLLAMA_URLはサーバーのパブリックIP(例えばhttp://1.1.1.1:11434)、再実行する。

- モデルを引っ張る:

アプローチ3:開発コンテナの使用

VS Codeを使用している開発者向け。

- VS CodeとRemote - Containersエクステンションをインストールします。

- クローン化したSim Studioプロジェクトを開くと、VS Codeは「コンテナで再オープン」を促します。

- プロンプトをクリックすると、プロジェクトは自動的にコンテナ内で実行される。

- ターミナルで実行:

bun run dev:fullまたはショートカットコマンドを使う:

sim-start

方法4:手動設定

フルカスタマイズが必要なユーザーに最適。

- リポジトリをクローンし、依存関係をインストールする:

git clone https://github.com/simstudioai/sim.git cd sim bun install - 環境変数を設定する:

cd apps/sim cp .env.example .envコンパイラ

.envファイルにDATABASE_URL、BETTER_AUTH_SECRET和BETTER_AUTH_URL。 - データベースを初期化する:

bunx drizzle-kit push - サービスを開始する:

- Next.jsフロントエンドを実行します:

bun run dev - ライブサーバーを実行する:

bun run dev:sockets - 両方を同時に実行する(推奨):

bun run dev:full

- Next.jsフロントエンドを実行します:

主な機能

- AIワークフローの作成:

- Sim Studio(クラウドまたはローカル)にログインします。

- インターフェイスで「新規ワークフロー」を選択する。

- モジュールをドラッグ・アンド・ドロップするか、テンプレートを使ってAIエージェントを構成し、Slack、Notion、カスタムAPIなどのツールに接続します。

- トリガー条件と出力ターゲットを設定し、ワークフローを保存してテストします。

- ローカルモデルの使用:

- プルモデル(LLaMAやその他のオープンソースモデルなど):

./apps/sim/scripts/ollama_docker.sh pull <model_name> - ワークフロー構成でローカルモデルを選択し、GPUまたはCPUモードを指定する。

- モデルの応答をテストし、ワークフローが正しく動作していることを確認する。

- プルモデル(LLaMAやその他のオープンソースモデルなど):

- リアルタイム通信:

- Sim Studioのリアルタイムサーバーは、ワークフローの動的調整をサポートします。

- インターフェイスのリアルタイムモードを有効にして、データの流れと出力結果を観察する。

- ワークフローの更新は、APIまたはインターフェイスを介して手動でトリガーすることができます。

- データベース管理:

- Drizzle ORM を使用して、ワークフローデータを保存するデータベースを設定します。

- 在

.envセットアップDATABASE_URLランニングbunx drizzle-kit push初期化。 - インターフェイスを通してデータテーブルを表示し、管理する。

ほら

- 互換性の問題を避けるため、Dockerのバージョンが最新であることを確認してください。

- ローカルモデルは大きなストレージスペースと計算リソースを必要とするため、高性能GPUが推奨される。

- サーバーの展開には、適切な外部アクセスを確保するためのパブリックIPとポートの設定が必要です。

アプリケーションシナリオ

- 自動化されたカスタマーサービス

Sim Studioを使用して、CRMシステムやチャットツールに接続し、人手をかけずに顧客からの問い合わせに自動的に対応するAIカスタマーサービスエージェントを構築します。 - コンテンツ生成

開発者は、ネイティブモデルから記事、コード、デザインドラフトを生成することができます。 Notion またはグーグル・ドライブのストレージに出力する。 - データ分析ワークフロー

AIエージェントを設定してCSVデータを分析し、ビジュアルレポートを生成し、TableauやカスタムAPIに接続して処理を自動化する。 - 生産性向上ツール

カレンダー、Eメール、タスク管理ツールと連携し、会議のスケジュールやサマリーを自動生成。

QA

- Sim Studioは無料ですか?

Sim StudioはApache-2.0ライセンスに基づくオープンソースプロジェクトで、無料でご利用いただけます。クラウド版ではホスティング料金が発生する場合がありますので、詳細は公式価格をご確認ください。 - プログラミングの経験が必要ですか?

必要ありません。インターフェースはシンプルで、技術者でないユーザーにも適している。しかし、開発者は、手動設定またはAPIを介してより複雑な機能を実装することができます。 - どのような大きな言語モデルに対応していますか?

スクリプトから取り込んでローカルで実行できる、幅広いオープンソースモデル(LLaMAなど)をサポート。 - コードを提供するには?

GitHubリポジトリのContributing Guideを参照し、Pull Requestを提出して開発に参加してください。