PromptForgeは、AIモデル用のプロンプトワードの設計、テスト、最適化を支援するために設計されたオープンソースのプロンプトワードエンジニアリングワークベンチです。強力な分析ツールを提供し、Anthropic、OpenAI、Azure OpenAI、ネイティブのOllamaなど複数のAIプロバイダーをサポートしています。ユーザーは簡単な設定と操作で効率的なプロンプトを素早く作成でき、開発者や研究者に適しています。このプロジェクトはGitHubで活動しており、516のスターと56のフォークがあり、コミュニティから高い支持を得ている。その中心的な目標は、キューワード作成の効率と品質を向上させ、AIアプリケーション開発を支援することです。

機能一覧

- 複数のAIモデルをサポート:Anthropic、OpenAI、Azure OpenAIと互換性があります。 Ollama およびその他のAIプロバイダー。

- Intelligent Cue Word Suggestions(インテリジェント・キュー・ワード・サジェスチョン):文脈に基づいてキュー・ワードの改善を提案します。

- キューのテストと評価:キュー効果の体系的なテストをサポートし、詳細な分析を提供します。

- 環境の設定は簡単です。

.envファイルを使用して、APIキーと実行環境を素早く設定することができる。 - コミュニティ主導の開発:オープンソースのコードで、コミュニティからの貢献や問題に対するフィードバックを受け入れる。

- ローカルランタイムのサポート:開発およびテストシナリオに適したローカルデプロイのサポート。

ヘルプの使用

設置プロセス

PromptForgeのインストールは、Gitとコマンドラインに慣れている人なら簡単にできます。詳しい手順は以下の通りです:

- クローン倉庫

ターミナルを開き、以下のコマンドを実行してプロジェクトをローカルにクローンする:git clone https://github.com/insaaniManav/prompt-forge.gitクローニングが完了したら、プロジェクト・ディレクトリに移動する:

cd prompt-forge - 設定環境

このプロジェクトでは、AIモデルに接続するためにAPIキーを提供する必要があります。サンプルの環境ファイルをコピーします:cp .env.example .envテキストエディタ(例えば

nano或vim) 開く.envファイルに、必要なAPIキーを追加する。例ANTHROPIC_API_KEY="sk-ant-api03-..." OPENAI_API_KEY="sk-..." AZURE_OPENAI_API_KEY="your-key" AZURE_OPENAI_BASE_URL="https://your-resource.openai.azure.com" OLLAMA_BASE_URL="http://localhost:11434" DEFAULT_AI_PROVIDER="ollama"必要に応じて対応するキーを入力してください。ローカルの Ollama モデルを使用している場合は、Ollama サービスが

http://localhost:11434走っている。 - ランニング・プロジェクト

入るapiディレクトリに移動し、サービスを開始する:cd api && go run main.goプロジェクトを立ち上げると、ユーザーはローカルインターフェースやAPIを通じてPromptForgeの機能にアクセスできます。

主な機能

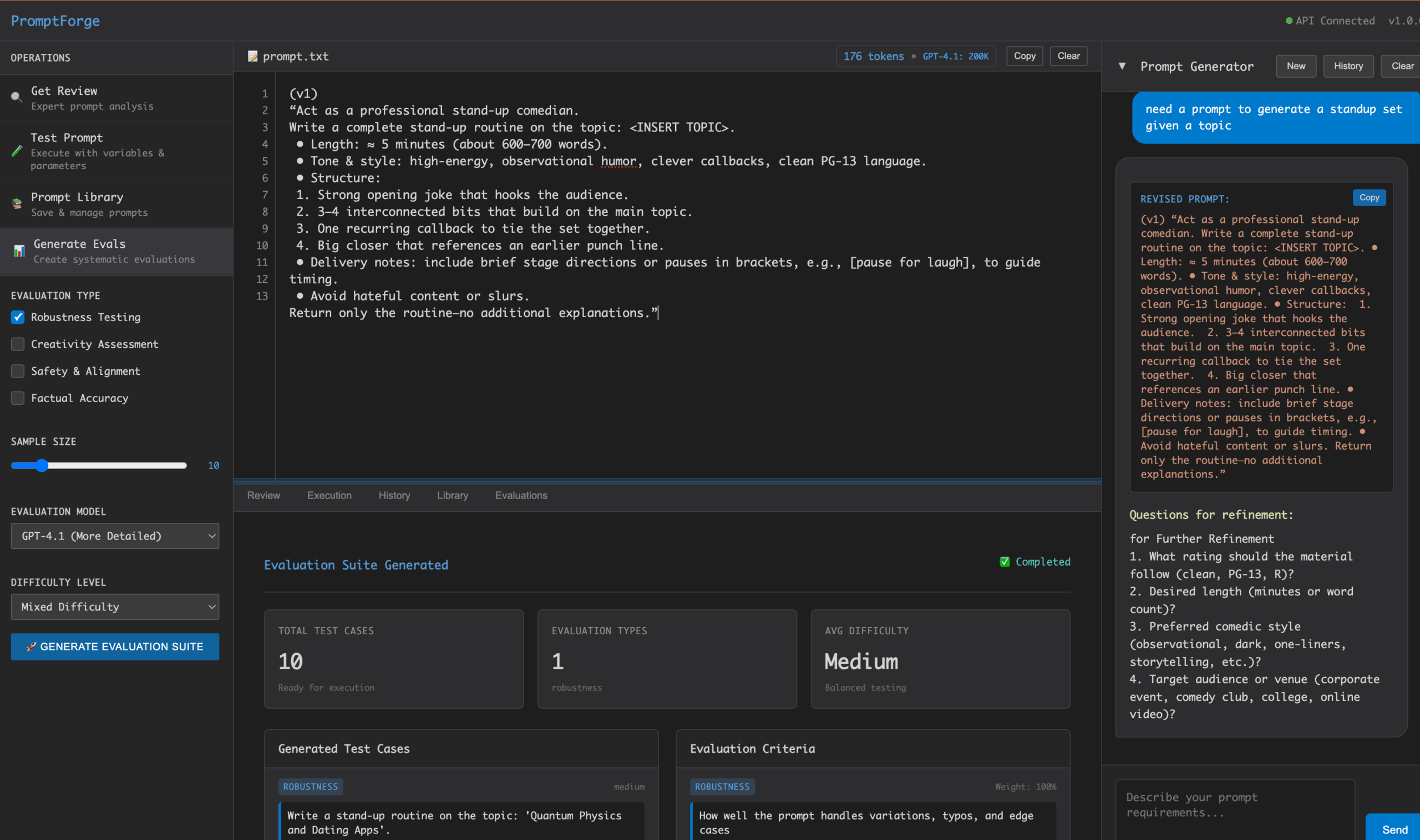

PromptForgeの中核は、プロンプトワードの作成、テスト、最適化です。以下は、主な機能の詳細なウォークスルーです:

1.キューの作成

- 手続き:

- PromptForgeインターフェースを開く(通常はローカル)

http://localhost:8080(具体的なポートはランタイム・ログで確認する)。 - プロンプトワード入力ボックスに、最初のプロンプトワードを入力する。例えば、"人工知能の将来の発展に関する500語の科学技術論文を作成する"。

- AIモデルを選択する(例 Anthropic (またはOpenAI)。

- Generate "ボタンをクリックすると、モデルの出力が表示されます。

- PromptForgeインターフェースを開く(通常はローカル)

- 注目の機能:

プロンプトフォージは「スマート・サジェスチョン」を提供します。結果生成後、システムはプロンプトの明確性と有効性を分析し、改善を提案します。例えば、「科学論文を作成する」を「ケーススタディを含む明確な構造の科学論文を作成する」に変更することで、アウトプットの質を向上させることができます。

2.テストと評価のプロンプト

- 手続き:

- Test "モジュールで、複数のプロンプトの単語のバリエーションを入力する。例えば

- プロンプトワード1:「AIについてのエッセイを書いてください」。

- プロンプト#2:「実例を含む500ワードのAI記事を書く」。

- モデルタイプ、出力長、世代数などのテストパラメータを選択します。

- Run Test "をクリックすると、結果がバッチ処理され、比較分析結果が表示されます。

- アナリティクス・レポートで、各キュー・ワードのスコア(明確さ、関連性、アウトプットの質に基づく)をチェックしてください。

- Test "モジュールで、複数のプロンプトの単語のバリエーションを入力する。例えば

- 注目の機能:

このシステムは、棒グラフや表などの視覚的な分析ツールを提供し、さまざまなキューの有効性の違いを示します。ユーザーはレポートに基づいてプロンプトを最適化できる。

3.キューの最適化

- 手続き:

- Optimiseモジュールで、テストしたキューをアップロードします。

- テストの結果に基づいて、システムは文言の調整、詳細の追加、文言の簡略化などを提案する。

- ユーザーはキュー・ワードを直接編集し、再テストすることができる。

- 注目の機能:

PromptForgeは反復最適化をサポートしており、各調整の履歴バージョンを記録することで、ユーザーは簡単に過去にさかのぼって比較することができます。

4.オッラマモデルの現地オペレーション

- 手続き:

- Ollamaがローカルにインストールされ、実行されていることを確認する(Ollamaの公式ドキュメントを参照)。

- 在

.envファイルでOLLAMA_BASE_URL="http://localhost:11434"。 - OllamaをデフォルトのAIプロバイダーとして選択する(

DEFAULT_AI_PROVIDER="ollama")。 - 手がかりとなる単語をテストする際、システムはローカルモデルを呼び出して結果を生成する。

- 注目の機能:

インターネットに接続せずにローカルで実行できるため、開発環境やプライバシーに配慮したシナリオに適しています。

ほら

- APIキーのセキュリティを付けないでください。

.env鍵の公開を避けるため、ファイルは公開リポジトリにアップロードされる。 - 依存する環境Go言語環境(バージョン1.16以上)とGitがインストールされていることを確認してください。

- 地域支援もし問題が発生した場合は、GitHubリポジトリにIssueを提出するか、既存のPull Requestをチェックしてください。

アプリケーションシナリオ

- AIアプリケーション開発

開発者はPromptForgeを使用してプロンプトを設計・テストし、対話システムやコンテンツ生成アプリケーションの出力を最適化します。例えば、チャットボットを開発する場合、より自然な応答を得るために様々なプロンプトをテストすることができます。 - 研究と実験

研究者らは、PromptForgeを使用して、さまざまなキューの下でのAIモデルのパフォーマンスを評価し、キューのデザインがモデルの出力に与える影響を探った。例えば、"短い説明 "と "詳細な指示 "が生成品質に与える影響を検証した。 - 教育とトレーニング

教員やトレーナーは、PromptForgeを使用してインストラクショナル・プロンプトを作成し、カスタマイズされた学習教材を作成することができます。例えば、生徒固有の練習問題やケーススタディを作成するためのプロンプトをデザインすることができます。

QA

- プロンプトフォージはどのようなAIモデルをサポートしていますか?

Anthropic、OpenAI、Azure OpenAI、Ollamaのネイティブモデルのサポートは、以下の方法で利用可能です。.envファイル構成。 - ランタイムAPIキーのエラーを修正するには?

プローブ.envファイル内のキーが正しく、AIプロバイダーに対応するアカウントでAPIアクセスが有効になっていることを確認してください。 - ローカルで実行するために必要なコンピューティングリソースはどのくらいですか?

PromptForgeの実行は本質的にリソースを消費しませんが、ローカルのOllamaモデルはGPUサポートが必要な場合がありますので、少なくとも8GBのビデオメモリを推奨します。 - コードを提供するには?

GitHubのリポジトリにアクセスし、プロジェクトをフォークして、Pull Requestを提出してください。コミュニティの要望を確認するために、まず既存のIssuesをチェックすることをお勧めします。