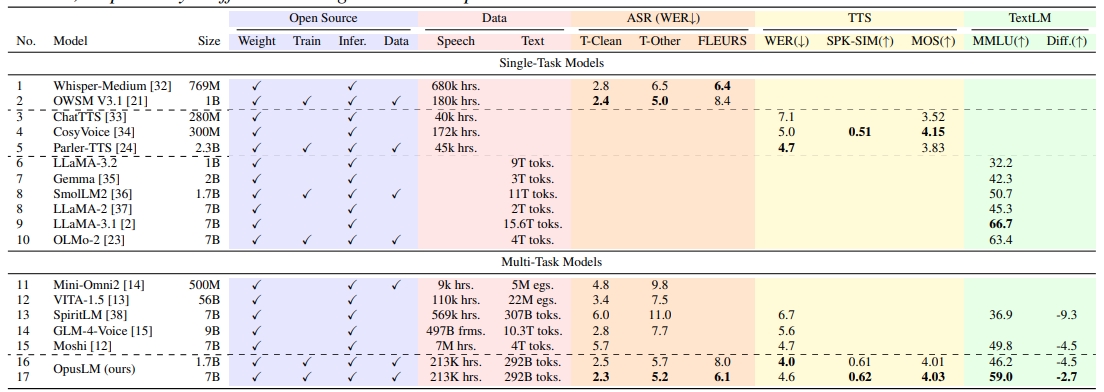

OpusLM_7B_Annealは、ESPnetチームによって開発され、Hugging Faceプラットフォーム上でホストされているオープンソースの音声処理モデルです。音声認識、テキスト読み上げ、音声翻訳、音声強調など、さまざまなタスクに焦点を当てており、研究者や開発者が音声処理の分野で実験や応用を行うのに適しています。OpusLM_7B_AnnealはESPnetエコシステムの一部であり、幅広い学術研究や実世界の開発アプリケーション向けに、多言語および多様な音声タスクをサポートしています。

機能一覧

- 音声認識音声入力をテキストに変換し、多言語の音声認識をサポートします。

- 音声合成テキスト入力から自然で滑らかな音声出力を生成します。

- 音声翻訳テキストや音声を、ある言語の音声から別の言語に変換することができます。

- スピーチエンハンスメント音質を最適化し、バックグラウンドノイズを低減し、音声の明瞭度を向上させます。

- モデリングの微調整特定のタスクに合わせてモデルを微調整できるよう、ユーザーをサポートする。

- オープンソース・サポート開発者による容易な統合と二次開発のために、完全なモデルウェイトとプロファイルを提供します。

ヘルプの使用

設置プロセス

OpusLM_7B_Annealモデルを使用するには、まずESPnetツールキットと関連する依存関係をインストールする必要があります。以下に詳細なインストール手順を示します:

- 環境準備

システムにPython 3.7以降がインストールされていることを確認し、依存関係の衝突を避けるために仮想環境を推奨します:python -m venv espnet_env source espnet_env/bin/activate # Linux/Mac espnet_env\Scripts\activate # Windows - ESPnetのインストール

pipを使用してESPnetをインストールします:pip install espnet - 追加の依存関係をインストールする

OpusLM_7B_AnnealはPyTorchとサウンドファイルライブラリに依存しています:pip install torch torchaudio soundfile - ダウンロードモデル

Hugging FaceプラットフォームからOpusLM_7B_Annealモデルファイルをダウンロードしてください。これはhuggingface-cli道具だ:huggingface-cli download espnet/OpusLM_7B_Anneal --local-dir ./OpusLM_7B_Annealこれにより、モデルの重み(

model.pth)、設定ファイル(config.yaml)とデコーディング・プロファイル(decode_default.yaml)が指定されたディレクトリにダウンロードされる。 - インストールの確認

以下のコードを実行し、環境が正しいことを確認する:from espnet2.bin.tts_inference import Text2Speech text2speech = Text2Speech.from_pretrained("espnet/OpusLM_7B_Anneal") print("Model loaded successfully!")

使用方法

OpusLM_7B_Annealは幅広い音声処理に対応しており、主な機能の詳細な操作フローは以下の通りです:

1.音声合成

音声合成機能は、入力されたテキストを自然な音声に変換することができます。操作手順は以下の通りです:

- 積載モデルESPnetの

Text2Speechクラス・ローディング・モデル:from espnet2.bin.tts_inference import Text2Speech import soundfile text2speech = Text2Speech.from_pretrained("espnet/OpusLM_7B_Anneal") - スピーチの生成テキストを入力すると、対応する音声波形を生成します:

speech = text2speech("你好,这是一个测试文本。")["wav"] - オーディオの保存生成した音声をWAVファイルとして保存します:

soundfile.write("output.wav", speech.numpy(), text2speech.fs, "PCM_16") - ほら入力テキストは、機種がサポートする言語(中国語、英語など)と一致していることを確認してください。音声のトーンやスピードは設定ファイルで調整できます。

2.音声認識

音声認識機能は、音声ファイルをテキストに変換します。手順は以下の通り:

- オーディオの準備オーディオファイルのフォーマットがWAVであること、サンプルレートが16kHzであること、またはその機種と互換性があることを確認してください。

- 積載モデルESPnetの

Speech2Textクラス:from espnet2.bin.asr_inference import Speech2Text speech2text = Speech2Text.from_pretrained("espnet/OpusLM_7B_Anneal") - 役員表彰音声ファイルのパスを入力すると、認識結果が表示されます:

text, *_ = speech2text("input.wav")[0] print("识别结果:", text) - 最適化のヒント音声品質が悪い場合は、まず音声強調機能を使って音声を処理してください。

3.音声翻訳

音声翻訳機能は、ある言語から別の言語のテキストや音声への変換をサポートします。操作手順は以下の通りです:

- 翻訳モデルの読み込み:

from espnet2.bin.st_inference import Speech2Text speech2text = Speech2Text.from_pretrained("espnet/OpusLM_7B_Anneal", task="st") - エグゼクティブ翻訳者: 音声ファイルを入力し、ターゲット言語(例:英語)を指定します:

text, *_ = speech2text("input_chinese.wav", tgt_lang="en")[0] print("翻译结果:", text) - スピーチの生成翻訳結果を音声に変換する必要がある場合は、音声合成機能と組み合わせることができます:

text2speech = Text2Speech.from_pretrained("espnet/OpusLM_7B_Anneal") speech = text2speech(text)["wav"] soundfile.write("translated_output.wav", speech.numpy(), text2speech.fs, "PCM_16")

4.ボイスエンハンスメント

ボイス・エンハンスメント機能は音質を向上させ、ノイズを含む録音を処理するのに適しています。手順は以下の通りです:

- 積載モデル:

from espnet2.bin.enh_inference import SpeechEnhancement speech_enh = SpeechEnhancement.from_pretrained("espnet/OpusLM_7B_Anneal") - 加工オーディオノイズの多い周波数を入力し、強化された音声を出力する:

enhanced_speech = speech_enh("noisy_input.wav")["wav"] soundfile.write("enhanced_output.wav", enhanced_speech.numpy(), speech_enh.fs, "PCM_16") - ほらオーディオフォーマットがモデル要件と一致していることを確認し、長すぎるオーディオによるメモリーのオーバーフローを避ける。

5.モデルの微調整

特定のタスク(特定の言語やシナリオなど)に対してモデルを最適化するには、ESPnetが提供する微調整ツールを使用します:

- データセットの準備Kaldiのスタイルに従った形式で、ラベル付きの音声データとテキストデータを用意します。

- コンフィギュレーションの微調整修正

config.yamlファイルでトレーニング・パラメーターを設定する。 - オペレーションの微調整:

espnet2/bin/train.py --config config.yaml --model_file model.pth - モデルを保存する微調整が終わったら

run.sh脚本はハギング・フェイスにアップロードされている:./run.sh --stage 13 --model_dir ./exp

その他の使用上のヒント

- モデルファイルの説明モデルファイルには以下が含まれる。

model.pth(重量ファイル、約3.77GB)、config.yaml(モデル構成)、decode_default.yaml(デコード・コンフィギュレーション)。必ず全ファイルをダウンロードしてください。 - コンピューティングリソースGPUアクセラレーションによる推論を推奨し、スムーズな動作のために最低16GBのビデオメモリを推奨する。

- 地域支援ESPnetの公式ドキュメント(

https://espnet.github.io/espnet/)、またはハギング・フェイスのコミュニティ・ディスカッションで技術サポートを受けることができます。

アプリケーションシナリオ

- 学術研究

研究者は、OpusLM_7B_Annealを使用して、新しい音声認識アルゴリズムの開発や多言語翻訳モデルのテストなどの音声処理実験を行うことができます。このモデルはオープンソースであるため、二次開発や検証が容易です。 - インテリジェントなカスタマーサービス

企業はこのモデルをカスタマーサービス・システムに統合することで、音声認識や音声合成機能による自動応答や多言語サポートを実現し、カスタマーサービス効率を向上させることができる。 - 教材

教育機関は、音声翻訳やテキスト読み上げ機能を利用して、学生の発音練習や外国語コンテンツの翻訳に役立つ言語学習ツールを開発することができる。 - コンテンツ制作

コンテンツ制作者は、音声合成機能を使ってビデオやポッドキャストのナレーションを作成し、複数の言語やスタイルをサポートして制作コストを削減することができます。

QA

- OpusLM_7B_Anneal はどの言語をサポートしていますか?

このモデルは、中国語、英語、日本語など複数の言語をサポートしている。具体的な対応言語はconfig.yamlファイルまたはESPnetドキュメントを参照してください。 - 大容量のオーディオファイルをどのように扱っていますか?

長いオーディオの場合、メモリのオーバーフローを避けるために、短いセグメント(それぞれ10~30秒)に分割し、別々に処理することをお勧めします。分割は、Audacityのようなオーディオ編集ツールを使って行うことができます。 - モデルはリアルタイム処理をサポートしているか?

現在のモデルは主にオフライン処理に使用され、リアルタイムアプリケーションでは推論速度を最適化する必要があるため、高性能GPUを使用し、バッチサイズを調整することが推奨される。 - モデル荷重の不具合を解決するには?

PyTorchとESPnetのバージョンが互換性があることを確認し、モデルファイルが完全であることを確認してください。Hugging FaceコミュニティやESPnet GitHubを参照してください。

簡単な説明