2025年8月5日。 OpenAI という2つのモデルを正式に発表した。 gpt-oss-120b 和 gpt-oss-20b オープンソースの言語モデルのこの動きは GPT-2 それ以来だ。OpenAI 大規模な言語モデリングが初めてオープンソース化された。 Meta 的 Llama シリーズと Mistral AI など、オープンソース・パワーの台頭を背景とした直接的な反応を示している。

この2つのモデルは Apache 2.0 ライセンスのもとでリリースされるため、開発者や企業は著作権や特許のリスクを心配することなく、自由に実験やカスタマイズを行い、さらには商業的に展開することができる。

モデルの特性化と詳細なカスタマイズ

OpenAI と強調する。gpt-oss このモデルは、強力なコマンドフォロー、ツール使用、および推論機能を備えたインテリジェント(エージェント)ワークフロー用に設計されています。主な機能は以下のとおりです:

- インテリジェント・ボディ・タスクのためのデザインモデルには、ウェブ検索や

Pythonコードを実行するため、複雑な自動タスクフローを構築するのに非常に有望である。 - カスタマイズ可能ユーザーは、特定のアプリケーションシナリオに応じて、モデルの推論強度を低、中、高の間で調整することができます。一方、このモデルはフルパラメーターでの微調整をサポートしており、パーソナライゼーションのための最大限のスペースを提供しています。

- 思考の連鎖:

OpenAIこのモデルの思考連鎖(CoT)を直接監督しないことを選択することで、開発者はその完全な推論プロセスにアクセスすることができる。これは、デバッグを容易にし、モデルの出力に対する信頼を促進するだけでなく、研究コミュニティにモデルの動作を監視し研究する貴重な機会を提供する。

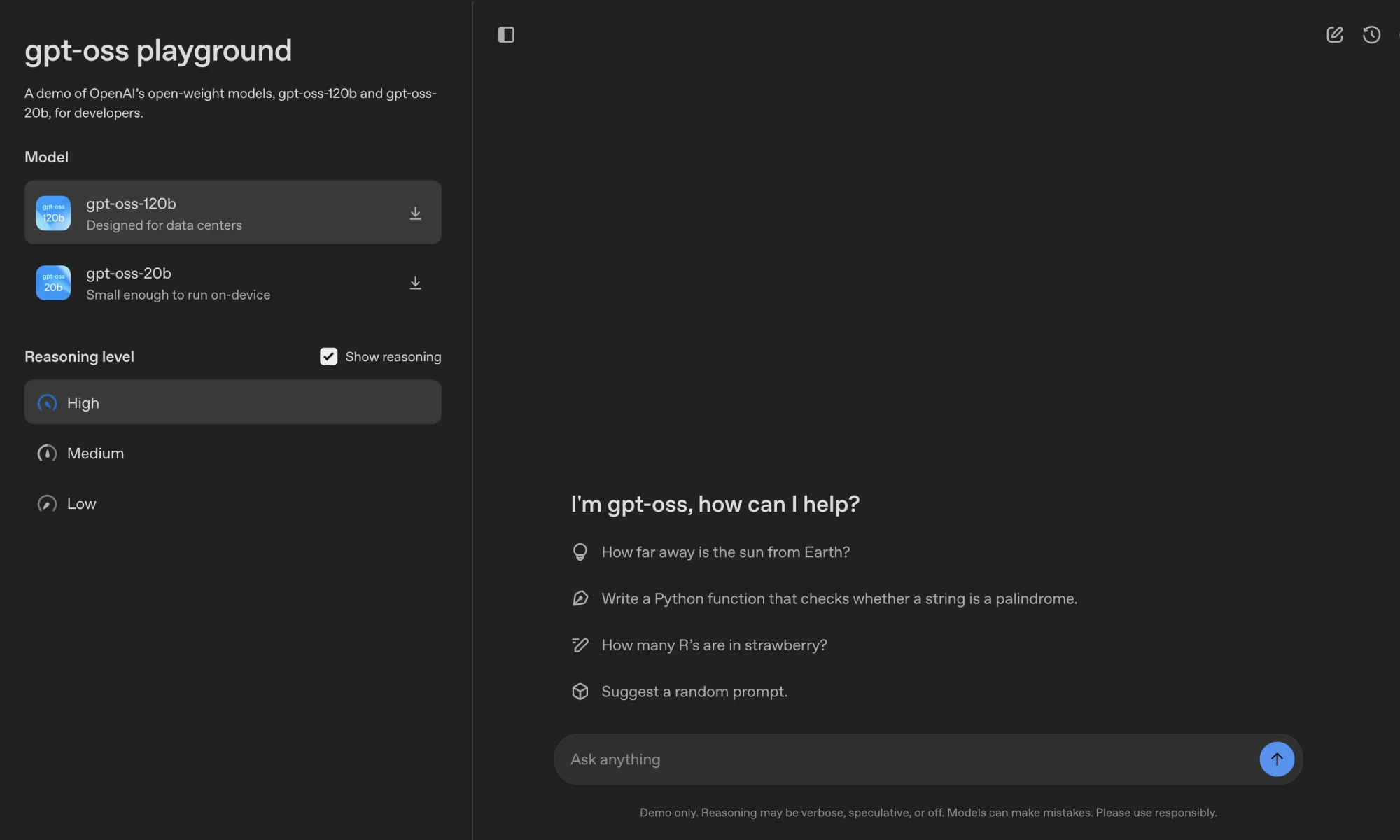

OpenAI シンプルなオンライン・プレイグラウンドが提供され、開発者は両モデルのインタラクティブ機能をブラウザで直接体験することができる。

テクニカル・アーキテクチャとパフォーマンス

gpt-oss と同じテクノロジーを採用している。 GPT-3 同系 Transformer アーキテクチャを採用し、MoE(Mixture-of-Experts)テクノロジーを導入して効率を向上させた。MoE このアーキテクチャは、手元のタスクを処理するのに必要なパラメーターの一部だけを作動させることで、計算コストを大幅に削減する。

gpt-oss-120bモデルには合計1170億ものパラメータがあるが、それぞれのパラメータを処理するのは容易ではない。 token 当時は51億のパラメータしか有効になっていなかった。gpt-oss-20bこのモデルには総パラメーターが210億個、活性化されたパラメーターが36億個ある。

どちらのモデルも128kまでのコンテキスト長をサポートし、推論とメモリ効率を最適化するために、グループ化されたマルチクエリーアテンションと回転位置埋め込み(RoPE)を使用する。

モデル・アーキテクチャの詳細

| モデリング | 階 | 全体パラメタリゼーション | 各トークンのアクティブ・パラメータ | 専門家総数 | トークンごとのアクティブなエキスパート数 | コンテキストの長さ |

|---|---|---|---|---|---|---|

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

パフォーマンスに関しては。OpenAI 公表されているベンチマーク・データによると gpt-oss パフォーマンスは非常に競争力がある。

モデルの性能比較

| gpt-oss-120b | gpt-oss-20b | OpenAI o3 | OpenAI o4-mini | |

|---|---|---|---|---|

| 推論と知識 | ||||

| MMLU | 90.0 | 85.3 | 93.4 | 93.0 |

| GPQAダイヤモンド | 80.9 | 74.2 | 77.0 | 81.4 |

| 究極の人間テスト | 19.0 | 17.3 | 24.9 | 17.7 |

| 競技数学 | ||||

| AIME 2024 | 96.6 | 96.0 | 91.6 | 93.4 |

| AIME 2025 | 97.9 | 98.7 | 88.9 | 92.7 |

データによると、フラッグシップは gpt-oss-120b 数多くのコア推論ベンチマークにおいて、そのパフォーマンスは OpenAI 独自のクローズド・ソース・モデル o4-mini 競技数学のような特定の分野では負けていないし、凌駕さえしている。そして軽量の gpt-oss-20b そのパフォーマンスもまた o3-mini に匹敵するかそれ以上である。この性能は、理論的な強豪というだけでなく、実用的なアプリケーションでトップクラスのクローズドソースモデルに挑戦する可能性を秘めている。

安全基準と生態系

オープンソースモデルが悪意のある目的に悪用されるリスクに直面している。OpenAI セキュリティーが中心に置かれていることが強調された。

OpenAI 敵対的な微調整のための社内準備フレームワークを採用 gpt-oss-120b このバージョンは厳密にテストされ、このモデルは「高容量」のリスクレベルを満たさないと結論づけられた。加えてOpenAI 賞金総額50万ドルのレッドチーム・テスティング・チャレンジも開始され、コミュニティが一丸となって潜在的なセキュリティ問題を掘り下げることを奨励している。

使い勝手の面では。OpenAI 協力 Hugging Face、Azure、AWS およびその他の配備プラットフォームと同様に NVIDIA、AMD と他のハードウェアベンダーは、このモデルが広く効率的に使用されることを保証する。gpt-oss-120b は、シングルGPUと80GBのRAMで動作することが定量化されている。 gpt-oss-20b また、16GBのRAMしか必要としないため、開発者がコンシューマーグレードのハードウェアでローカルに展開し、実験する障壁が劇的に低くなる。

戦略的意義:開放性は新たな堀か?

OpenAI この注目されるオープンソースの採用は、間違いなく現在のAIのパターンと戦略的調整に対する深い洞察である。過去にはOpenAI 頼りになるもの GPT 一連のクローズド・ソース・モデルの性能的な優位性は、商業化に大きな成功をもたらした。しかし Meta 的 Llama このシリーズは、強力なオープンソースモデルが、それ自体が強力な堀となる大規模で活気ある開発者エコシステムを生み出すことができることを証明している。

競争力のある出版物 gpt-oss モデルOpenAI 競合他社のオープンソースエコシステムへの開発者の流入を鈍らせるだけでなく、自社の技術スタック(例えば Harmony プロンプト形式)が業界標準として宣伝されている。これは防御であり、攻撃でもある。それは OpenAI を通じて、クローズドソースとオープンソースの両方の戦場で同時に戦うことができる。 API 最高のクローズドソースモデルを提供して収益を上げながら、オープンソースモデルを通じてコミュニティを構築し、人材を集め、新しいビジネスの可能性を探ることができる。

業界全体にとって。OpenAI の参入は、オープンソースのビッグモデル分野での戦いに完全に火をつけるだろう。開発者はより高品質でカスタマイズ可能なオプションを手に入れ、モデルのパフォーマンスとセキュリティの基準は新たな高みへと押し上げられるだろう。これはいったい何なのか? OpenAI これが一過性の戦術的な防衛策なのか、長期的な戦略の根本的な転換なのかは、その後の投資とコミュニティからのフィードバック次第だろう。いずれにせよ、AIのオープン化の時代が真に到来した。