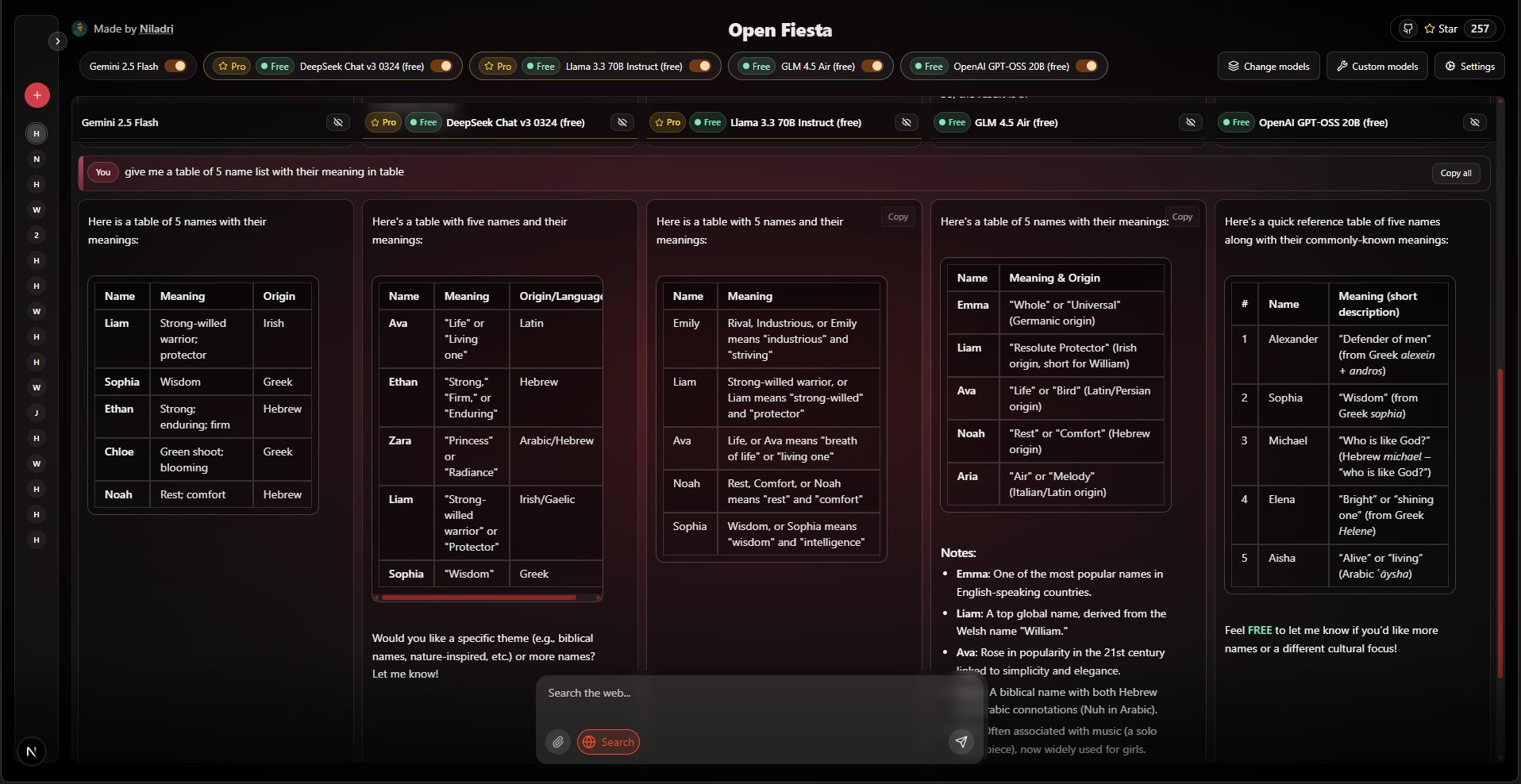

Open-FiestaはオープンソースのAIチャットツールです。同じインターフェイスで、複数の異なる大規模言語モデルと同時に会話することができる。ユーザーは最大5つのモデルを選択し、質問を送信すると、各モデルからの異なる回答を並べて直接比較することができます。このツールは、Llama 3.3、Qwen、Mistralなど、GeminiおよびOpenRouterプラットフォーム上の幅広いモデルへのアクセスをサポートしています。テキストチャットに加え、ウェブ検索や画像のアップロード(Geminiモデルのみ)といった追加機能を提供し、モデルの回答機能を強化します。プロジェクト全体はNext.jsフレームワークを使用して開発されており、ユーザーが自分でデプロイし、設定にAPIキーを記入することで使用することができます。

機能一覧

- マルチモデルチャット同じインターフェイスで最大5人のAIモデルを選択し、同時に対話と比較が可能。

- 豊富なモデルをサポートDeepSeek R1、Llama 3.3、Qwen、GeminiおよびOpenRouterへのアクセスを含むサポート。 Mistralムーンショット、レカ、サルバム、その他多くの主流モデルやオープンソースモデルがある。

- ウェブ検索各メッセージを送信する際に、ウェブ検索機能を有効にするかどうかを選択することができます。

- 画像入力ジェミニモデルを使用する場合、ユーザーは画像をアップロードし、モデルに画像の内容を理解させ、質疑応答を行うことができます。

- シンプルなユーザーインターフェースインターフェイスはすっきりしており、キーボードからの直接の質問投稿をサポートし、モデルによって生成された答えをリアルタイムでスムーズに表示します。

- APIキー管理ユーザーは、GUIの "Settings "パネルでいつでもAPIキーを提供または変更することができます。

- 応答フォーマットDeepSeek R1モデルの出力に対する特別な処理により、推論タグが自動的に削除され、Markdownフォーマットがプレーンテキストに変換されるため、コンテンツの可読性が向上します。

- オープンソースと自己展開プロジェクトはMITライセンスのオープンソースに基づいており、ユーザーはローカルまたはサーバー上で実行するためにソースコードをダウンロードすることができます。

ヘルプの使用

Open-Fiestaは、開発元が提供するURLから直接利用することも、ソースコードをダウンロードして自分のパソコンやサーバーにデプロイすることもできるウェブアプリケーションです。以下は、詳しい使い方とデプロイの手順です。

現地展開プロセス

自分のパソコンでOpen-Fiestaを動かしたい場合は、まずNode.jsの環境をインストールし、以下のステップを踏む必要があります:

- ダウンロードコード

ターミナル(コマンドラインツール)を開いてgitコマンドでプロジェクト・コードをコンピューターにクローンする:git clone https://github.com/NiladriHazra/Open-Fiesta.git次にプロジェクト・ディレクトリに移動する:

cd Open-Fiesta - 依存関係のインストール

プロジェクトのルート・ディレクトリで以下のコマンドを実行し、プロジェクトの実行に必要な依存関係をすべてインストールする:npm i - APIキーの設定

このプロジェクトでは、Big Modelサービスに接続するためのAPIキーが必要です。ローカル環境変数ファイル.env.localにキーを格納する。- プロジェクトのルート・ディレクトリに、手動で

.env.local文書の - このファイルを開き、使用するモデルに応じて以下を追加する:

OpenRouterプラットフォームのモデルを使いたい場合(無料・有料モデルを幅広くサポートしているのでおすすめ)、https://openrouter.ai、APIキーを取得してファイルに追加する必要があります:

OPENROUTER_API_KEY=你的OpenRouter密钥グーグルのジェミニ・モデル(画像入力をサポート)を使いたい場合は、まず最初に Google AI Studio APIキーを取得し、ファイルに追加する:

GOOGLE_GENERATIVE_AI_API_KEY=你的Gemini密钥

両方のキーを設定することも、片方だけを設定することもできる。

- プロジェクトのルート・ディレクトリに、手動で

- 開発サーバーの起動

上記の手順が完了したら、以下のコマンドを実行してプロジェクトを開始する:npm run devターミナルは、アプリケーションが正常に起動したことを表示し、ローカルURL(通常は

http://localhost:3000。 - 使い始める

ブラウザで開くhttp://localhost:3000そうすれば、Open-Fiestaを自分のデプロイメントで使い始めることができます。

機能操作ガイド

オープンフィエスタのインターフェイスを開くと、とてもきれいなチャットウィンドウが表示されます。

- モデルを選択

チャットインターフェースの上部に、モデル選択エリアがあります。これをクリックすると、OpenRouterとGeminiでサポートされているすべてのモデルのリストが表示されます。このリストから、同時に会話したい最大5つのモデルにチェックを入れることができます。 - メッセージを送る

下部の入力ボックスに質問や指示を入力してください。入力が終わったら、リターン(Enter)キーを押すだけで送信できます。 - ウェブ検索の使用

入力ボックスの隣に「ウェブ検索」スイッチがあります。回答する前に、モデルにウェブで情報を検索させたい場合は、質問を送信する前にこのスイッチをオンにすることができます。これは、最新の情報や事実確認を必要とする質問に特に便利です。 - 画像のアップロード(ジェミニのみ)

Geminiを含むモデルを選択した場合、入力ボックスの隣に画像のアップロードボタンも表示されます。それをクリックして、コンピューターから画像を選択してください。画像がアップロードされると、質問を送信することができ、ジェミニモデルがその画像を使って回答します。例えば、料理の写真をアップロードして「この料理は何ですか?. - 答えを見比べる

質問を送信すると、選択した複数のモデルが同時に回答を生成し始めます。その回答はそれぞれのカードに並んで表示され、機種間の違いやメリット・デメリットを直接比較することができます。 - ランタイム設定キー

もし.env.localファイルを開くか、または一時的に別のAPIキーを使用したい場合は、インターフェースの「設定」ボタンをクリックします。ポップアップパネルで、OpenRouterまたはGemini APIキーを直接入力することができます。ここで入力したキーは、現在のブラウザセッションでのみ有効ですので、ウェブページを閉じた後に再度入力する必要があります。

アプリケーションシナリオ

- コンテンツクリエーター

ブロガーやマーケティング担当者などのコンテンツ制作者は、同じトピックや指示を複数のAIモデルに同時に入力することで、複数のスタイルやアングルのコピー案を素早く得ることができる。これにより、異なるモデルのライティング能力を比較し、その中から最も質の高いコンテンツを選択したり、組み合わせたりすることができ、クリエイティブの効率が大幅に向上する。 - 開発者と研究者

コードを書いたり、技術的な問題を解決したりする開発者は、複数のモデルに質問をし、彼らが提供するコード例、解決策、またはデバッグの提案を比較することができます。一方、研究者はこのツールを使って、特定の専門分野における異なるモデルの知識の深さと推論能力を比較し、研究に役立てることができます。 - 学生と教育者

複雑な概念を学んだり論文を書いたりする学生は、複数のAI「チューター」から異なる解釈や視点を得ることで、このツールを使って理解を深めることができる。科学的原理の説明、歴史的出来事の背景の説明、論文のアウトラインの構想などをモデルに依頼し、それらを比較することで全体像を把握することができる。 - 一般ユーザーのための好奇心探索

AI技術に興味のあるユーザーにとって、このツールは素晴らしい遊び場を提供してくれる。ユーザーは、日常生活(「週末の旅行の計画を手伝ってください」)から想像的なトピック(「宇宙冒険についての短い物語を書いてください」)まで、好きなだけ質問をすることができ、さまざまなAIモデルの視覚化を行うことができます。日常生活(「週末の旅行の計画を手伝って」)から想像的な話題(「宇宙冒険のショートストーリーを書いて」)まで、さまざまなAIモデルの「個性」や「能力の違い」を直感的に感じ、好奇心を満たすことができる。

QA

- このプログラムは無料ですか?

プロジェクト自体はオープンソースで無料であり、自由にダウンロードしてデプロイすることができる。ただし、これを使用するには、サードパーティーのAIモデルサービス(OpenRouterやGoogle Geminiなど)を呼び出す必要があり、有料となる場合がある。ただし、OpenRouterプラットフォームは、無料で使用できるモデルも多数提供しており、日常的な使用には十分な量となっている。 - APIキーは安全ですか?

ローカルにデプロイする場合、APIキーは自分のコンピュータにのみ保存されます(.env.localファイル)は安全です。ウェブバージョンの設定でキーを入力した場合も、キーはブラウザにのみ保存され、サーバーにはアップロードされません。 - 一部のモデルの回答が低品質なのはなぜか?

オープン-フィエスタは、さまざまなモデルを呼び出すためのインターフェースツールにすぎず、回答の質は、選択したAIモデル自体の能力に完全に依存する。モデルによって得意、不得意、得意分野があり、さらにいくつか試してみて、自分のニーズに最も適したものを見つけることができる。 - モデルを増やすことは可能ですか?

できる。開発者であればlib/ディレクトリのモデル設定ファイルに、OpenRouter プラットフォームがサポートする新しいモデルを既存のフォーマットで追加します。