オープンソースのビッグ言語モデルをローカルで実行したい開発者のためにOllama 今や欠かせないツールとなった。モデルのダウンロード、デプロイ、管理のプロセスを大幅に簡素化した。しかし、モデルのパラメータサイズの爆発的な増加に伴い、プロフェッショナルなPCでさえ、数百ギガバイトのビデオとメモリ要件に苦慮しており、多くの最先端モデルは、ほとんどの開発者にとって手の届かないものとなっている。

この核心的なペインポイントに対処するためにOllama クラウドモデルのプレビューが最近正式に開始された。この新しいサービスは、開発者がデータセンター級のハードウェア上で巨大なモデルを実行できるようにすることを目的としており、ローカルで実行するのと同じようにインタラクティブに実行できる巧妙な仕組みになっている。

コア機能:ハードウェアの制限を突破し、ローカル体験を維持する

Ollama Cloud 設計思想は、単にクラウドAPIインターフェースを提供するのではなく、開発者が慣れ親しんでいるローカル・ワークフローにクラウド演算をシームレスに統合することである。

- ハードウェアの限界を突破するのようなファイルを直接実行できるようになった。

deepseek-v3.1:671b(6,710億パラメータ)またはqwen3-coder:480b(4800億パラメータ)のような巨大モデルである。前者は強力なハイブリッド思考モデルで、後者はアリババが開発したコード生成とエージェント・タスクに特化したモデルだ。これらのモデルは、個人用デバイスの領域をはるかに超える計算資源を必要としOllama Cloudそうすれば、この障害は完全に取り除かれる。 - シームレスなローカリゼーション体験これは

Ollama Cloud最も魅力的な点。ユーザーは既存のツールチェインを変更する必要はなく、すべての操作はローカルのOllamaクライアントを完了させる。クライアントがollama run双方向の対話ができる。ollama lsモデルのリストを見ることは、ローカルモデルを管理するのとまったく同じ体験だ。クラウドモデルは、ディスクスペースを占有しない軽量な参照または「ショートカット」としてローカルに表現されます。 - プライバシーとセキュリティを優先するAIの応用において、データのプライバシーは重要な考慮事項である。

Ollama関係者は、クラウドサーバーがユーザーからのクエリーデータを保持しないことを明確に約束しており、会話やコードスニペットがプライベートに保たれることを保証している。 - OpenAI APIに対応:

Ollama地域サービスへの影響OpenAIAPIフォーマットの互換性は人気がある。Ollama Cloudこの機能を継承するということは、既存のすべてのOpenAIAPIを持つアプリケーションやワークフローは、クラウド上でこれらのビッグモデルを使用するようにシームレスに切り替えることができる。

現在利用可能なクラウドモデル

現在Ollama Cloud プレビュー版では、以下の特大パラメトリックモデルが提供される。 -cloud 接尾辞は区別するために使われる:

- qwen3-coder:480b-cloudコード生成とエージェントタスクにフォーカスしたアリババのフラッグシップモデル。

- deepseek-v3.1:671b-cloud混合思考をサポートし、推論とコーディングに優れた超大型汎用モデル。

- gpt-oss:120b-cloud

- gpt-oss:20b-cloud

クイックスタートガイド

経験 Ollama Cloud 手続きはとても簡単で、数ステップでできる。

ステップ1:Ollamaをアップデートする

ローカルにインストールされている Ollama v0.12以上にバージョンアップしてください。最新バージョンは公式サイトからダウンロードするか、システムパッケージマネージャを使ってアップデートしてください。

ステップ2:Ollamaアカウントにログインする

クラウドモデルは ollama.com コンピューティング・リソースにログインする必要があります。 Ollama アカウントで認証を完了します。ターミナルで以下のコマンドを実行する:

ollama signin

このコマンドは、ユーザーにブラウザでログイン認証を完了するよう指示する。

ステップ3:クラウドモデルの実行

ログインに成功したら、クラウドモデルをローカルモデルのように直接実行することができます。例えば、4800億のパラメータ Qwen3-Coder モデル、実行のみ:

ollama run qwen3-coder:480b-cloud

Ollama クライアントはクラウドへのすべてのリクエストルーティングを自動的に処理し、ユーザーはモデルが応答するのを待つだけだ。

ステップ4:クラウドモデルの管理

利用する ollama ls コマンドを実行すると、ローカルにプルされたモデルのリストが表示されます。クラウドモデルの SIZE 列は次のように表示される。 -これは直感的に、ローカル・ストレージ・スペースを取らない単なる参照であることを示している。

% ollama ls

NAME ID SIZE MODIFIED

gpt-oss:120b-cloud 569662207105 - 5 seconds ago

qwen3-coder:480b-cloud 11483b8f8765 - 2 days ago

APIの統合と呼び出し

開発者にとって、APIコールは統合の中心である。Ollama Cloud ローカルのプロキシ経由とクラウドのエンドポイントへの直接アクセス。

オプション1:現地Ollamaサービス代理店経由

これは、既存のワークフローと連携する最も簡単で推奨される方法です。

まず pull コマンドはモデル参照をローカルに引き出します:

ollama pull gpt-oss:120b-cloud

次に、他のローカルモデルと同様に、ローカルモデルを呼び出す。 Ollama サービスhttp://localhost:11434) リクエストを送信する。

Pythonの例

import ollama

response = ollama.chat(

model='gpt-oss:120b-cloud',

messages=[{

'role': 'user',

'content': 'Why is the sky blue?',

},

])

print(response['message']['content'])

JavaScript(Node.js)の例

import ollama from "ollama";

const response = await ollama.chat({

model: "gpt-oss:120b-cloud",

messages: [{ role: "user", content: "Why is the sky blue?" }],

});

console.log(response.message.content);

cURLの例

curl http://localhost:11434/api/chat -d '{

"model": "gpt-oss:120b-cloud",

"messages": [{

"role": "user",

"content": "Why is the sky blue?"

}],

"stream": false

}'

方法2:クラウドAPIへの直接アクセス

サーバーやクラウド機能など、シナリオによっては、クラウドAPIを直接呼び出す方が便利な場合もある。

- APIエンドポイント:

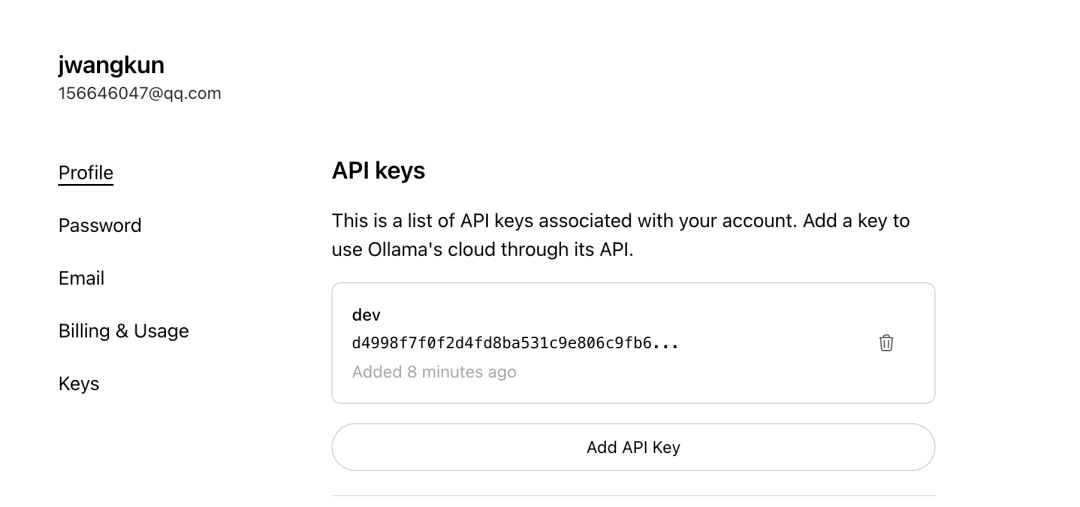

https://ollama.com/v1/chat/completions - APIキーの申請このエンドポイントに直接アクセスするには、専用のAPIキーが必要です。

Ollama公式サイトでログインした後、Keysのページで自分のキーを生成する。

クラウドAPIへの直接呼び出しは標準に従う OpenAI フォーマットでは、対応する Authorization バウチャーで十分だ。

サードパーティツールとの統合

Ollama Cloud デザインの強みは、シームレスなエコロジー互換性にある。すべてのサポートは Ollama のようなローカルAPIエンドポイントから接続するサードパーティクライアント。 Open WebUI、LobeChat 或 Cherry Studioクラウドモデルはそのまま使用できる。

以 Cherry Studio コンフィギュレーションを例に挙げる:

- セキュア

APIエンドポイントはローカルを指すOllama例http://localhost:11434。 - モデル名のリストに、直接引き出したクラウドモデルの名前を記入します。

gpt-oss:120b-cloud。 API Keyフィールドは通常空白のままです。ollama signinローカルクライアントで行われる。

コンフィギュレーションが完了すると、これらのツールでクラウドモデルへの呼び出しはローカルに行われる。 Ollama クライアントは処理のために自動的にクラウドにプロキシされ、プロセス全体が上位層のアプリケーションから完全に透過的になる。

戦略的意義と展望

Ollama Cloud 今回の発表により、オープンソースのAIモデルの使い勝手が大きく前進した。個人の開発者や熱狂的なファンにトップクラスのビッグモデルへの扉を開くだけでなく、より重要なのは、インタラクション体験をローカライズしておくことで、開発者の学習と移行のコストを削減することだ。

同サービスは現在プレビュー段階にあり、関係者はサービスの安定性を確保するために一時的な料金制限を設けていること、将来的には利用額に応じた課金モデルを導入する予定であることに言及している。 この構想は Ollama ローカルの開発環境とクラウド上の演算能力をつなぐ架け橋として位置づけられ、以下のようなアプリケーションと組み合わせて使用することができる。 Groq、Replicate などの純粋なクラウドベースの推論サービスは、競合他社に対する独自の開発者体験の優位性を持っている。