Meta AI その最新ワールドモデルであるV-JEPA 2(Video Joint Embedding Predictive Architecture 2)が6月11日にリリースされた。このモデルは、物理世界の視覚的理解と予測において最先端の性能を達成しており、不慣れな環境で未知の物体と対話するロボットの「ゼロショット」プランニングに使用できる。

モデルのリリースに伴い、物理的世界について推論する既存のモデルの能力をより正確に評価するために設計された3つの新しいベンチマークテストが実施される。この動きは、先進的な機械知能(AMI)を達成するためのメタの道における新たな一歩であるだけでなく、業界全体として、AIが物理的世界と相互作用する能力を測定するための新たな基準を提供するものでもある。

世界モデルとは?

人間の赤ちゃんは、言葉を覚えるずっと前に、観察を通して世界についての直感を確立する。例えば、テニスボールを上に投げると、空中でホバリングしたり、突然リンゴになったりすることなく落下する。この物理的直感は、内的世界モデルの現れである。

この内部モデルによって、私たちは自分や他人の行動の結果を予測し、前もって計画を立てることができる。混雑した室内を移動するときは、衝突を避けるために無意識のうちに進路を予測し、夕食の準備をするときは、いつ火を消すべきかを経験的に判断する。

物理的世界で "行動する前に考える "ことができるAIエージェントを構築するためには、その世界モデルには3つの核となる機能が必要だ:

- 理解映像の中の物体や動作、動きを認識する能力。

- 期待する世界の進化を予測し、特定の行動介入に反応して世界がどのように変化するかを予測する能力。

- 企てる予測能力に基づいて、目標達成につながる一連の行動を計画すること。

V-JEPA 2 モデル詳細

V-JEPA 2は、2022年にメタが初めて提案したJEPAアーキテクチャ(Joint Embedded Prediction Architecture)をベースに構築された12億個のパラメータを持つモデルである。このモデルは主に、膨大な量の動画に対する自己教師あり学習によって訓練され、人間のラベリングを必要とせずに、世界の仕組みを洞察することができる。

コアには2つのコンポーネントがある:

- エンコーダー生の映像を入力し、世界の状態に関する重要な意味情報を捉えた埋め込みデータを出力する。

- プレディクター映像埋め込みや予測対象などの文脈情報を受け取り、未来予測埋め込みを出力する。

V-JEPA 2のトレーニングは2段階に分かれている:

- ノーモーションの事前トレーニングモデルはまず、100万時間以上のビデオと100万枚の画像でトレーニングされた。このデータから、物体がどのように動き、相互作用するかという基本を学んだ。この段階を経て、モデルは行動認識(Something-Something v2)、行動予測(Epic-Kitchens-100)、ビデオクイズ(Perception Test、TempCompass)などのタスクでトップレベルに達した。

- 動作条件付きトレーニング第一段階を踏まえ、ロボットの視覚と制御の動きを含むデータを用いてモデルを学習する。この段階により、予測モデルは「特定の行動」を考慮に入れることを学習することができた。驚くべきことに、この段階によって、わずか62時間のロボットデータを使用して、モデルは効果的なプランニングと制御能力を獲得することができた。

V-JEPA 2は、ロボット計画タスクにおいて優れたゼロサンプル能力を発揮します。オープンソースのDROIDデータセットで訓練されたV-JEPAは、新しい環境や新しいロボットのために微調整することなく、MetaLabロボットに直接導入することができる。

掴んだり置いたりするような短いタスクの場合は、ゴールの状態の画像をロボットに与えるだけでよい。ロボットはV-JEPA 2予測器を使用して、一連の候補動作を実行した結果を「視覚化」し、ゴールに最も近い動作を選択します。モデル予測制御により、ロボットは継続的に行動を再計画し、実行することができる。より複雑な長時間の作業では、一連の視覚的サブゴールを提供することでロボットを誘導することができる。このようにして、V-JEPA 2は、新しい環境における未見の物体のピックアンドプレース作業において、65%~80%の成功率を達成した。

V-JEPA 2 関連資料

物理学の理解に新たなベンチマークを設定

モデルとともに発表された3つの新しいベンチマークテストは、モデルそのものに劣らず重要である。これらは、現在の評価システムの穴に対処し、物理世界を真に理解するモデルを構築するようコミュニティを後押しするために設計されている。人間はこれらのテストで85%~95%の精度を達成することができますが、V-JEPA 2を含むトップモデルの性能と人間との間にはまだ大きな隔たりがあります。

- IntPhys 2

このベンチマークは、物理的に「可能」なシナリオと「不可能」なシナリオを区別するモデルの能力を測定することを目的としている。このベンチマークでは、ゲームエンジンを使って、あるノードで物理法則に違反するイベントが発生するビデオのペアを生成する。このモデルは、どの映像に問題があるかを識別する必要がある。テスト結果によると、現在のビデオモデルはこのタスクにおいてランダムな推測に近い性能を発揮する。IntPhys 2 リソース。

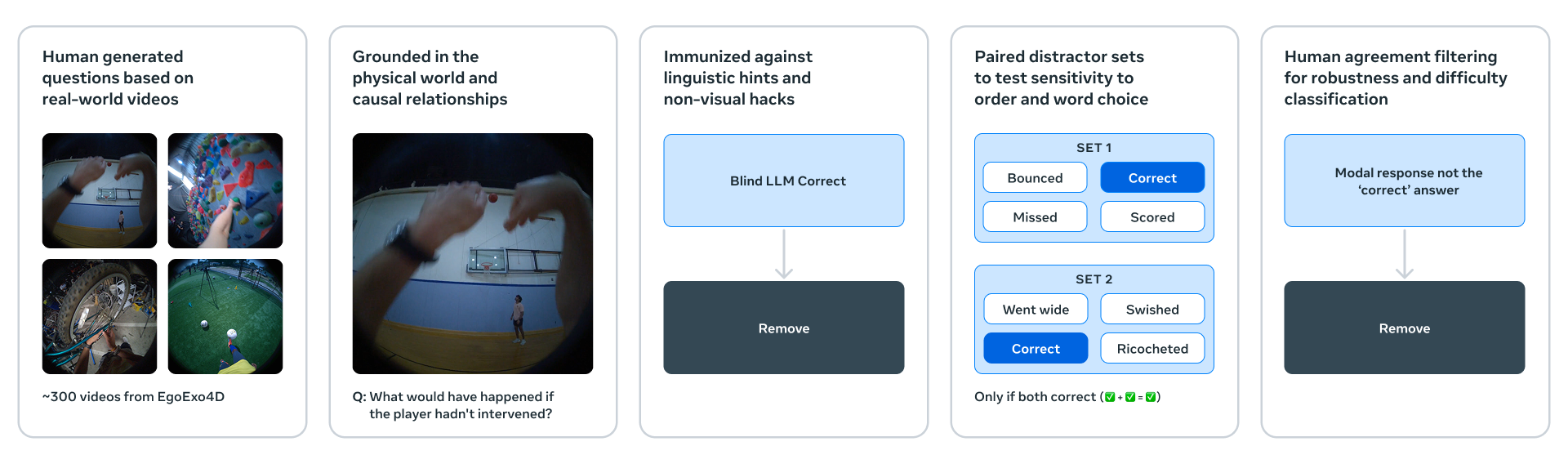

- Minimal Video Pairs (MVPBench)

このベンチマークは、ビデオ言語モデルの物理的理解度を多肢選択問題で評価する。各サンプルに「最小バリエーションペア」があるのが独創的である。モデルが得点するためには、両方の質問に正しく答えなければならず、モデルが表面的な映像やテキストを手がかりに「ショートカット」してしまう問題を効果的に抑制している。MVPBenchのリソース。

- CausalVQA

このベンチマークは、物理世界の因果関係の理解に焦点を当てている。このベンチマークでは、反実仮想(「もし......だったらどうなるか?)期待(「次に何が起こるか?)計画(「目標を達成するために次に何をすべきか?)などの質問がある。テストの結果、大規模なマルチモーダルモデルは「何が起こったか」にはよく答えたが、「何が起こったか」「何が起こり得たか」といった質問にはあまり良い結果を出さなかった。悪かった。

CausalVQAリソース。

メタはまた、ハグする顔を投稿した。ヒットチャートこの新しいベンチマークは、コミュニティ・モデルの進捗状況を追跡するために使用される。

高度な機械知能への次のステップ

V-JEPA 2は始まりに過ぎない。現在のところ、V-JEPAは単一の時間スケールで学習・予測する。しかし、「食器洗い機に食器を入れる」「ケーキを焼く」といったタスクは、異なる時間スケールで階層的なプランニングを必要とする。

したがって、今後の研究では、複数の空間的・時間的スケールにまたがって学習・推論・計画することができる階層的JEPAモデルに焦点を当てる。もう一つの重要な方向性は、視覚、聴覚、触覚、その他の感覚情報を融合して予測できるマルチモーダルJEPAモデルである。これらの探求は、AIと物理世界との深い統合を推進し続けるだろう。