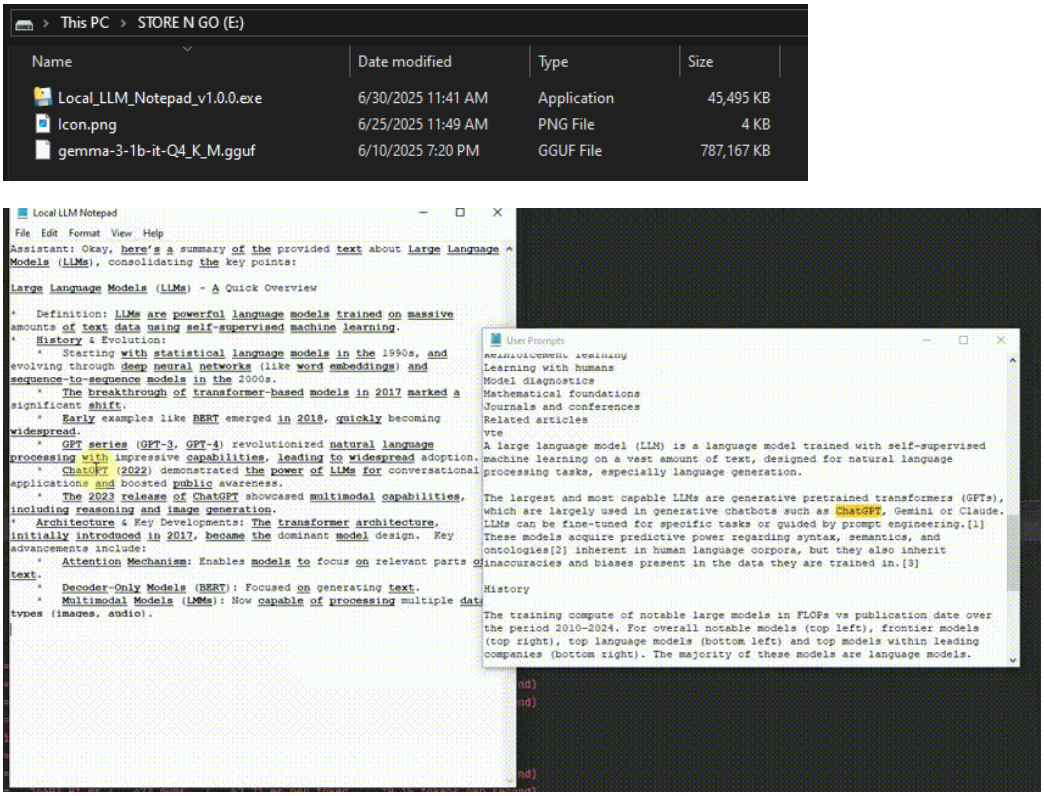

Local LLM Notepadは、インターネットに接続することなく、またインストールすることなく、USBデバイスを介してWindowsコンピュータ上でLocal Large Language Modelsを実行できるオープンソースのオフラインアプリケーションです。ユーザーは、単一の実行ファイル(EXE)とモデルファイル(GGUF形式など)をUSBスティックにコピーするだけで、いつでもどこでもチャットやブレインストーミング、文書の下書きができます。管理者権限を必要としないシンプルさと使いやすさを目標に設計されており、クライアントアクセスや一時的なワークステーションなど、さまざまなシナリオでさまざまなスキルレベルのユーザーに適しています。このツールはポータビリティとプライバシー保護を重視しており、すべてのデータ処理はクラウドやAPIサービスに依存することなくローカルで行われる。インターフェースはシンプルかつ直感的で、デュアルウィンドウレイアウト、キューワードハイライトのサポート、JSONフォーマットエクスポートダイアログにより、ユーザーはコンテンツの管理とトレースが簡単に行えます。

機能一覧

- 大規模言語モデルのオフライン実行インターネット接続は不要で、GGUF形式でモデルを読み込みます。

- ポータブルデザインインストール不要で、USBメモリから直接実行できます。

- デュアル・ウィンドウ・インタラクティブ・インターフェースインターフェイスはシンプルで余計な装飾がない。下にプロンプトの単語を入力すると、モデルの答えが上部にリアルタイムで表示される。

- キュー・ワードのハイライトとトレーサビリティCtrl+クリックすると、該当するプロンプトワードの履歴が表示されます。

- JSONダイアログ・エクスポート対話記録をワンクリックでエクスポートし、デバイス間で簡単に移行できます。

- 柔軟なモデル切り替えファイル>モデル選択」で様々なGGUFモデルを読み込むことができます。

- 高性能: 高速CPUモデル(例えば0.8GBモデル)をサポートし、一般的なハードウェアで〜20トークン/秒の生成速度を達成。

ヘルプの使用

インストールと準備

ローカルLLMメモ帳は、従来の意味でのインストールを必要とせず、プラグアンドプレイで使えるように設計されています。以下は詳細な準備プロセスです:

- ダウンロードプログラムGitHub リポジトリ (https://github.com/runzhouye/Local_LLM_Notepad) の Releases ページから、最新バージョンの

Local_LLM_Notepad-portable.exe。 - モデルファイルの取得互換性のあるモデルファイルをGGUF形式でダウンロードする。

gemma-3-1b-it-Q4_K_M.gguf(~0.8GB)。Hugging Faceまたは他のモデリング・コミュニティで入手可能。 - USBメモリにコピーするダウンロードしたEXEファイルとGGUFモデルファイルをUSBメモリなどのリムーバブルストレージにコピーします。

- ランニングプログラムWindows コンピュータ上でダブルクリック

Local_LLM_Notepad-portable.exe起動。初回実行時には、プログラムがモデルをメモリ(RAM)にロードします。このロードには数秒かかりますが、その後の操作はスムーズになります。

主な機能

1.操作と相互作用

プログラムを開始すると、インターフェイスは2つの部分に分かれる:

- 下半分: プロンプト(促音)、補助テキスト、質問、指示を入力します。

- 上部モデルの回答はリアルタイムで表示され、約20トークン/秒の速度で生成されます(ハードウェアの性能による)。

ユーザーは、「電子メールを書いてください」や「量子力学について説明してください」といった質問やタスクを直接入力することができ、モデルは即座に答えを生成する。インターフェースは直感的で、複雑なメニューはなく、素早いスタートアップに最適です。

2.キューのハイライトとトレース

ローカルLLMメモ帳の機能のひとつに、プロンプト・ワードのハイライトがある。ユーザーがキュー・ワードに入力した単語や数字は、モデル・レスポンスで太字下線フォームが表示されます。例えば、「2025年の技術動向」と入力すると、モデル回答の「2025年」または「技術」に言及している部分が強調表示されます。を押し続けることで、モデル回答の「2025年」または「技術」を指す部分を強調表示することができます。 Ctrl をクリックし、ハイライトされた単語をクリックすると、その単語を含むすべての過去のキュー単語を表示するサイドウィンドウが開きます。この機能は、データ抽出やサマリー検証など、モデル出力の検証や情報のトレースが必要なシナリオに最適です。

3.モデル切り替え

モデルを変更する必要がある場合は、メニューバーの 文件 > 选择模型新しいモデルを使用したい場合は、USBメモリにある別のGGUF形式のモデルファイルを選択してください。プログラムは再起動せずに自動的に新しいモデルを読み込みます。初めて使用される方は、推奨される軽量モデル(例えば、0.8GBの gemma-3-1b-it-Q4_K_M.gguf)一般的なハードウェアでスムーズな体験を保証する。

4.ダイアログのエクスポート

ユーザーは、インターフェイス内のエクスポートボタンをクリックすることで、現在のダイアログをJSON形式でUSBスティックまたは他のストレージパスに保存することができます。エクスポートされたファイルには、完全なプロンプトとモデルの応答が含まれているため、他のデバイスでの継続使用やアーカイブが容易になります。ステップ

- のメニューバーをクリックする。

导出ボタンだ。 - 保存パスを選択し、ファイル名を付ける(デフォルトの拡張子は

.json)。 - 保存したファイルは、テキストエディタで表示したり、JSONをサポートする他のツールにインポートすることができる。

5.パフォーマンスの最適化

プログラムは一般的なハードウェアに最適化されており、GPUのサポートは必要ありません。初めてモデルをロードする際、プログラムはモデルをRAMにキャッシュし、その後の応答を高速化します。お使いのコンピューターのRAM容量が少ない場合は、より小さなモデルファイル(1GB以下)を選択することをお勧めします。テストでは、プログラムはi7-10750HのCPUで約20トークン/秒の生成速度を達成しており、これはほとんどの日常作業に適しています。

ほら

- ハードウェア要件最小4GB RAM、スムーズな動作のために8GB以上を推奨。

- モデルの互換性PyTorchやONNXのような他のフォーマットには対応していません。

- オペレーティングシステム現在のところ、Windows版のみサポートされており、Mac版やLinux版はありません。

- プライバシーすべての処理はローカルで行われ、データのアップロードは行われません。

アプリケーションシナリオ

- 一時的なワークステーションの使用

ネットワークやアクセス制限のないコンピュータ(クライアントサイトや公共施設など)でUSBメモリからローカルLLMメモ帳を起動し、文書の下書きやアイデアのブレスト、質問への回答を素早く行うことができます。 - プライバシーに配慮した義務

法的文書の起草や機密データの分析など、高度な機密性が要求されるシナリオでは、オフラインで実行することでデータの漏洩を防ぎ、弁護士、ジャーナリスト、研究者に適しています。 - 教育と学習

生徒や教師は教室でこのツールを使って、質問を入力して複雑な概念を説明するモデルにアクセスしたり、ウェブを使わない教育環境に適した学習ノートを作成したりすることができる。 - 旅行中の創造性

外出中のライターやクリエイターは、USBメモリを使用してプログラムを実行し、クラウドベースのサービスに依存することなく、いつでもインスピレーションを記録したり、記事の下書きをしたり、クリエイティブなコンテンツを生成したりすることができる。

QA

- ネットワークは必要か?

いいえ。ローカルLLMメモ帳は完全にオフラインで動作し、すべての計算はローカルで行われ、インターネット接続は必要ありません。 - 対応機種は?

GGUFフォーマットのモデルは現在サポートされており、以下のような軽量モデルもサポートされている。gemma-3-1b-it-Q4_K_M.ggufHug16.ging Faceなどのプラットフォームから互換性のあるモデルをダウンロードできる。ユーザーはHug16.ging Faceのようなプラットフォームから互換性のあるモデルをダウンロードできる。 - マックでも使えますか?

現在サポートされているのはウィンドウズのみで、マックやリナックスのユーザーは後のバージョンを待つか、仮想マシンを使って実行する必要がある。 - 発電速度を確保するには?

プログラムはCPUに最適化され、モデルが初めてロードされたときにRAMにキャッシュされます。最高のパフォーマンスを得るためには、8GB以上のRAMを搭載したデバイスを使用し、1GB以下のモデルを選択することをお勧めします。 - 対話の記録はどのように保存されるのですか?

メニューバーのエクスポート機能でダイアログをJSONファイルとして保存し、USBメモリなどに保存すれば、移行やアーカイブが簡単に行えます。