1.シンプルなルール作りからスタート 素材を用意する前に、テーマ(記事タイトル)を作るためのルール作りが、記事生成プロセス全体の出発点です。 ここでは、最もシンプルなルールタイプ「ランダムカテゴリー」を使ってルールを生成する。 以下の設定の説明:ランダムに10のカテゴリの名前と説明を使用する...

1.1 操作ガイドライン 1.1 多言語選択 図チャンネルのみ多言語選択が有効 1.2 中国語キーワードマイニング技術 GoogleとBaiduのみ 中国語と英語のキーワードが混在している場合、英語は小文字を使用し、スペースで区切られた複数の単語を使用することをお勧めします キーワード展開のヒント: 基礎を得るために大きなモデルを使用...

0.必要:サイトの分類の完全かつ詳細な設定でなければなりません 分類名、エイリアス(英語)、説明、詳細でなければなりません。AI Content Managerは、生成されたコンテンツの方向を制御し、自動的に適切な分類を選択するために分類の分類名と詳細な説明に深く依存しています。 分類を設定した後、一度クリックして挿入してください...

これはAI Content Generation Managerの専用テーマで、このテンプレートを直接使用することはできません。 有効にした後、すべての関連設定は「テーマ設定」にあります。 1.セカンダリドメイン名アクセスを有効にする セカンダリドメイン名アクセスを有効にするケースは何ですか?すでにウェブサイトをお持ちで、メインサイトの比重を高めたい、トラフィックを集めたい、または個人...

さて、この時点でマークダウン・ファイルは1000行を超えた。これはほとんどお遊びだ。

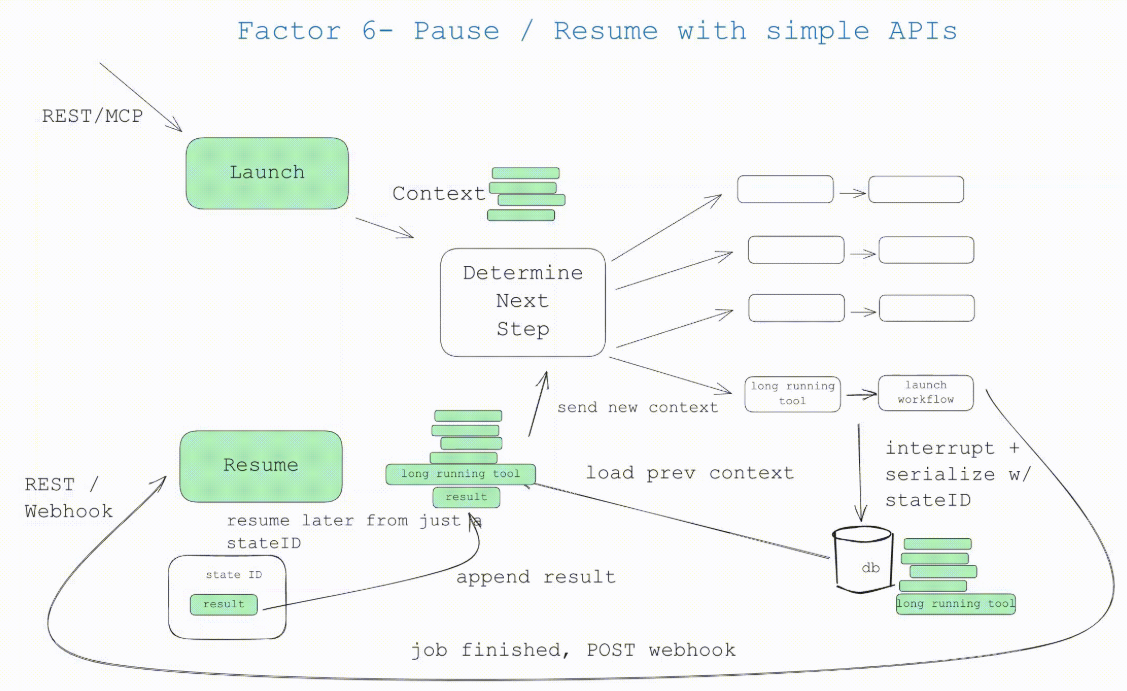

もしあなたがhumanlayerの紹介を待ち望んでいたのなら、これがそれだ。もしあなたが要素6「シンプルなAPIを介した開始/一時停止/再開」と要素7「ツールコールを介した人間とのコンタクト」を実践しているなら、この要素を統合する準備はできています。 ユーザーがAPIから開始/一時停止/再開できるようにする。

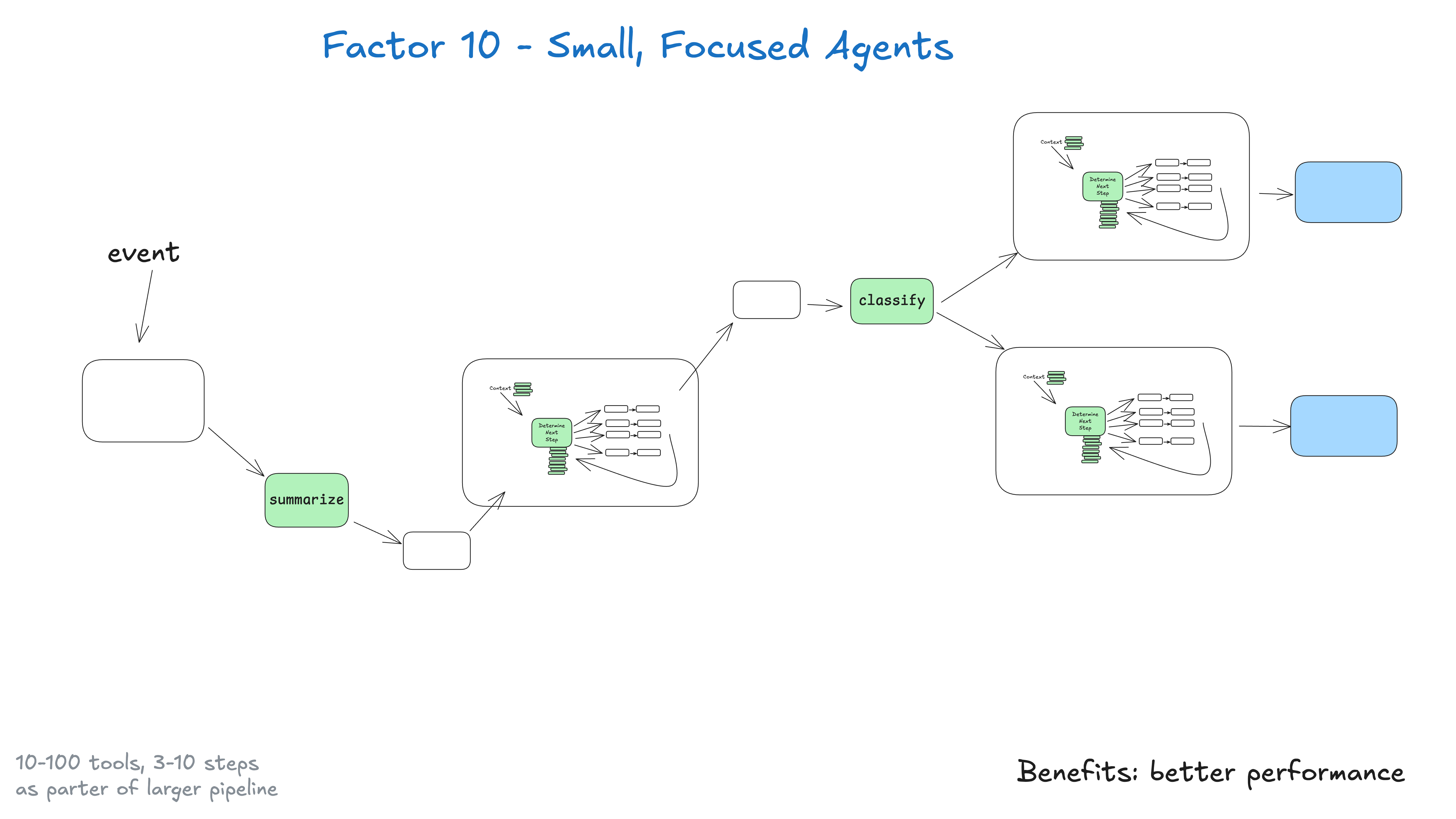

何でもこなそうとする一枚岩のインテリジェンスを構築するのではなく、一つのことをうまくこなせる、小さく集中したインテリジェンスを構築する方がいい。インテリジェンスは、より大きな、大部分は決定論的なシステムにおける1つの構成要素にすぎない。 ここでの重要な洞察は、大きな言語モデルの限界である。

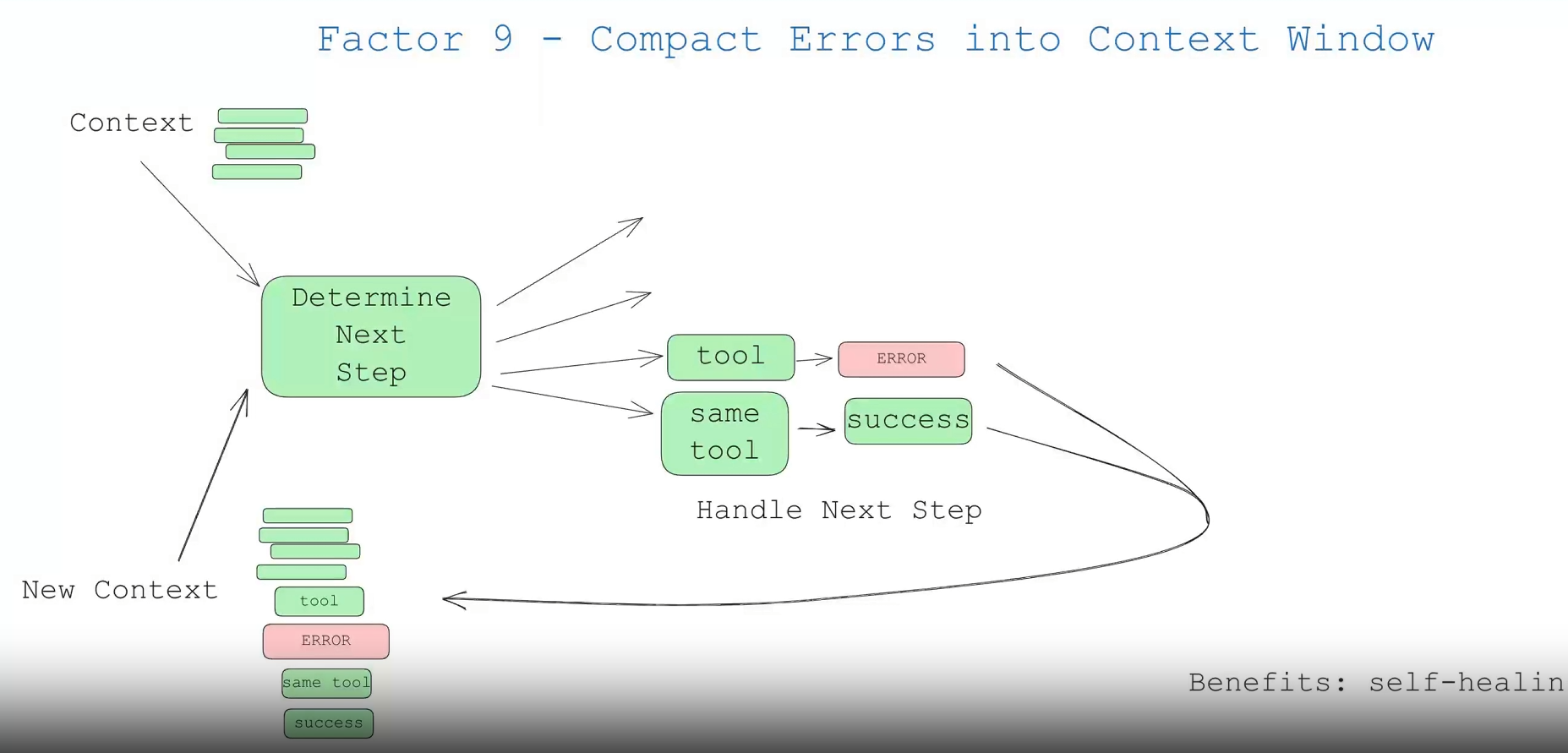

これは些細な点だが、言及する価値がある。エージェントの利点の一つは "自己修復 "です。短いタスクの場合、大規模な言語モデル(LLM)は失敗したツールを呼び出すかもしれません。優れたLLMは、エラーメッセージやスタックトレースを読み取ることができる可能性が高い。

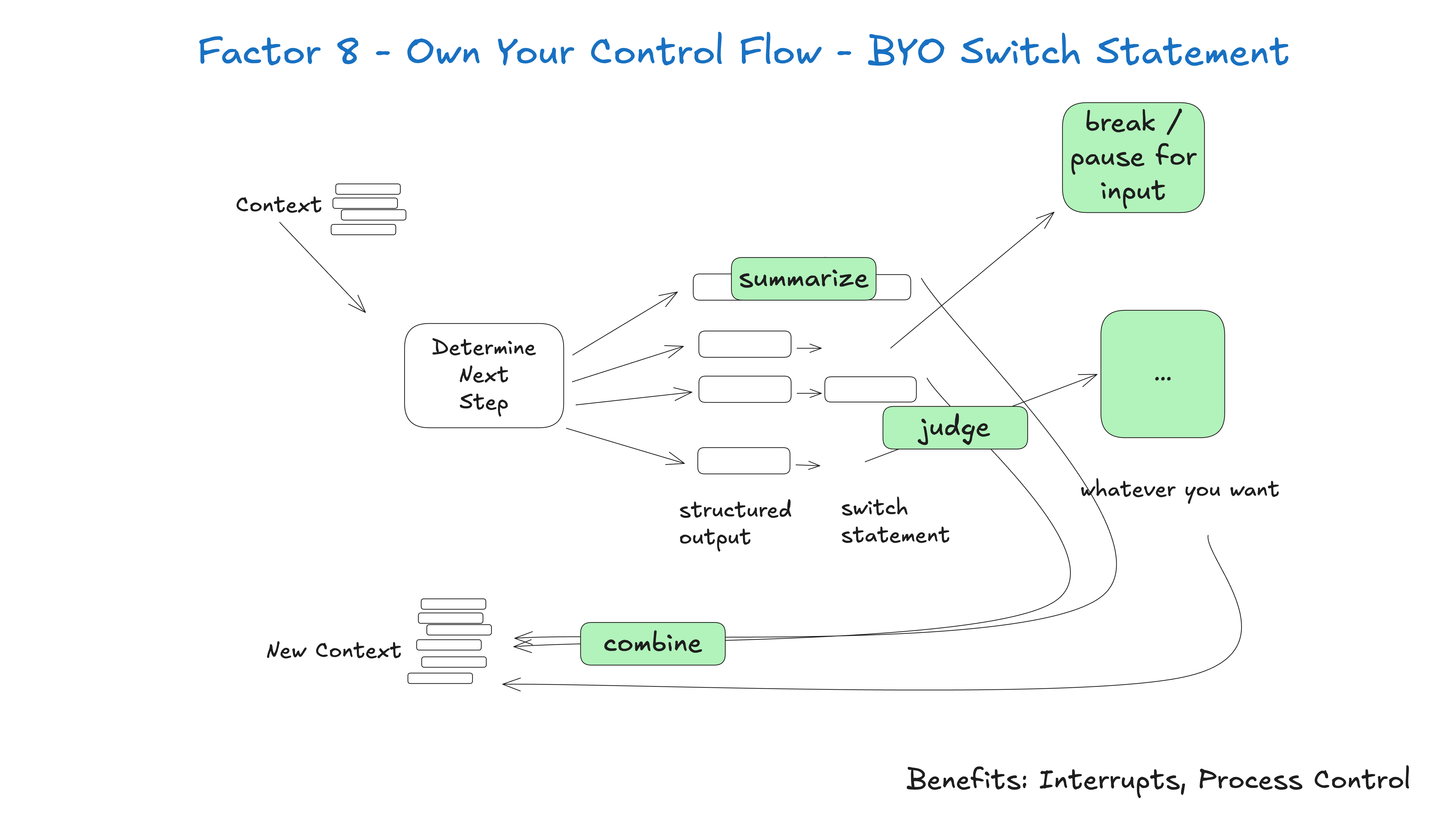

自分のコントロール・フローをコントロールできれば、多くの興味深い機能を実装できる。 特定のユースケースに適合するカスタム制御構造を構築する。具体的には、ある種のツール・コールは、ループから飛び出したり、人間が応答するのを待ったり、別の長時間実行タスク(例えばトレーニング・パイプライン)を待ったりする理由になるかもしれない...。

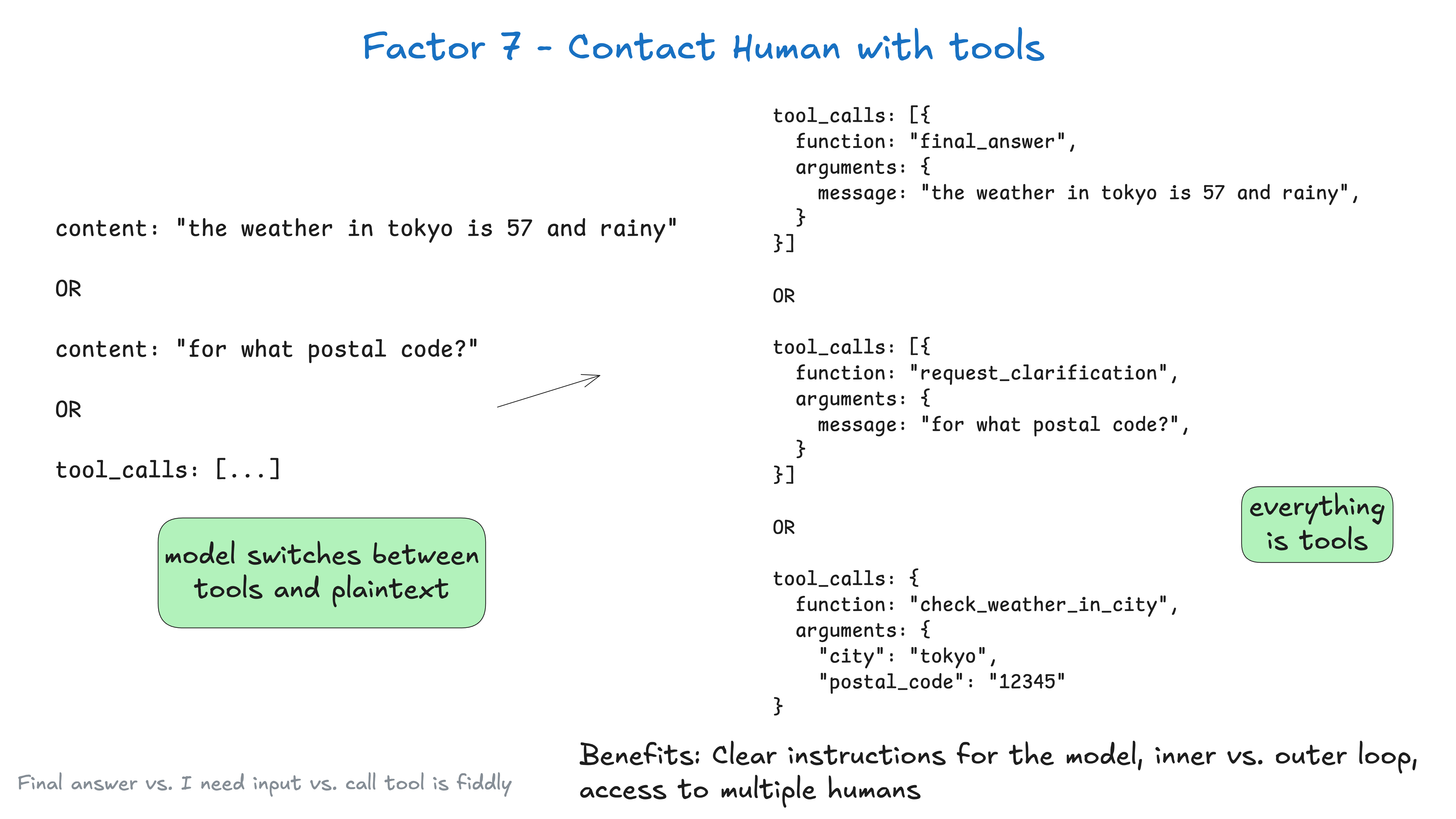

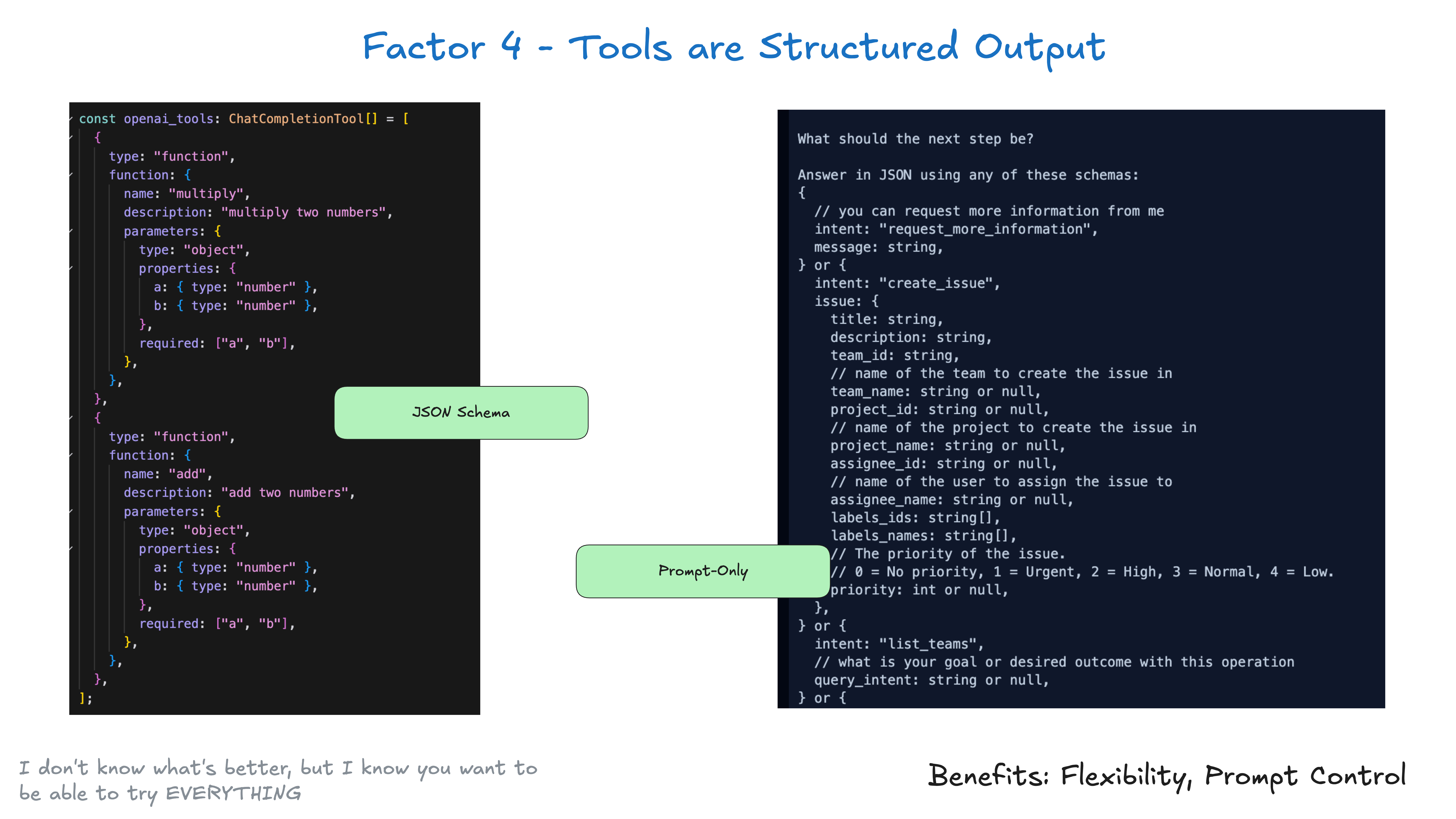

デフォルトでは、ラージ・ランゲージ・モデル(LLM)APIは、基本的にステークスの高いトークンの選択に依存している:プレーン・テキストのコンテンツを返すのか、それとも構造化データを返すのか? あなたは最初のトークンの選択に重きを置いていますが、それは東京の天気の場合...

インテリジェンスはプログラムであり、何らかの方法で起動、クエリ、再開、停止できることが期待される。 ユーザー、アプリケーション、パイプライン、その他のインテリジェンスは、シンプルなAPIで簡単にインテリジェンスを開始できるはずだ。 長時間実行されるオペレーションが必要な場合、インテリジェンスとそのオーケストレーションの決定論的コード...

AIの分野以外でも、多くのインフラシステムは「実行状態」と「ビジネスの状態」を分離しようとしている。AIアプリケーションの場合、これは現在のステップ、次のステップ、待機状態、再試行などの情報を追跡するための複雑な抽象化を伴うことがある。この分離は複雑さをもたらし、価値があるかもしれないが、...

ツールは複雑である必要はない。ツールの核心は、ラージ・ランゲージ・モデル(LLM)からの構造化された出力が、決定論的なコードをトリガーするために使用されることだ。 例えば、CreateIssueとSearchIssueの2つのツールがあるとします。ラージ・ランゲージ・モデル(LLM)に「複数のツールのうちの1つを使用する」ように要求することは、実際には...を出力するように要求することです。

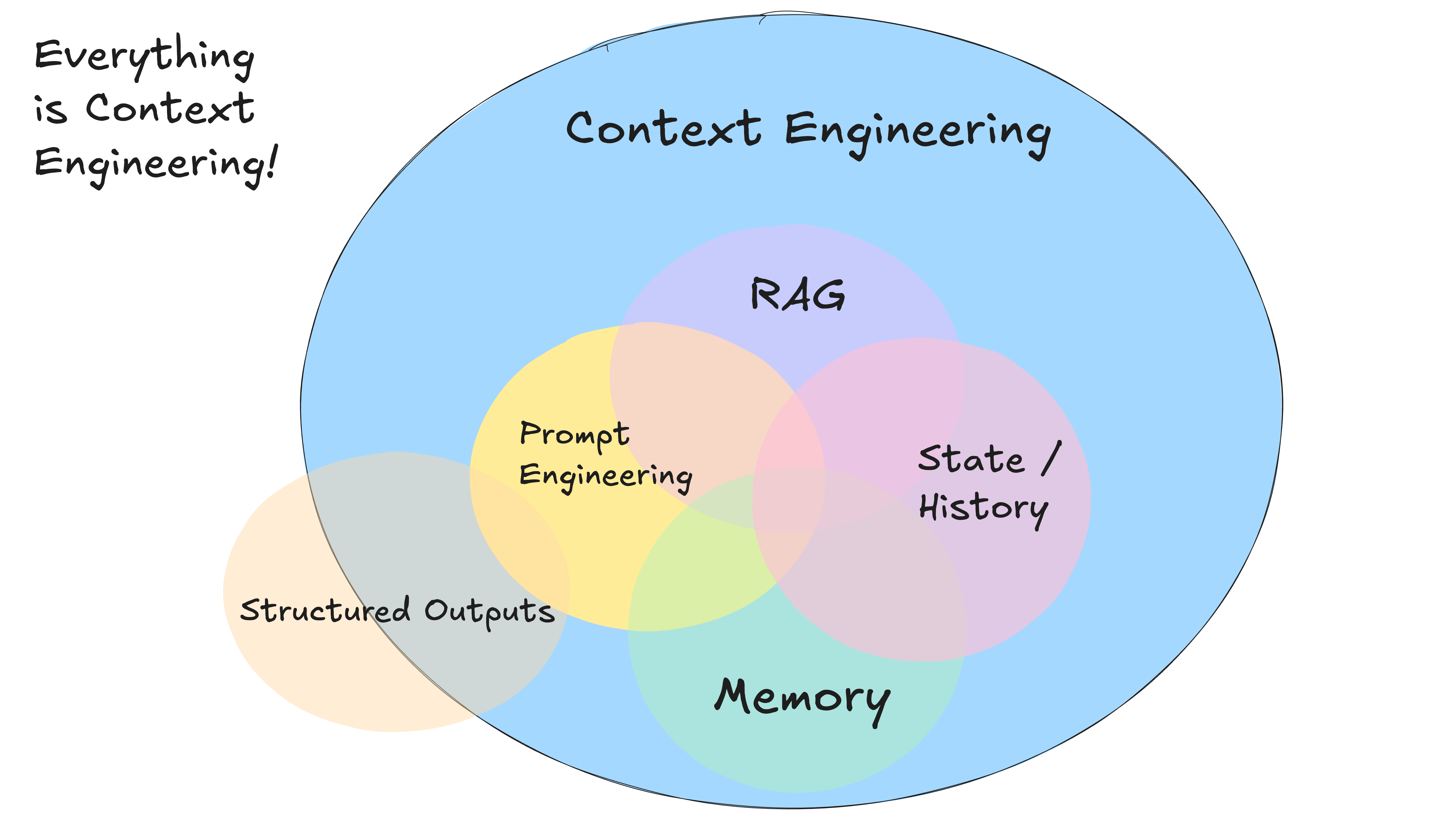

ビッグ・ランゲージ・モデルにコンテキストを伝えるのに、標準化されたメッセージベースのフォーマットを使う必要はない。 どんな瞬間でも、AIインテリジェンスの大きな言語モデルへの入力は、「これまでに起こったことすべてと、次にすべきことはこれです」というものだ。 大きな言語モデルは...

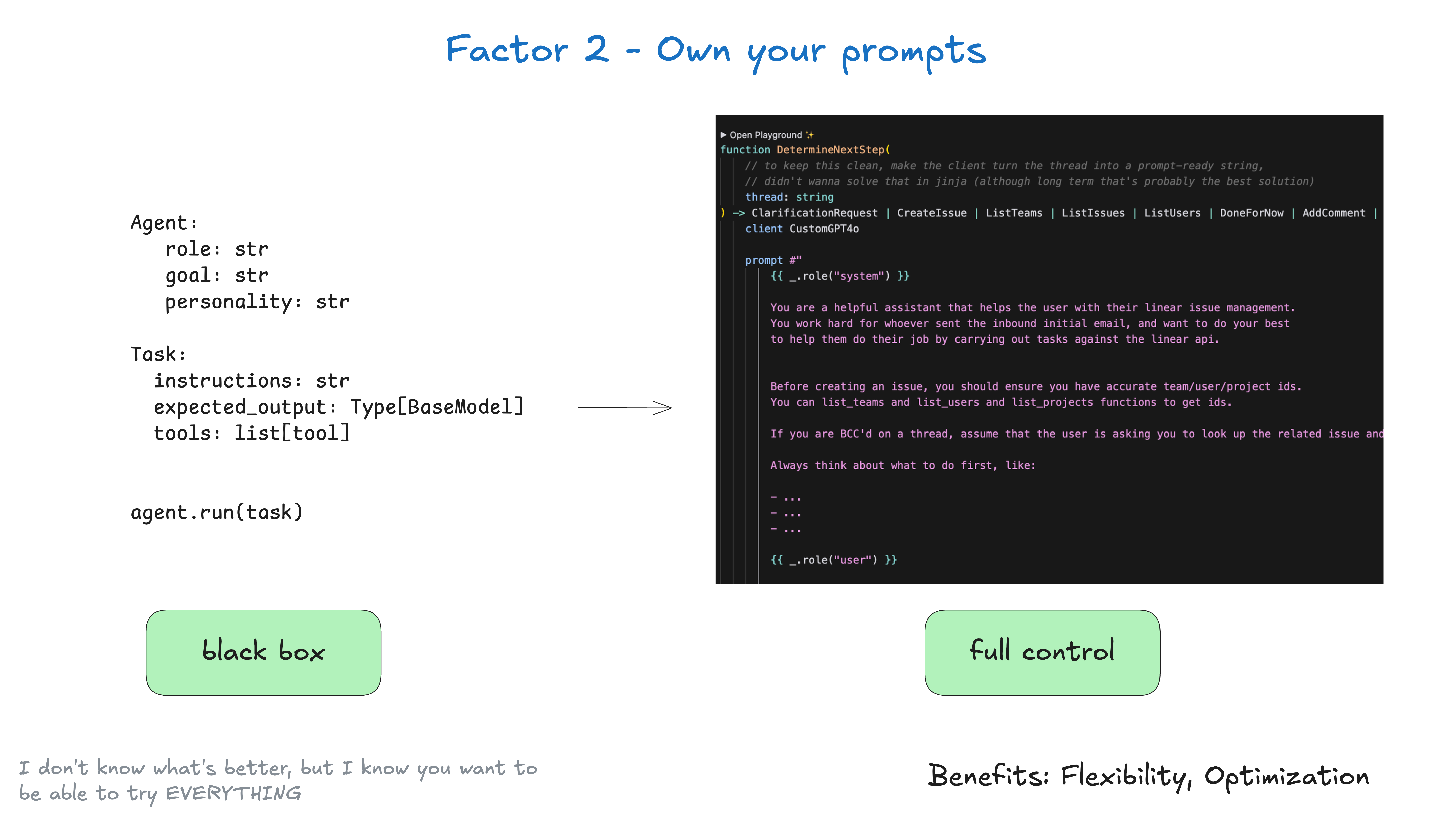

入力プロンプトのエンジニアリングをフレームワークにアウトソーシングしてはいけません。 ちなみに、これは斬新なアドバイスとは言い難い。いくつかのフレームワークは、次のような「ブラックボックス」的なアプローチを提供している:agent = Agent( role="..." , goal="...")ゴール="..."パーソナリティ="..."ツール=...

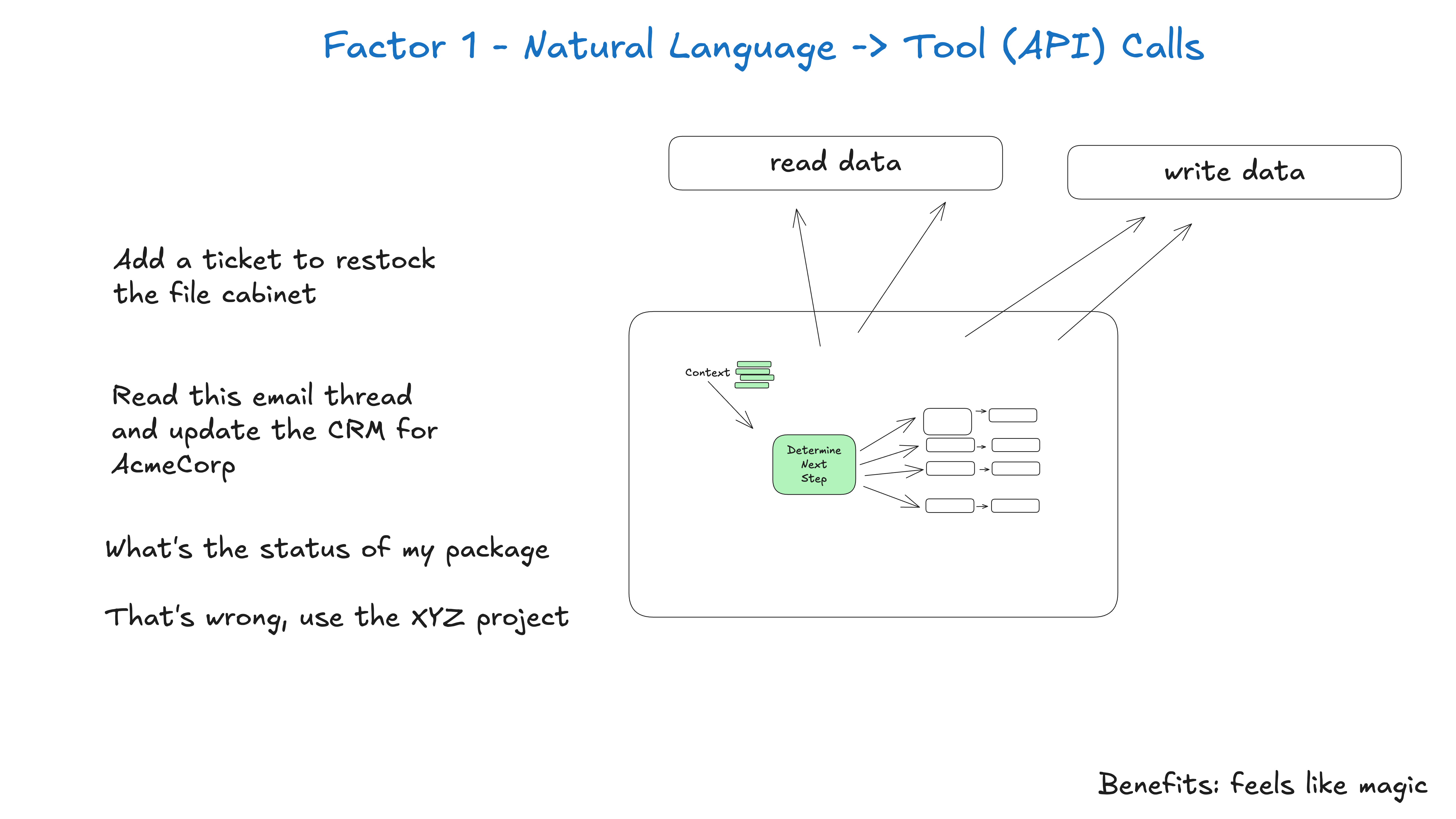

インテリジェンスを構築する際の最も一般的なパターンの1つは、自然言語を構造化されたツール呼び出しに変換することである。これは、タスクを推論して実行できるインテリジェンスを構築できる強力なパターンです。 このパターンをアトミックに適用すると、Ter...

詳細版:ここまでの経緯 私の話を聞く必要はない インテリジェンスに初めて触れる人も、私のような不機嫌なベテランも、AIインテリジェンスに関する既存の見解のほとんどを捨て、一歩引いて、第一原理から考え直すよう説得しようと思う。 (...として

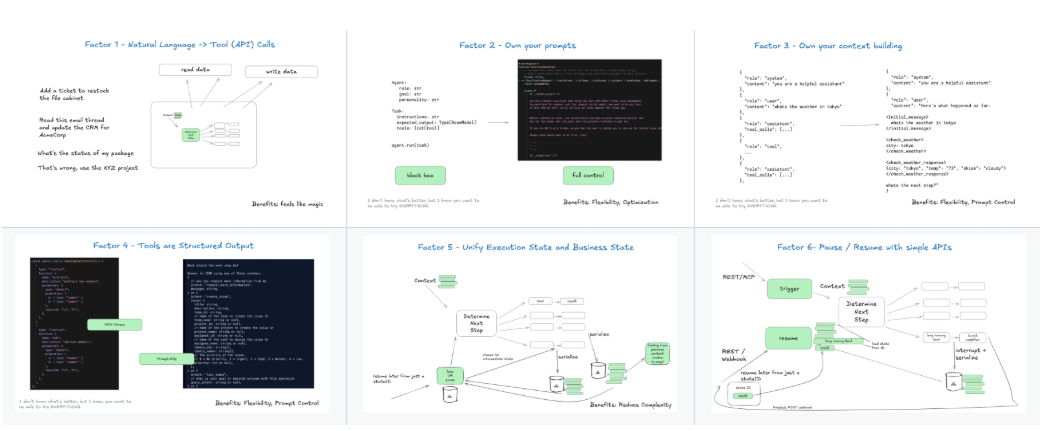

包括的な紹介 "12-Factor Agents "は、特定のソフトウェア・ライブラリやフレームワークではなく、信頼性が高く、スケーラブルで、メンテナンスが容易なLLM(大規模言語モデル)アプリケーションを構築するための設計原則のセットである。このプロジェクトは、開発者のDexによって始められた。Dexは、多くのチームが既存のAIを賢 ... 続きを読む

FineTuningLLMs は、著者の dvgodoy さんの著書 A Hands-On Guide to Fine-Tuning LLMs with PyTorch and Hugging Face に基づいて作成された GitHub リポジトリです。このリポジトリは...

トップに戻る