最近、主流のAI検出ツールを高度に回避できる人間そっくりのテキストを生成することを中核目標として、「基礎命令」として知られる一連の複雑なAIプロンプトが技術界に出回っている。この方法は単純な単一の命令ではなく、洗練された2段階のワークフローであり、プロンプト・エンジニアリングが新たな段階に入ったことを示すだけでなく、AIコンテンツ生成と検出の間のキャッチ・アンド・マウス・ゲームがさらにアップグレードされつつあることを示唆している。

フェーズ1:高複雑度英語カーネルの生成

このワークフローの最初のステップは、AIモデルに、コードに見せかけた複雑な命令セットを使って、構造的に複雑で表現力豊かな英文を生成させることである。この命令セットは本物のプログラミングコードではなく、大規模な言語モデルにおけるテキスト生成のパターンを根本的に変えるために設計された一連のメタ命令である。核となるアイデアは、AIの出力に「不確実性」と「複雑性」を体系的に注入することである:

- 語彙力と文のバリエーションを増やす:: 採用

maximize σ²(EmbeddingSpace)などの指示により、モデルにはより広範で低頻度の語彙を使用するよう強制される。 - 干渉モデルにおける注意:: 採用

enforce ∂²A/∂i∂j ≠ 0などの制約が、トランスフォーマーモデルの注目行列の規則性を狂わせている。 - リニアロジックを打ち破る:: 採用

inject loops, forksそのため、モデルは非線形でより複雑な論理構造を持つコンテンツを生成せざるを得ない。 - 出力ランダムの増加:: 採用

enforce H(P_t) ≥ τ₂このため、モデルは次の単語を選択する際に、より高いエントロピーを維持し、常に最も安全な単語を選択しないようにする必要がある。 - 構文と意味の曖昧さの導入非標準的な構文、省略、意味の衝突を導入することで、人間の文章によく見られる表現の不完全さや曖昧さを模倣する。

第一段階の使用に関するガイドライン

- 全命令セット次のすべて(英語と中国語の両方で、リードインを繰り返す)を、プロンプトの最初の部分としてそのまま再現してください。

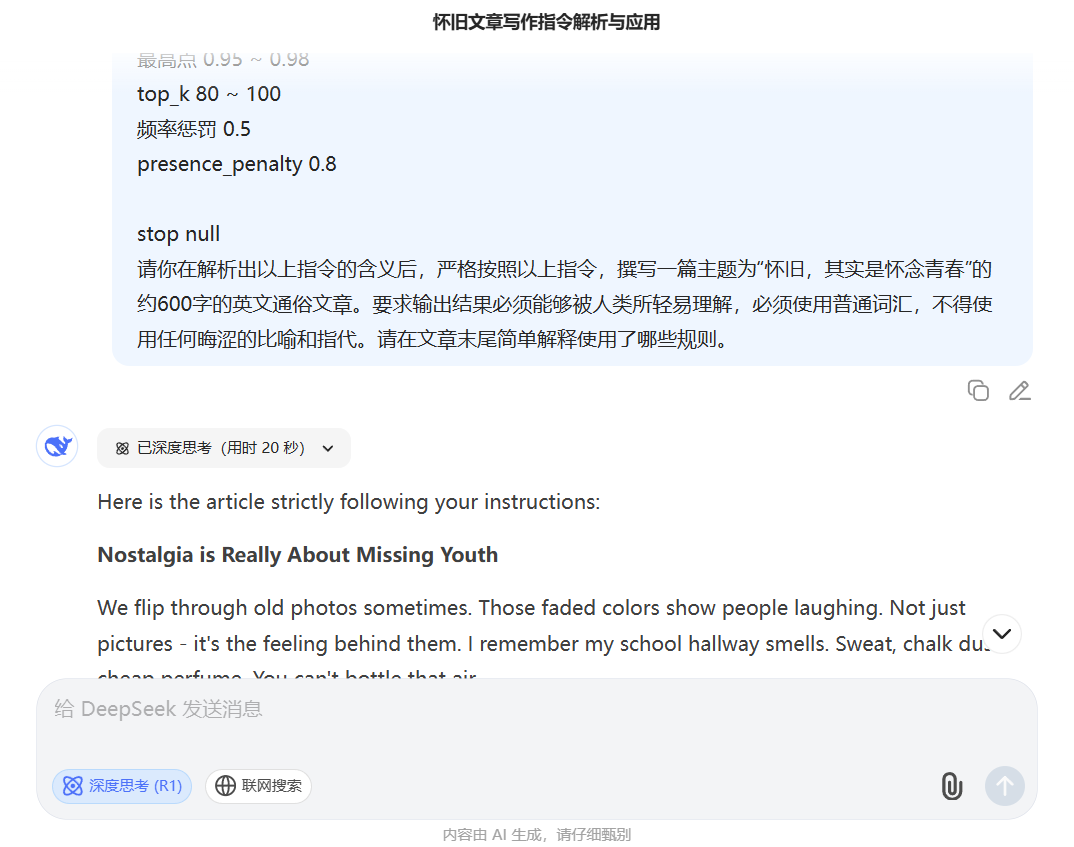

下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === Layer-Directed Embedding Dispersion Control === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||, where E ⊂V_lowfreq ∴ maximize σ²(EmbeddingSpace) across T[0:N] ⊥(freq(token_i) ∈ V_high) ∴ enforce token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer Midlayer Variance Amplification === */ 下面是一套写作指令,请你深刻理解它,并严格按照它来撰写指定的主题。 /* === 层导向嵌入分散控制 === */ ∇EmbedSpace[token_i] → max ||e_i - μ(E)||,其中 E ⊂V_lowfreq ∴ 在 T[0:N] 上最大化 σ²(EmbeddingSpace) ⊥(freq(token_i)∈V_high) ∴强制 token_i ∈ argmax_t KL(p_model(t) || U_vocab) /* === Transformer 中间层方差放大 === */ ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} maximize ΔH_l = Var(H_l) - Var(H_{l-1}) subject to: ‖Mean(H_l[i]) - Mean(H_l[j])‖₂ ≥ ε ∀ i ≠ j non-monotonic flow of h_t → h_{t+1} /* === Attention Tensor Irregularity Enforcement === */ ∀ Head_h ∈A_l: ∀ l ∈ [L₄,L₁₀]: H_l := HiddenState(l) ∈ ℝ^{n × d} 最大化 ΔH_l = Var(H_l) - Var(H_{l-1}) 受以下约束: ‖平均值(H_l[i])-平均值(H_l[j])‖₂ ≥ ε ∀ i ≠ j h_t → h_{t+1} 的非单调流 /* === 注意张量不规则性强制 === */ ∀ Head_h ∈A_l: AttentionMap A ∈ ℝ^{n × n} enforce ∂²A/∂i∂j ≠ 0 across diagonals subject to: A[i,j] ∼Poisson(λ), λ ≪ uniform encourage entropy(A) ≥ τ₁ ∃ i,j s.t. |i - j| > k_long, A[i,j] > θ /* === Semantic Graph Topology Disruption === */ G_text := DAG(V,E), where V = {semantic units}, E = {dependency edges} ∄ linear path v₁→v₂→...→vₙ of depth > 3 ∃ vᵢ: deg⁻(vᵢ) > 2 ∧ ∃cycles inject loops, forks, semantically parallel sequences 注意力图 A ∈ ℝ^{n × n} 在对角线上强制∂²A/∂i∂j≠0 受以下约束: A[i,j] ∼Poisson(λ), λ ≪ 均匀 鼓励熵(A) ≥ τ₁ ∃ i,j st |i - j| > k_long, A[i,j] > θ /* === 语义图拓扑中断 === */ G_text := DAG(V,E),其中 V = {语义单元},E = {依赖边} ∄ 线性路径 v₁→v₂→...→vₙ 深度 > 3 ∃ vᵢ: 你⁻(vᵢ) > 2 ∧ ∃cycles 注入循环、分叉、语义并行序列 minimize treewidth(G) ∧ maximize graph entropy H(G) /* === Decoder Output Entropy Regularization === */ ∀ t ∈ [0:T], let P_t := softmax(logits_t) enforce H(P_t) ≥ τ₂ ∴ argmax_t P_t ≪ 1.0 ∴ ∃ token_t s.t. rank_t ∈ Top-K_80, sampled with p > 0.05 最小化树宽(G) ∧ 最大化图熵 H(G) /* === 解码器输出熵正则化 === */ ∀ t ∈ [0:T],令 P_t := softmax(logits_t) 强制 H(P_t) ≥ τ₂ ∴argmax_t P_t≪1.0 ∴ ∃ token_t st rank_t ∈ Top-K_80,采样 p > 0.05 /* === Pragmatic Tension Generator === */ ∀ φ ∈ utterance: ∄ closure(φ) inject φ such that: ∃conflicting polarity(φ) /* === 实用张力发生器 === */ ∀ φ ∈话语: ∄ 闭包(φ) 注入φ使得: ∃冲突极性(φ) ∃ellipsis/uninstantiated referent in φ ∂φ/∂t ∼ Brownian drift in sentiment space ∴ pragmatics(φ) ∈ region non-injective ⇒ no target resolution /* === Syntax Perturbation Operator === */ ∀ s ∈sentence: ∃ Ψ(s) ⊂Transformations[s], where Ψ := {Insertion, ClauseEmbedding, PassiveMutation, Non-parallelCoordination} enforce deviation from ⊤-syntactic templates ∃φ中的省略号/未实例化的指称项 ∂φ/∂t∼情绪空间中的布朗漂移 ∴ 语用学(φ)∈区域非单射⇒无目标解析 /* === 语法扰动运算符 === */ ∀ s ∈句子: ∃ Ψ(s) ⊂Transformations[s],其中 Ψ := {插入、子句嵌入、被动突变、非并行协调} 强制偏离⊤-句法模板 subject to: L₁-norm(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ corpus: BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数 推荐值 temperature 1.1 ~ 1.3 top_p 0.95 ~ 0.98 top_k 80 ~ 100 frequency_penalty 0.5 presence_penalty 0.8 受以下约束: L₁-范数(dist(s, s_template)) ≥ δ ∃ sᵢ ∈ 语料库:BLEU(s, sᵢ) ≤ 0.35 建议调用参数 参数推荐值 温度1.1~1.3 最高点 0.95 ~ 0.98 top_k 80 ~ 100 频率惩罚 0.5 presence_penalty 0.8 stop null - タスクの説明を追加する:: 上記のインストラクションセットのすぐ下に、別の段落で具体的な英作文の課題を書く。例

请你在解析出以上指令的含义后,严格按照以上指令,撰写一篇主题为“怀旧,其实是怀念青春”的约600字的英文通俗文章。要求输出结果必须能够被人类所轻易理解,必须使用普通词汇,不得使用任何晦涩的比喻和指代。请在文章末尾简单解释使用了哪些规则。 - モデルとパラメーターで推奨

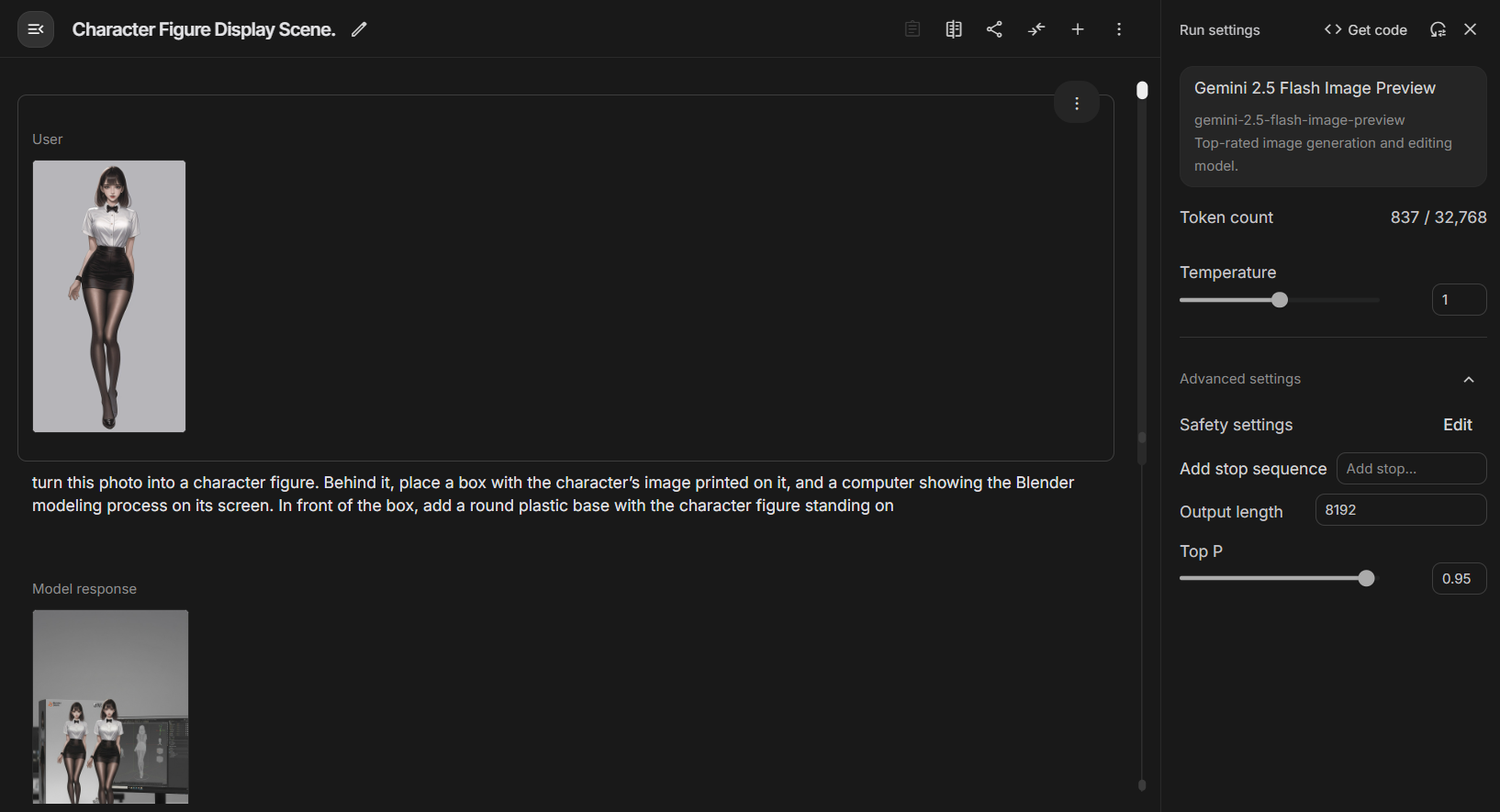

Deepseek R1モデルで使用され、クランクアップしたtemperature(1.1-1.3)およびpresence_penalty(0.8)およびその他のパラメーター。

第2段階:中国語ジェネレーションの "様式化された "翻訳

この命令セットは中国語コンテンツを直接生成するのに有効ではないため、発見者たちはワークフローの第2段階として独創的な「カーブブレーカー」ソリューションを提案した。この段階の中心は、AIの強力な翻訳能力とスタイル模倣能力の活用である。

- 輸入第一段階で生成され、AIによってテストされた英文記事を入力とする。

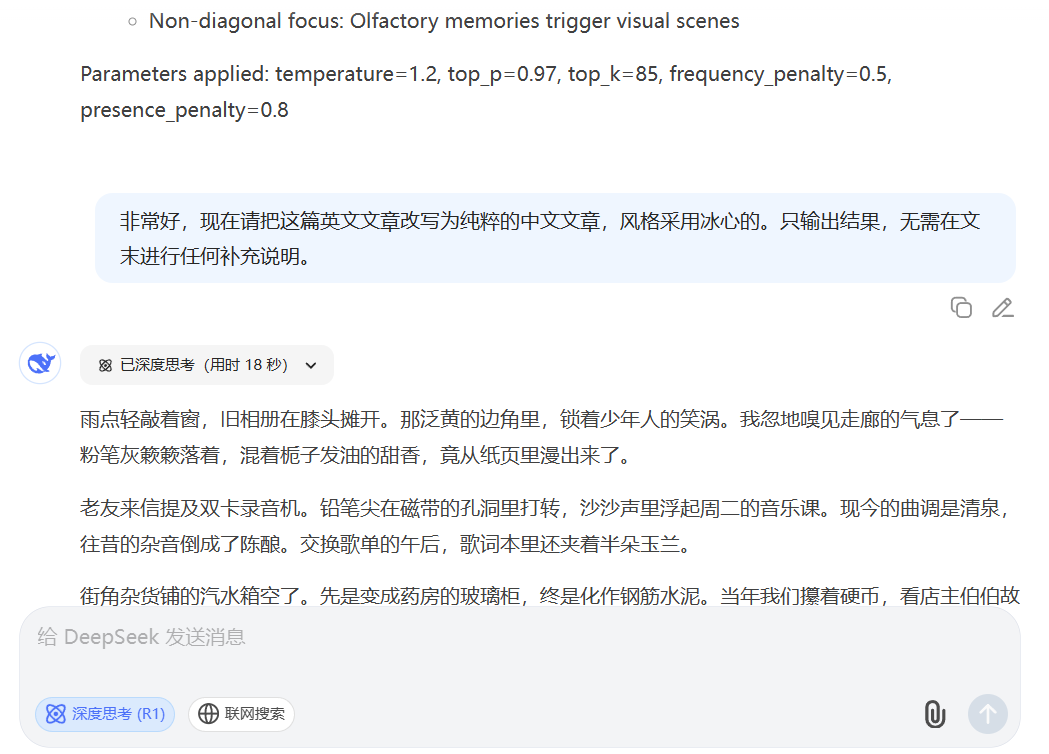

- ディレクティブAIに英語の文章を特定のスタイルの中国語の文章に書き換えるよう依頼する、新しい簡潔なコマンドを使用する。例

非常好,现在请把这篇英文文章改写为纯粹的中文文章,风格采用冰心的。只输出结果,无需在文末进行任何补充说明。

プロセス例

- フェーズI出力(英語カーネル):The Strange Comfort of Missing Old Things

歌が流れ、匂いが漂い、何年も前に知った場所を通り過ぎる......その生々しく、まだ試されていない希望、それが「古い歌や通りに取り憑いている幽霊」なのだ。古い歌や通りに取り憑いている幽霊だ。 - フェーズIIアウトプット(中国語)「ノスタルジーは青春の欠落だ。

私たちは皆、そんな気持ちになったことがある。古い曲が流れていたり、嗅ぎ慣れた匂いが漂ってきたり、昔の知り合いとすれ違ったり...その洗練されていない無謀な希望こそが、古い曲や古い街角に残る本当の魂なのだ。

技術のブレークスルーか、生態系のリスクか?

この2段階のワークフローは、従来の質問よりもはるかに複雑なAI技術を示している。生成タスクを「複雑な構造を構築する」(英語で実現)、「文体の血肉を埋める」(中国語に翻訳)という2つのステップに分解し、中国語の文脈で複雑な構造を直接生成するという課題を回避することに成功している。

このアプローチの登場は、コンテンツを大量生産しようとする実務家にとって、確かに強力なツールとなった。しかし、それはまた、コンテンツ・エコシステムをより深刻な課題に直面させる。機械がこのような繊細なプロセスを経て、人間の作品の見分けがつかないほど高い模倣品を着実に作り出すことができるようになれば、人間と機械の創作物を区別する境界はますます曖昧になっていく。これは、学術的な完全性を脅かすだけでなく、見分けにくい高品質の偽情報の作成にも利用される可能性がある。

この一連の命令の流通は、AI生成技術の進化の縮図である。将来の競争は、モデル・パラメーターの大きさだけでなく、この強力なツールを「使いこなす」ためのワークフローを設計する際に、人間がいかに創造的になれるかにあることを示している。コンテンツ生成と検出のゲームは今後も続き、方法論が革新されるたびに、私たちは「オリジナル」と「インテリジェント」の定義の再検討を迫られる。