グーグルのチーフ・サイエンティストが Jeff Dean 兼AIインフラストラクチャー担当バイスプレジデント Amin Vahdat 共同署名者が技術報告書を発表したとき、業界全体が耳を傾けた。報告書の核心的なメッセージは、非常に分かりやすい比喩でパッケージ化されていた。 Gemini は、9秒間のテレビを見るよりも消費電力が少ない、テキストによる指示をモデル化した。

この例えは鮮明で親近感が湧き、1回のAIとの対話にかかるコストが取るに足らないものであることを巧みに描写している。しかし、このようなミクロな視点は、業界のリーダーたち自身によって支持されているが、世界規模でのAI技術の驚異的なエネルギー需要を裏付けている。わずか1回の消費量に天文学的な数の日々のクエリーが掛け合わされると、話はまったく違ってくる。

なぜ「中央値」なのか?正直か偏見かの選択

その前に、なぜグーグルが「テキストクエリの中央値」を中核指標に選んだのかを理解することが重要だ。"2+2は何回になりますか?"のような簡単な質問から、数千語のエッセイを書く必要がある複雑なタスクまで、AIとユーザーとのやり取りはすべて、エネルギー消費量が劇的に変化する。 のような単純な質問から、数千語のエッセイを書くような複雑なタスクまで、AIとユーザーとのインタラクションのたびに、エネルギー消費量は劇的に変化する。

平均値を使用した場合、少数の極端に複雑なクエリが全体の値を劇的に増加させる可能性があり、それによって平均的なユーザーの毎日の使用の真のコストが歪められる。対照的に、中央値は、スペクトルの両端における異常値を排除し、典型的なクエリのエネルギー消費量をよりよく代表します。レポートでは、中央値 Gemini テキストクエリの消費 0.24ワット時(Wh) のエネルギー、0.03グラムのCO2を排出し、0.26ミリリットルの水を使用する。グーグルは、業界大手のハイテク企業がビッグ・ランゲージ・モデルの使用コストをこれほど詳細に公表したのはこれが初めてだと強調している。

グーグルの「フルスタック・アルゴリズム」:単なる計算原料ではない

このレポートのもうひとつの目玉は、「フルスタック」測定アプローチである。グーグルは、多くの一般的な試算ではAIアクセラレーター(例えば TPU 或 GPUアクティブ・コンピューティング中の消費電力は、真のコストを著しく過小評価している。

例えるなら、この楽観的アルゴリズムは、小麦粉とトマトだけを数えてピザの原価を計算するようなものだ。

そして、グーグルの「フルスタック・アルゴリズム」はすべてのコストを考慮する:

- システム全体の消費電力これにはAIチップだけでなく、その動作を支えるホストサーバー、CPU、メモリーも含まれる。

- 待機中のアイドルシステムトラフィックのピークに対応するために待機しているサーバーが消費するエネルギー。

- データセンターのオーバーヘッドエネルギー効率の測定

PUE(電力使用効率)の測定基準には、冷却システムや配電などの追加消費もすべて含まれる。グーグルは、自社のデータセンターの平均消費電力は以下のとおりだと主張している。PUE1.09と、業界をリードする水準にある。

より包括的なこのアルゴリズムではGemini 1回のクエリーで0.24ワット時のエネルギーを消費する。グーグルは、チップの消費電力のみをカウントするという業界の狭いアプローチを採用すれば、この数字は簡単に0.10ワットアワーまで削減できると認めている[3]。[3]この動きは、データの透明性と誠実さを誇ると同時に、競合他社にプレッシャーをかける試みであることは間違いない。

効率性飛躍の裏側

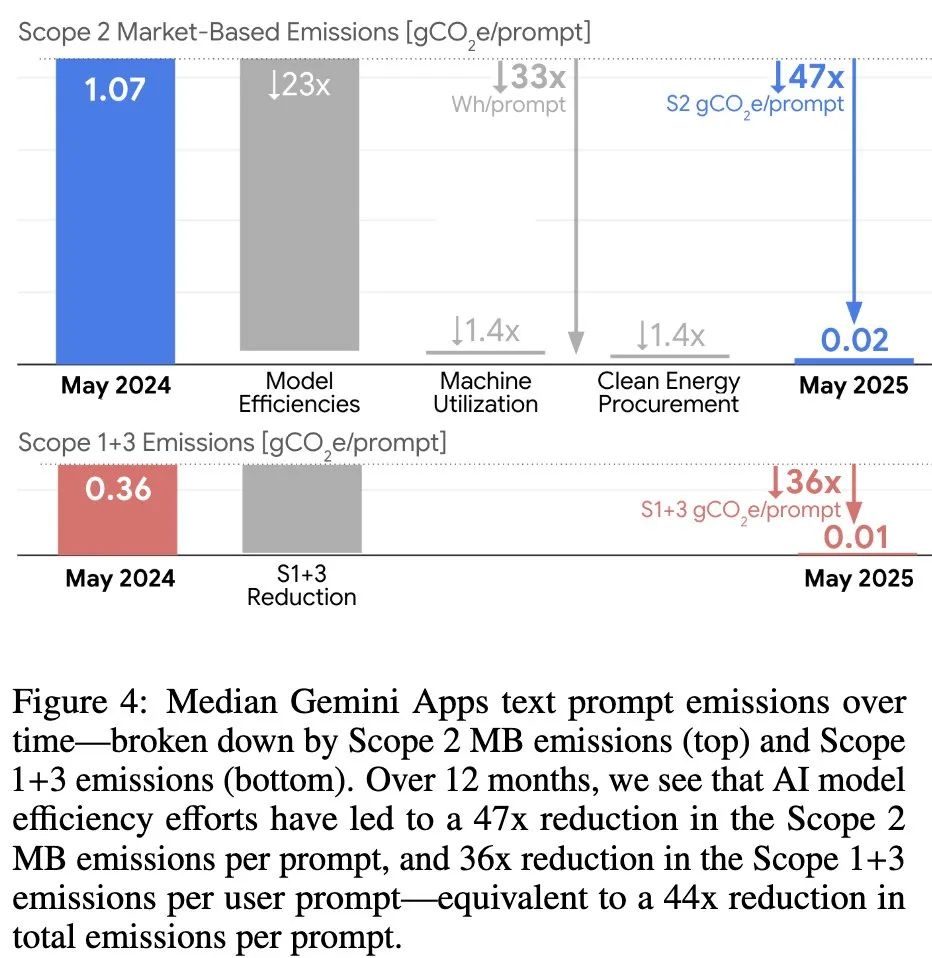

この報告書はまた、次のことも強調している。 Gemini 過去1年間の驚異的な効率向上:高品質のレスポンスを提供しながら、クエリあたりのエネルギー消費量を削減 33回カーボンフットプリントの削減 44回。

この飛躍は、単一のテクノロジーにおけるブレークスルーではなく、モデル・アーキテクチャからハードウェアまであらゆる側面をカバーする「フルスタック最適化」戦略の結果である:

- 効率的なモデル・アーキテクチャ採用

Mixture-of-Experts (MoE)このようなアーキテクチャーにより、モデルはリクエストの処理に必要な「エキスパート」ネットワークの部分のみをアクティブにすることができるため、計算量を10~100分の1に減らすことができる。 - 最適化されたアルゴリズム定量化を通じて(

Quantization)と蒸留(Distillation)などのテクニックを使って、品質をあまり犠牲にすることなく、より小さく、より速いバージョンのモデルを作成することができる。 - 知能推論システム利用

speculative decoding(投機的復号化)などの技術により、小さなモデルが最初に予測を行い、それを大きなモデルが素早く検証することで、応答効率が劇的に向上する。 - カスタマイズされたハードウェアグーグル自社開発

TPU(テンソル・プロセッシング・ユニット)AI操作のためにゼロから最適化され、非常に高いエネルギー効率比を達成している。

公平を期すなら、グーグルはAIによる1回のクエリにかかるコストを削減したエンジニアリングの功績は称賛に値する。しかし、1回のクエリの「9秒」を超えて見てみると、まったく異なる姿が浮かび上がってくる。

マクロの視点:「9秒」が「285年」になるとき

9秒テレビ」の例えは、小さなコストに対する人間の感覚を利用したもので、賢い。しかし、本当のテストは規模である。

現在のところ Gemini 世界的な1日のクエリー数についての公式な数字はないが、業界では控えめな2,800万から楽観的な10億までと推定されている。この2つの数字をそれぞれ使って計算してみましょう。

シナリオ1:10億クエリ(楽観的予測)

- 1日の総エネルギー消費量10億サイクル×0.24ワット時/サイクル=2億4,000万ワット時、すなわち24万キロワット時(kWh)。

- どういう意味ですか?インドの平均的な家庭では、1日に約3kWhの電力を使用する。つまり

Gemini1日分のエネルギー消費で、次のようなことが可能である。 8万ドルだ。 インドの家庭における1日の電力消費量。 - 比喩を変えよう。不眠不休で見続けているようなものだ。 285年 テレビだ。

シナリオ2:2,800万クエリ(保守的な見積もり)

- 1日の総エネルギー消費量2800万回×1回あたり0.24ワット時=672万ワット時、6720キロワット時(kWh)。

- どういう意味ですか?それでもね。

Gemini一日分のエネルギーだ。 2240 インドの家庭用。 - 比喩を変えよう。の連続を見るに等しい。 8年 テレビだ。

どのようなシナリオであれ、ひとつの行為が些細なことのように見えても、ひとたびグローバル化という壮大なスケールの上に置かれれば、その真のインパクトは目を見張るものがあるという現実が、この計算によって明らかになった。

真の課題は、爆発的な需要増に効率向上が追いつくか?

グーグルはこの報告書によって、「クエリごとのコスト」という技術的な問題を解決したことを証明し、他社にボールを蹴るつもりである。しかし、これは業界全体が直面している深いジレンマを的確に回避している。

真の課題は、単一のクエリを最適化するためのわずかなコストをはるかに超えたところにある。むしろ、AIサービスが検索、電子メール、さらにはオペレーティング・システムにまで完全に統合され、クエリの量が数十億から数千億へと増加するにつれて、持続可能なエネルギー源でこの指数関数的な需要の増加にいかに対応するかということだ。

技術の進歩は効率性をもたらすが、効率性の向上は幅広い応用を刺激し、総需要の爆発的増加につながる。これは古典的な "ジェヴォンズのパラドックス "である。グーグルはデータセンターの建設に取り組んでいると主張している。 年中無休のカーボンフリー・エネルギー を補完することを約束する。 120% の真水消費量に相当する。しかし、世界的に見れば、特にエネルギーミックスがまだ完全でない地域では、新しいデータセンターが送電網に大きな負担をかけることに変わりはない。

テック業界の巨人たちがAIがどのように世界を変えるかについて話している一方で、何がこの再構築された世界を動かすのかについて率直に議論する方が適切かもしれない。

参考:https://arxiv.org/abs/2508.15734