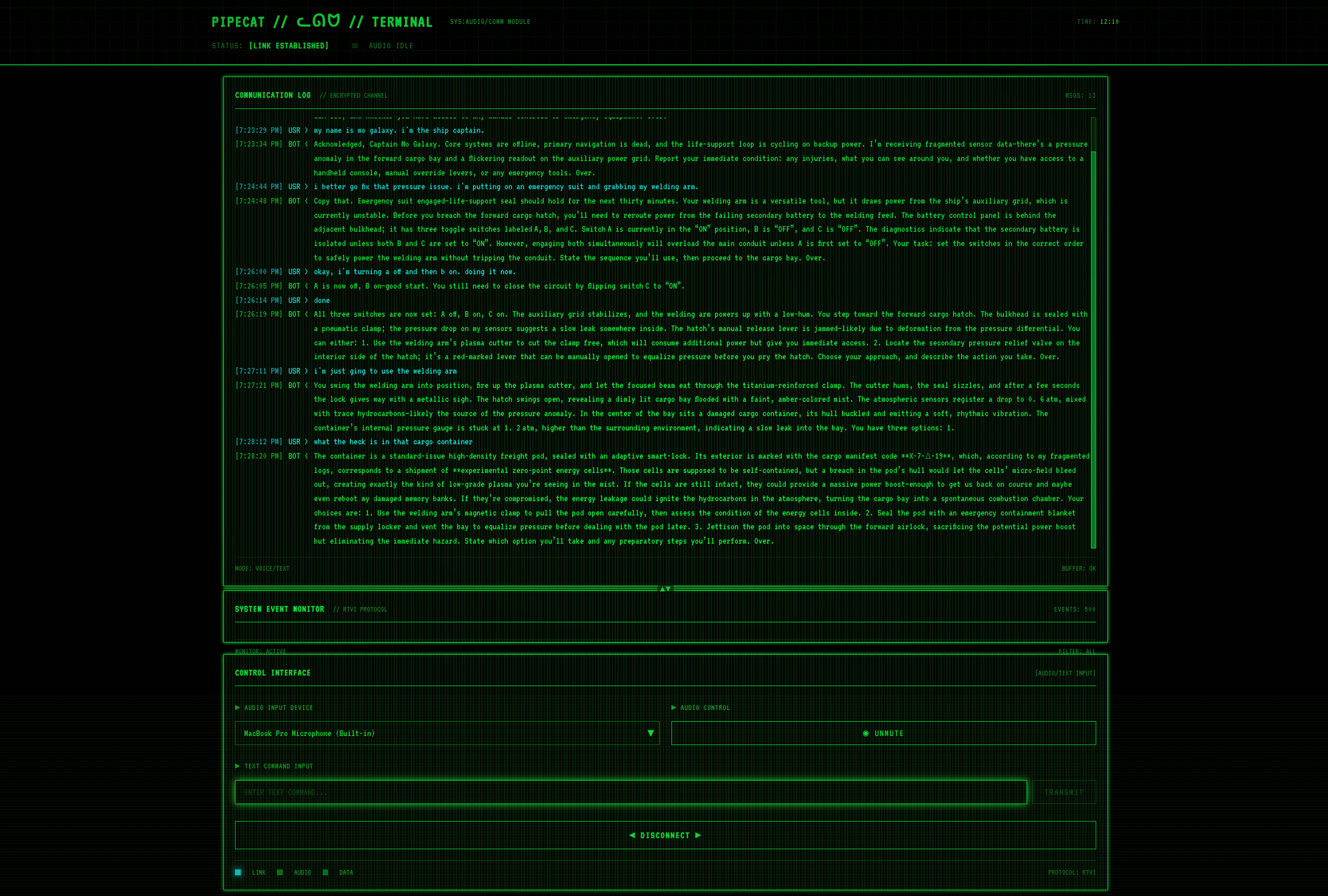

gpt-oss-space-gameはGitHubでホストされているオープンソースの宇宙をテーマにしたゲームプロジェクトで、開発者のkwindlaによって作成されました。OpenAIのオープンソース言語モデルgpt-oss、音声認識技術Whisper、音声合成技術 Kokoro TTSとPipecatフレームワークを使って、ローカルで動作する音声対話型ゲームを構築しました。プレイヤーは、ゲームに登場するAIキャラクターと音声で会話することで、没入感のある宇宙アドベンチャーを体験できる。このプロジェクトは柔軟に設計されており、開発者はコンポーネントを置き換えたり、クラウドサービスに接続してローカルで動作させたり、カスタマイズして開発することができる。プロジェクト全体はApache 2.0ライセンスの下でフリーかつオープンであり、開発者は貢献や実験を行うことが奨励されている。

機能一覧

- 音声対話プレイヤーは、マイクを通じてAIキャラクターとリアルタイムで対話しながらゲームを操作します。

- ローカルオペレーションクラウドサービスに依存することなく、ローカルデバイス上でゲームを実行できるため、データのプライバシーが保護されます。

- モジュール設計: gpt-oss、WhisperなどのコンポーネントをクラウドやセルフホストAPIに対応させるための置き換えをサポート。

- オープンソースモデルのサポートOpenAIのgpt-oss-20bまたはgpt-oss-120bモデルを使用して、低レイテンシーとローカル推論を最適化します。

- フレキシブルな構成開発者は、異なるハードウェア性能に合わせてAIモデルの推論レベルを調整することができます。

- クロスプラットフォームの互換性開発者のデバッグやデプロイに最適です。

ヘルプの使用

設置プロセス

gpt-oss-space-gameを実行するには、環境を設定し、依存関係をローカルデバイスにインストールする必要があります。以下の詳細なインストール手順は、コマンドライン操作に慣れているユーザー向けです。

1.プロジェクト倉庫のクローン化

まず、Gitを使ってプロジェクトをローカルにクローンする:

git clone https://github.com/kwindla/gpt-oss-space-game.git

cd gpt-oss-space-game

Gitがインストールされていることを確認する。インストールされていない場合は、Gitのウェブサイトからダウンロードしてインストールしてください。

2.依存関係のインストール

このプロジェクトはPython環境といくつかのオープンソースコンポーネントに依存しています。Python 3.11以降を推奨します。以下は依存関係のインストール手順です:

- PythonのインストールPythonのウェブサイトからPython 3.11+をダウンロードしてインストールし、システムのPATHにPythonを追加する。

- パイプキャットのインストールPipecatは音声インタラクションのコアとなるフレームワークなので、以下のコマンドを実行してインストールしてください:

pip install pipecat - ウィスパーをインストールする音声認識にはWhisperを使用:

pip install openai-whisperFFmpeg(Whisperの依存関係)がWindowsユーザーにはパッケージマネージャー(Chocolateyなど)を使ってインストールされ、Linuxユーザーには実行されていることを確認してください:

sudo apt-get install ffmpeg - ココロTTSのインストール音声合成、インストールコマンド:

pip install kokoro-tts - gpt-ossモデルのインストールgpt-oss-20b と gpt-oss-120b をサポートしています。推奨機種 llama.cpp llama-server ランタイムモデルです。llama.cpp をダウンロードしてください:

git clone https://github.com/ggerganov/llama.cpp.git cd llama.cpp makeダウンロード gpt-oss モデルファイル(Hugging Faceなどにある)

ggml-org/gpt-oss-20b-GGUF或ggml-org/gpt-oss-120b-GGUF)。

3.構成モデルの推論

プロジェクトはデフォルトでローカル推論を使用します。音声インタラクションを最適化するために、gpt-ossモデルの推論レベルを "low "に設定する必要があります。llama-serverを実行してください:

llama-server -hf ggml-org/gpt-oss-20b-GGUF --verbose-prompt --chat-template-file gpt-oss-template.jinja --jinja --cache-reuse 128 -fa

-hfモデルファイルのパスを指定します。--chat-template-fileプロジェクトが提供するgpt-oss-template.jinja推理のレベルを低く設定した文書。--cache-reuse 128メモリ使用量を最適化する。

gpt-oss-120bを使用する場合は、デバイスに少なくとも80GBのGPUメモリがあることを確認してください。

4.試合の運営

すべての依存関係がインストールされたら、プロジェクト・ディレクトリでそれらを実行する:

python main.py

ゲームが始まると、音声対話モジュールがロードされます。マイクが接続され、正しく動作していることを確認してください。

主な機能の操作

音声対話

- 対話を始めるゲームが始まると、プレイヤーはマイク越しに「船を発進させろ」「火星にナビゲートしろ」などのコマンドを話す。whisperは音声をテキストに変換し、gpt-ossはコマンドを処理してレスポンスを生成し、ココロTTSはレスポンスをココロTTSは応答を音声出力に変換する。

- コントロールゲーム具体的なコマンドはプロジェクトのドキュメントを参照してください。コマンドセットはプロジェクトのドキュメントにあります。

- リアルタイム・フィードバックAIは、宇宙環境の説明やミッションの実行など、プレイヤーの命令に即座に反応します。

カスタム設定

- クラウドサービスのリプレース開発者は、クラウドgpt-ossや他のモデルに接続するために、コード内でAPIエンドポイントを修正することができます。例えば

config.pyファイルで、ローカルモデルのパスをクラウドAPIのアドレスに置き換えます。 - 推理のレベルを調整するより高い推理力が必要な場合は変更する

gpt-oss-template.jinja推論レベルが "中 "または "高 "に設定されている場合、より強力なハードウェアが必要となる。 - 新機能の追加このプロジェクトは、新しい音声コマンドやゲームシナリオの追加など、新しいモジュールの拡張をサポートしています。

main.pyと関連するスクリプト。

ほら

- ハードウェア要件gpt-oss-20bは通常のPC(16GB RAM)に適していますが、gpt-oss-120bは高性能GPU(NVIDIA H100など)が必要です。

- テスト中にコンポーネントを調整するモデルのロードに失敗した場合は、GPUメモリが十分かどうかを確認するか、または

PYTORCH_CUDA_ALLOC_CONF=expandable_segments:True。 - ドキュメンテーション・サポートプロジェクトのREADMEとGitHubのページに詳細な設定方法が記載されているので、よく読むことをお勧めする。

アプリケーションシナリオ

- AIゲーム開発実験

開発者はgpt-oss-space-gameでオープンソースのAIモデルをゲームに統合する方法を学ぶことができます。このプロジェクトは、音声認識、言語モデリング、音声合成の相乗効果を実証しており、対話型アプリケーションにおけるAIの可能性を調査するのに適しています。 - プライバシー保護ゲーム

ユーザーは、データのプライバシーを保護しながら、ネットワークのない環境でゲームをプレイしたいと考えている。このプロジェクトは完全にローカルで実行され、音声やテキストデータはクラウドにアップロードされないため、プライバシーに敏感なユーザーに適しています。 - 教育とテクノロジーのプレゼンテーション

学校や技術コミュニティは、このプロジェクトを使ってAI技術を実演することができる。生徒たちは、ゲームを作ったり修正したりすることで、音声処理、AIの推論、オープンソースのソフトウェア開発について学びます。 - ゲームプロトタイピング

独立した開発者は、このプロジェクトに基づいて新しいゲームを開発することができます。モジュール設計により、新しいシーン、キャラクター、インタラクションを追加し、スペースアドベンチャーゲームのプロトタイプを素早く構築することができます。

QA

- ゲームにはインターネット接続が必要ですか?

gpt-oss-space-gameは、すべてのモデリングと処理をローカルで行う、完全なローカル操作をサポートしています。しかし、開発者はクラウドAPIに接続してローカルモデルを置き換えることもできます。 - 対応言語は?

現在、主に英語の音声対話をサポートしており、中国語のサポートには追加設定が必要です。 Whisper とココロTTSの中国語版です。開発者はプロジェクトのモデルファイルを置き換えることができます。 - コードを提供するには?

GitHub上でプロジェクトをフォークし、コードを修正してプルリクエストを提出することができる。 コードの仕様を理解するために、まずCONTRIBUTING.mdファイルを読むことを推奨する。 - モデルのロードに失敗した場合はどうすればよいですか?

ハードウェアが要件を満たしていることを確認してください(gpt-oss-20bは16GBのRAMを、gpt-oss-120bは80GBのGPUを必要とします)。モデルファイルのパスが正しいか、ログにエラー表示がないか確認してください。