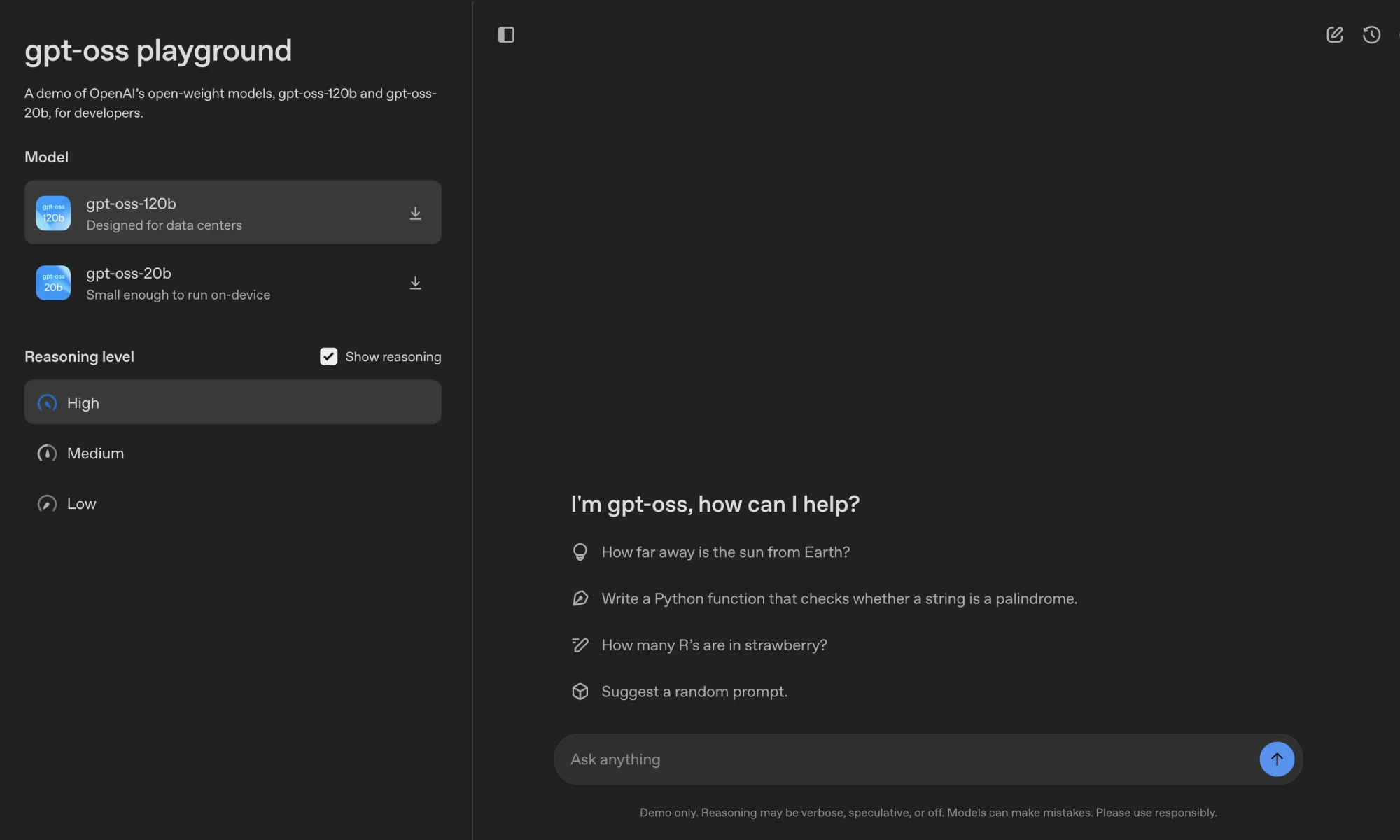

GPT-OSSは、OpenAIが提供するオープンソースの言語モデルファミリーで、以下を含む。 gpt-oss-120b 和 gpt-oss-20bそれぞれ1170億と210億のパラメーターを持つソフトウェアの最新バージョンは、Apache 2.0ライセンスでライセンスされており、開発者は無料でダウンロード、変更、配備することができる。gpt-oss-120b Nvidia H100GPU1基で動作し、データセンターやハイエンド機器に最適です;gpt-oss-20b 低レイテンシのシナリオでは、16GBのRAMを搭載したデバイスで動作します。モデルは、連鎖推論、ツールコール、スマートボディタスクとローカライズされたアプリケーションのための構造化された出力をサポートしています。OpenAIは、セキュアなトレーニングと外部監査によってモデルのセキュリティを保証し、企業、研究、個人の開発者に適しています。

機能一覧

- オープンソースモデル ダウンロード提供

gpt-oss-120b和gpt-oss-20bハギング・フェイス・プラットフォームで自由に利用できるモデル・ウエイト。 - 効率的な推論MXFP4を使って定量した。

gpt-oss-120bシングルGPUで動作している。gpt-oss-20b16GB RAMのデバイスに対応。 - 論理的推論低、中、高の推論強度をサポートし、開発者はタスクに応じてパフォーマンスとレイテンシを調整できる。

- ツールコールウェブ検索、Pythonコード実行、ファイル操作ツールを統合し、インタラクティブ性を向上。

- ハーモニー・フォーマットハーモニー独自のレスポンス・フォーマットを使用することで、デバッグしやすい構造になっています。

- マルチプラットフォーム対応Transformers、vLLM、Ollama、LM Studioなどのフレームワークと互換性があり、さまざまなハードウェアに適応。

- セキュリティ機構慎重な調整と指示の優先順位付けシステムにより、チップ注入などのリスクを低減する。

- トリマブル特定のタスクシナリオに適応するための完全なパラメータ微調整をサポートします。

- ロング・コンテクスト・サポート複雑なタスクのために128kのコンテキスト長をネイティブでサポート。

ヘルプの使用

設置プロセス

GPT-OSSモデルを使用するには、モデルウェイトをダウンロードし、環境を設定します。詳しい手順は以下の通りです:

- モデルウェイトのダウンロード

ハギング・フェイスからモデル・ウエイトを入手:huggingface-cli download openai/gpt-oss-120b --include "original/*" --local-dir gpt-oss-120b/ huggingface-cli download openai/gpt-oss-20b --include "original/*" --local-dir gpt-oss-20b/設置の確認

huggingface-cli:pip install huggingface_hub。 - Python環境の設定

Python 3.12で仮想環境を作る:uv venv gpt-oss --python 3.12 source gpt-oss/bin/activate pip install --upgrade pip依存関係をインストールします:

pip install transformers accelerate torch pip install gpt-ossTritonの実装には、追加のインストールが必要です:

git clone https://github.com/triton-lang/triton cd triton pip install -r python/requirements.txt pip install -e . pip install gpt-oss[triton] - 運用モデル

- トランスフォーマー実現ロード&ラン

gpt-oss-20b:from transformers import pipeline import torch model_id = "openai/gpt-oss-20b" pipe = pipeline("text-generation", model=model_id, torch_dtype="auto", device_map="auto") messages = [{"role": "user", "content": "量子力学是什么?"}] outputs = pipe(messages, max_new_tokens=256) print(outputs[0]["generated_text"][-1])Harmonyフォーマットを使用しないと、モデルが正しく動作しないことを確認してください。

- vLLMの実装OpenAI対応サーバーを起動します:

uv pip install --pre vllm==0.10.1+gptoss --extra-index-url https://wheels.vllm.ai/gpt-oss/ vllm serve openai/gpt-oss-20b - オッラマの実現(コンシューマーグレードのハードウェア):

ollama pull gpt-oss:20b ollama run gpt-oss:20b - LMスタジオの実装:

lms get openai/gpt-oss-20b - アップル・シリコンの実現重さをメタル・フォーマットに変換:

pip install -e .[metal] python gpt_oss/metal/scripts/create-local-model.py -s gpt-oss-20b/metal/ -d model.bin python gpt_oss/metal/examples/generate.py gpt-oss-20b/metal/model.bin -p "为什么鸡过马路?"

- トランスフォーマー実現ロード&ラン

操作機能

- 論理的推論このモデルは3つの推論の強さ(低、中、高)をサポートしている。開発者は、例えばシステムメッセージでこれを設定できる:

system_message_content = SystemContent.new().with_reasoning_effort("high")高い強度は数学的推論のような複雑なタスクに適しており、低い強度は素早く答えを出すのに適している。

- ハーモニー・フォーマットモデルの出力は次のように分けられる。

analysis(推論プロセス)とfinal(ファイナルアンサー)。Harmonyライブラリを使用して解析:from openai_harmony import load_harmony_encoding, HarmonyEncodingName, Conversation, Message, Role, SystemContent encoding = load_harmony_encoding(HarmonyEncodingName.HARMONY_GPT_OSS) messages = [Message.from_role_and_content(Role.USER, "旧金山天气如何?")] conversation = Conversation.from_messages(messages) token_ids = encoding.render_conversation_for_completion(conversation, Role.ASSISTANT)ユーザーにのみ表示

finalチャンネルの内容 - ツールコール:

- ウェブ検索スルー

browserウェブコンテンツを検索、開く、または見つけるためのツール。ツールを有効にします:from gpt_oss.tools.simple_browser import SimpleBrowserTool, ExaBackend backend = ExaBackend(source="web") browser_tool = SimpleBrowserTool(backend=backend) system_message_content = SystemContent.new().with_tools(browser_tool.tool_config)セッティングが必要

EXA_API_KEY環境変数。 - Pythonコード実行例えば、コンピューティング・タスクを実行する:

from gpt_oss.tools.python_docker.docker_tool import PythonTool python_tool = PythonTool() system_message_content = SystemContent.new().with_tools(python_tool.tool_config)注:PythonツールはDockerコンテナを使用するため、プロンプト・インジェクションのリスクを慎重に扱う必要がある。

- ファイル操作スルー

apply_patchファイルを作成、更新、削除するツール。

- ウェブ検索スルー

- 構造化出力Responses API形式をサポートし、インテリジェントなボディワークフローに適した一貫性のある出力を保証します。

ほら

- ハードウェア要件:

gpt-oss-120b80GB GPUが必要(Nvidia H100など)。gpt-oss-20b16GBのRAMが必要。 Apple SiliconにはMetalフォーマットのウェイトが必要。 - コンテキストの長さ128k コンテキストをサポート。

max_context_lengthパラメーター - 安全な使用有害情報の漏洩を防ぐため、連鎖する推論内容の直接表示は避ける。

- サンプリング・パラメーターおすすめ

temperature=1.0和top_p=1.0最適な出力のために。

アプリケーションシナリオ

- 企業のローカリゼーション展開

顧客サービス、社内ナレッジベース、コンプライアンス上重要なシナリオに適した機密データを扱うために、組織はローカルサーバー上でGPT-OSSを実行することができます。 - 開発者のカスタマイズ

開発者はApache 2.0ライセンスに基づいてモデルを微調整し、法的文書の分析やコード生成などの特定のタスクを最適化することができる。 - 学術研究

研究者は、AIアルゴリズムの実験、推論行動の分析、セキュリティ監視システムの開発にモデルを使用することができる。 - 民生機器アプリケーション

gpt-oss-20bラップトップやエッジデバイスに適応し、パーソナルアシスタントやオフラインのライティングツールの開発に適している。

QA

- GPT-OSSはどのハードウェアをサポートしていますか?

gpt-oss-120b80GB GPUが必要(Nvidia H100など)。gpt-oss-20bハイエンドのノートパソコンやアップルのシリコンなど、16GBのRAMを搭載したデバイスで動作する。 - モデルを固定する方法は?

OpenAIは$50万レッドチームチャレンジを開催し、コミュニティによるセキュリティ脆弱性の発見を奨励しています。 - マルチモーダルには対応しているか?

サポートされているのはテキストの入出力のみで、画像やその他のモダリティはサポートされていない。 - モデルを微調整するには?

モデルの重みをロードした後、Transformersや他のフレームワークを使用して、カスタムデータセット上で完全なパラメータの微調整を行う。 - ハーモニー・フォーマットは何をするのですか?

Harmonyフォーマットは、デバッグと信頼性を容易にするために、構造化された出力を保証します。これを使用しなければ、モデルは正しく機能しない。