GPT-Loadはオープンソースの高性能AIプロキシツールであり、幅広いビッグモデルサービスに対して統一されたインターフェース管理とロードバランシングを提供することに重点を置いています。インテリジェントなキーポーリング機構により、OpenAI、Gemini、Claudeなどのモデルへの開発者のアクセスを簡素化します。ユーザは、ウェブインタフェースを通じて、リアルタイムで素早く設定をデプロイし、管理することができます。GPT-Loadはtbphpによって開発され、GitHubでホストされており、企業および個人の開発者の両方に適しています。

機能一覧

- インテリジェント・キー・ポーリング複数のAPIキーを自動的に管理し、リクエストを動的に分散し、インターフェースコールの効率を向上させます。

- マルチモデル対応以下は、OpenAI、Gemini、Claudeなど、統一されたAPIエントリーを提供する主要モデルのリストである。

- 負荷分散リクエストの割り当てを最適化することで、高い同時実行シナリオにおける安定性を確保します。

- ウェブ管理インターフェースサービスを再起動することなく、リアルタイムでコンフィギュレーションを変更することができます。

- データベースの柔軟性MySQL、PostgreSQL、Redisをサポート。

- Dockerのデプロイメント設置や拡張を簡素化するコンテナ型ソリューションを提供。

- クラスターサポート共有データベースとRedisにより、複数ノードのコラボレーションを可能にします。

- APIプロキシ転送開発を簡素化するため、複数のAPIリクエスト・フォーマットをサポートしています。

ヘルプの使用

設置プロセス

GPT-LoadはDockerとソースビルドの両方のインストールをサポートしています。詳しい手順は以下の通りです:

方法1:Dockerデプロイメント(推奨)

- DockerとDocker Composeのインストール

DockerとDocker Composeがシステムにインストールされていることを確認し、以下のコマンドで確認できる:docker --version docker compose version - プロジェクト・ディレクトリの作成

ローカル・ディレクトリを作成し、その中に入る:mkdir -p gpt-load && cd gpt-load - 設定ファイルのダウンロード

GitHubリポジトリからデフォルトの設定ファイルを取得します:wget https://raw.githubusercontent.com/tbphp/gpt-load/main/docker-compose.yml wget -O .env https://raw.githubusercontent.com/tbphp/gpt-load/main/.env.example - 環境変数の設定

コンパイラ.envファイルで認証キーやその他のパラメータを設定する。例AUTH_KEY=sk-123456デフォルトの認証キーは

sk-123456の数は必要に応じて変更できる。 - サービス開始

Docker Composeを使ってサービスを開始する:docker compose up -dこのサービスは以下の場所で利用できる。

http://localhost:3001走っている。 - アクセス管理インターフェース

ブラウザを開き、次のサイトにアクセスする。http://localhost:3001用途.envで始まるAUTH_KEYログイン - マネジメントサービス

- サービスのステータスを確認する:

docker compose ps - ログを見る

docker compose logs -f - サービスを再起動する:

docker compose down && docker compose up -d - 更新バージョン

docker compose pull && docker compose down && docker compose up -d

- サービスのステータスを確認する:

方法2:ソースコードの構築

- クローン倉庫

GitHubからプロジェクトのコードをクローンする:git clone https://github.com/tbphp/gpt-load.git cd gpt-load - 囲碁環境のインストール

Go 1.18以降がシステムにインストールされていることを確認してください。バージョンを確認してください:go version - 依存関係のインストール

プロジェクトの依存関係をプルする:go mod tidy - 環境変数の設定

サンプルの設定ファイルをコピーして編集してください:cp .env.example .env修正

.env正鵠を得るDATABASE_DSN(データベース接続文字列)とREDIS_DSN(Redis接続文字列、オプション)。例AUTH_KEY=sk-123456 DATABASE_DSN=mysql://user:password@host:port/dbname - 運営サービス

サービスを開始する:make runサービスはデフォルトで

http://localhost:3001。

データベース構成

- SQLite追加設定なしのスタンドアロンの軽量アプリケーションに適しています。

- MySQL/PostgreSQL:: 編集部

docker-compose.yml関連するサービスをアンコメントし、環境変数を設定して再起動する。 - Redisキャッシュとノードの同期のために、クラスタのデプロイ時に設定する必要があります。

主な機能

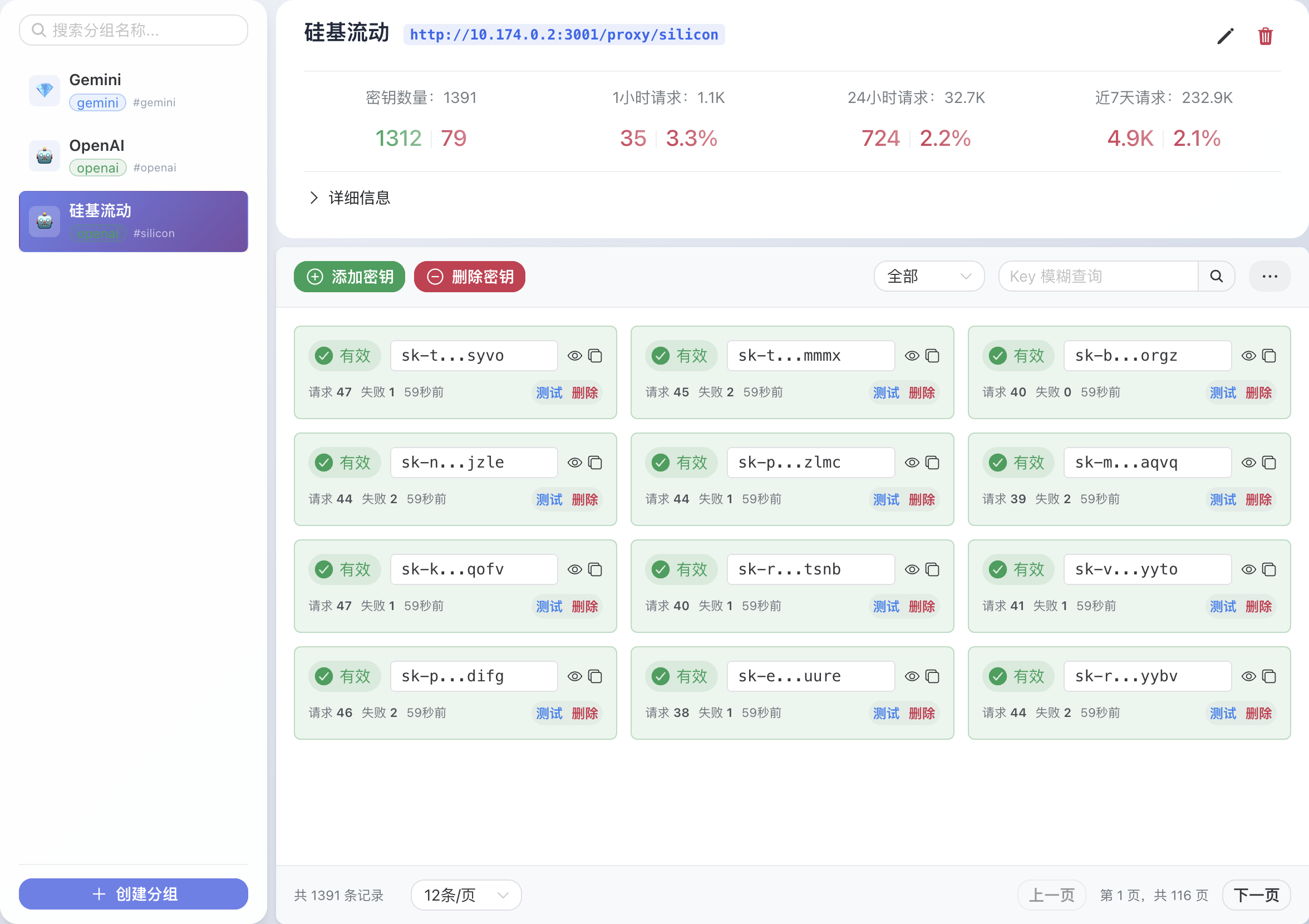

1.鍵の管理

- ウェブ・インターフェイスにログインした後、「Key Management(鍵管理)」ページに進む。

- 複数のAPIキーを追加する(OpenAIやGeminiなど)。

- システムは自動的に利用可能なキーをポーリングし、オーバーランしていないキーを使ってリクエストを送信することを優先する。

2.APIプロキシリクエスト

- GPT-Loadは統一されたプロキシインタフェースを提供します。例えば、OpenAIのチャットインターフェースを呼び出します:

curl -X POST http://localhost:3001/proxy/openai/v1/chat/completions \ -H "Authorization: Bearer sk-123456" \ -H "Content-Type: application/json" \ -d '{"model": "gpt-4.1-mini", "messages": [{"role": "user", "content": "Hello"}]}' - ジェミニ、クロードなどのモデルのプロキシリクエストも同様のフォーマットでサポートされている。

3.リアルタイム設定

- ウェブ・インターフェイスで、モデル・パラメータ、キー・プライオリティ、ロード・バランシング・ポリシーを変更します。

- コンフィギュレーションは保存後すぐに有効になり、サービスを再起動する必要はない。

4.クラスタ展開

- すべてのノードが同じMySQL/PostgreSQLとRedis接続を持っていることを確認する。

- 在

.envで統合データベースとRedis接続を設定する。 - Docker ComposeまたはKubernetesを使用して複数のノードをデプロイする。

ほら

- ファイアウォールでポート3001が開いていることを確認する。

- クラスターのデプロイ時にRedisを設定しておくか、インメモリ・ストレージを有効にしておく必要がある。

- オーバーランによるサービス中断を避けるため、キーの使用量を定期的にチェックする。

アプリケーションシナリオ

- エンタープライズAIの統合

AIアプリケーションを開発する企業は、OpenAI、Gemini、そして次の3つを利用する必要がある。 Claude GPT-Loadは、開発プロセスを簡素化し、メンテナンスコストを削減するための統一されたエントリーポイントを提供します。 - 並行性の高いAIサービス

チャットボットやインテリジェントなカスタマーサービスシナリオでは、GPT-Loadのロードバランシングとキーポーリングが、大規模なユーザーアクセスに対する並行性の高いリクエストの安定性を保証します。 - 開発者個人の実験

開発者はGPT-Loadを迅速に導入し、さまざまな大規模モデルの性能をテストし、複数の無料または有料キーを管理し、試行錯誤のコストを削減することができます。

QA

- GPT-Loadの対応機種は?

OpenAI、Gemini、Claudeおよびその他の主流ビッグモデルをサポートします。 - データベースを切り替えるには?

コンパイラdocker-compose.ymlMySQLまたはPostgreSQLのコメントを解除するには、以下のように設定します。.env正鵠を得るDATABASE_DSNその後、サービスを再起動する。 - クラスタ展開には何が必要ですか?

すべてのノードが同じMySQL/PostgreSQLとRedis接続を持っている必要があり、Redisは必須です。 - ウェブ・インターフェースのセキュリティはどうなっていますか?

とおす.env正鵠を得るAUTH_KEY認証には強力な鍵を使用し、定期的に変更することを推奨する。