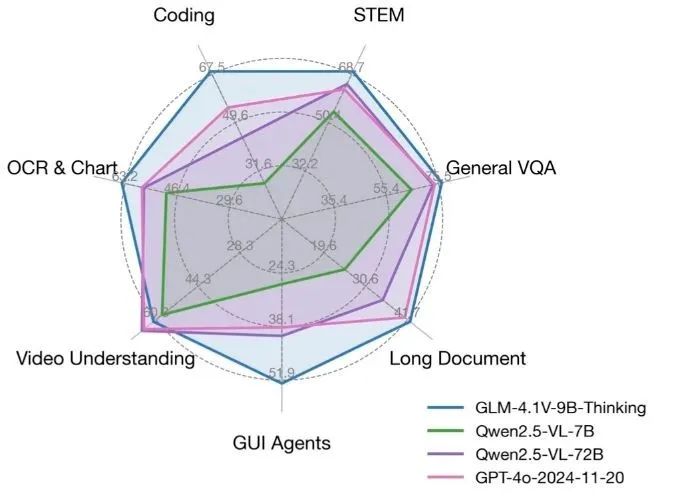

GLM-4.1V-Thinkingは清華大学KEG研究室(THUDM)によって開発されたオープンソースの視覚言語モデルであり、マルチモーダルな推論能力に焦点を当てている。GLM-4-9B-0414をベースモデルとして、強化学習と「思考の連鎖」推論メカニズムにより、複雑なタスクの処理能力を大幅に向上させる。64Kの超長コンテクスト、4Kの高解像度画像処理、任意の画像アスペクト比に対応し、英語と中国語のバイリンガルにも対応しています。このモデルは、数学、コード、長文文書理解、ビデオ推論などのタスクに優れており、いくつかのレビューではGPT-4oを凌駕しています。 コードとモデルはMITライセンスの下、GitHubで公開されており、開発者、研究者、企業による商用利用は無料です。

機能一覧

- 長い文書や複雑なダイアログを処理するための、非常に長い64kコンテキストのサポート。

- 4K高解像度画像を扱い、任意のアスペクト比をサポート。

- 英語と中国語のバイリンガルサポートを提供し、多言語シナリオに適しています。

- 思考連鎖」の推論メカニズムを統合し、数学、コード、ロジックの課題の精度を向上させる。

- ビデオコンテンツを分析し、関連する質問に答えるためのビデオ推論をサポートします。

- MITライセンスに基づくオープンソースのコードとモデルで、自由な商用利用が可能。

- Hugging FaceとModelScopeのオンラインデモは、モデリング機能を素早く体験できます。

- リソースに制約のある開発環境において、3090グラフィックスカード1枚での実行をサポート。

ヘルプの使用

インストールと展開

GLM-4.1V-Thinkingは、開発者がローカルまたはサーバー上で実行するための簡単なデプロイメントプロセスで、完全なコードとモデルファイルを提供します。以下は、詳細なインストールと使用手順です:

1.環境準備

NVIDIAグラフィックカード(RTX 3090など)を推奨します。Python 3.8以上とPyTorchがインストールされていることを確認してください。 依存関係をインストールする手順は以下の通りです:

pip install git+https://github.com/huggingface/transformers.git

pip install torch torchvision torchaudio

pip install -r requirements.txt

モデルの微調整が必要な場合は、以下を参照してください。 finetune/README.md ファイルを、LLaMA-Factory ツールキットを使用して作成する。微調整を行う場合は、トレーニングの安定性を確保し、Zero2で生じる可能性のあるゼロロス問題を回避するため、Zero3ストラテジーを使用することを推奨する。

2.ダウンロードモデル

GLM-4.1V-ThinkingモデルはHugging FaceまたはGitHubリポジトリからダウンロードできます。以下のコードを実行してモデルをロードしてください:

from transformers import AutoProcessor, Glm4vForConditionalGeneration

import torch

MODEL_PATH = "THUDM/GLM-4.1V-9B-Thinking"

processor = AutoProcessor.from_pretrained(MODEL_PATH, use_fast=True)

model = Glm4vForConditionalGeneration.from_pretrained(

pretrained_model_name_or_path=MODEL_PATH,

torch_dtype=torch.bfloat16,

device_map="auto"

)

モデルサポート bfloat16 フォーマットで、メモリフットプリントが小さく、シングルGPU動作に適している。

3.単一イメージ推論

GLM-4.1V-Thinkingは画像入力による推論をサポートします。以下は簡単な画像説明の例です:

messages = [

{

"role": "user",

"content": [

{"type": "image", "url": "https://example.com/sample_image.png"},

{"type": "text", "text": "描述这张图片"}

]

}

]

inputs = processor.apply_chat_template(

messages, tokenize=True, add_generation_prompt=True, return_dict=True, return_tensors="pt"

).to(model.device)

generated_ids = model.generate(**inputs, max_new_tokens=8192)

output_text = processor.decode(generated_ids[0][inputs["input_ids"].shape[1]:], skip_special_tokens=False)

print(output_text)

将 sample_image.png 実際の画像のURLまたはローカルパスに置き換えます。モデルは画像を分析し、詳細な説明を生成します。

4.ビデオ推論

GLM-4.1V-Thinkingはビデオコンテンツ解析をサポートします。ユーザーはGitHubリポジトリにあるサンプルコードやオンラインデモ・プラットフォーム(例:Hugging Face)を介してビデオファイルをアップロードすることができ、モデルはビデオを解析し、それに関する質問に答えます。例えば、会議のビデオをアップロードし、「ビデオの中でどのようなトピックが議論されたか」と尋ねると、モデルは重要な情報を抽出し、正確な答えを生成する。

5.長い文書の理解

このモデルは64Kの長いコンテクストをサポートしており、長い文書の処理に最適である。ユーザーはこのモデルにテキストを入力し、特定の内容を尋ねたり、文書の重要なポイントを要約したりすることができる。例えば、50ページの学術論文を入力し、"論文の主な結論は何ですか?"と尋ねると、モデルはそれらを素早く抽出し要約する。

6.オンライン・プレゼンテーション

ローカルへの配備は不要で、Hugging FaceまたはModelScopeが提供するオンラインデモで直接体験することができます。以下のリンクをご覧ください:

- ハグする顔のデモ:

https://huggingface.co/THUDM/GLM-4.1V-9B-Thinking - ModelScopeのデモ:

https://modelscope.cn/models/THUDM/GLM-4.1V-9B-Thinking

ユーザーは画像やビデオをアップロードしたり、テキストを入力したりして、モデルの推論を素早くテストすることができる。

7.モデルの微調整

開発者は、LLaMA-Factoryツールキットを使用して、特定のタスクに適合するようにモデルを微調整できる。微調整設定ファイルは configs/lora.yaml微調整を開始するには、以下のコマンドを実行する:

cd finetune

python finetune.py data/YourDataset/ THUDM/GLM-4-9B-0414 configs/lora.yaml

データセットが正しくフォーマットされていることを確認する。微調整の後、モデルは、医療画像解析や法的文書処理など、ドメイン固有のタスクにより適合させることができる。

注目の機能操作

- けいらくモデルは「思考の連鎖」メカニズムによって複雑な問題を分解する。例えば、数学の課題では、モデルは正確な結果を保証するためにステップバイステップで答えを導きます。ユーザーが「二次方程式x² + 2x - 3 = 0を解く」と入力すると、モデルは問題を解くための詳細なステップを出力します。

- マルチモーダルサポートユーザーは画像とテキストの両方を入力することができます。例えば、回路図をアップロードし、"回路はどのように動作しますか?"と質問すると、モデルは画像と質問を組み合わせて詳細な説明を生成します。

- 中英バイリンガルこのモデルは中国語と英語の混在入力をサポートしています。例えば、中国語で質問を入力し、英語で画像の説明を入力すると、モデルは指定された言語で回答します。

ほら

- GPUに十分なメモリがあることを確認し、少なくとも24GBを推奨します。

- 長いコンテキストの処理でYaRNコンフィギュレーションを有効にし、コンフィギュレーション・ファイルでパフォーマンスを最適化する。

config.json正鵠を得る"rope_scaling": {"type": "yarn", "factor": 4.0}。 - モデル推論の速度はハードウェアに依存し、3090グラフィックカードはリアルタイム応答を可能にする。

アプリケーションシナリオ

- 学術研究

研究者はGLM-4.1V-Thinkingを使って長い学術論文を分析し、重要な結論や要約内容を抽出することができます。また、実験画像を処理し、データグラフの分析を支援することもできます。 - 教育支援

生徒が数学の問題や理科の実験の写真をアップロードすると、模型が問題の解き方や実験の解説を詳しく説明し、自習や教材に適している。 - コンテンツ制作

クリエイターは、ビデオや画像の映像を入力して、説明文やクリエイティブなスクリプトを生成することができます。例えば、旅行ビデオを入力すると、アトラクションの説明文が生成されます。 - エンタープライズ・アプリケーション

企業は、契約条件の分析やレポートの作成など、ドキュメントの自動化のためにこのモデルを使用することができます。英語と中国語のバイリンガルサポートにより、多国籍組織に適しています。

QA

- GLM-4.1V-Thinkingがサポートする入力タイプは?

このモデルは画像、ビデオ、テキスト入力をサポートし、マルチモーダルなタスクのために4K画像と64Kコンテキストに対応している。 - 高性能のハードウェアが必要ですか?

RTX 3090グラフィックカード1枚で動作し、スムーズな推論のために24GBのビデオメモリを推奨。 - モデルを微調整するには?

LLaMA-Factoryツールキットを使用するには、GitHubリポジトリのfinetune/README.mdファイルでlora.yaml微調整。 - モデルは無料ですか?

はい、このモデルはMITライセンスに基づくオープンソースで、自由な商用利用が可能です。 - このモデルを体験するには?

Hugging FaceまたはModelScopeのオンラインデモから画像やテキストをアップロードして、モデルの機能をすばやくテストできます。