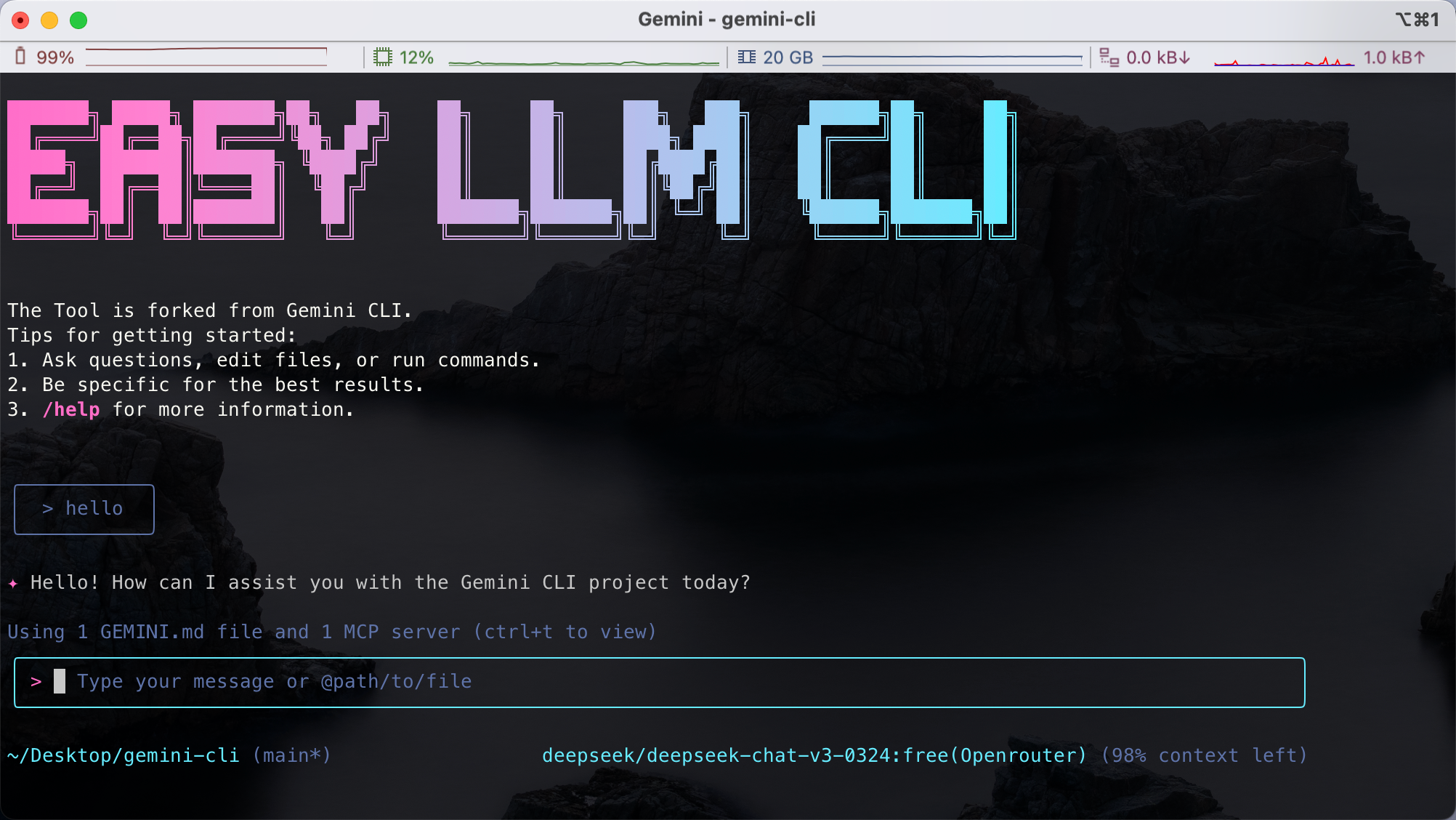

easy-llm-cliは、Googleの Gemini CLIは、開発者が簡単なコマンドで複数の大規模言語モデル(LLM)を呼び出せるように開発された。OpenAI、Gemini、Claude、その他多くのモデルのAPIをサポートしており、OpenAIのAPIフォーマットに従っているすべてのモデルと互換性があります。ユーザーは、テキストを素早く生成したり、コードを解析したり、マルチモーダル入力(画像やPDFなど)を処理したり、複雑な開発タスクをターミナルから自動化することもできる。このツールは軽量でモジュール化されており、カスタム設定に対応しているため、開発者がローカル環境や本番環境で使用するのに適している。プロジェクトはGitHubでホストされており、活発なコミュニティ、詳細なドキュメントがあり、簡単に始めることができる。

機能一覧

- Gemini、OpenAI、Claude、Qwenなど、幅広い大規模言語モデルをサポート。

- テキストを素早く生成したり、質問に答えたり、入力を処理したりするためのコマンドラインインターフェースを提供します。

- マルチモーダル入力をサポートし、画像やPDFなどの非テキストコンテンツを分析できます。

- コードコメントを生成したり、コードベースの変更を要約するコード分析機能を提供します。

- Gitコミットの処理、レポートやチャートの生成など、自動化されたワークフローをサポート。

- カスタマイズされたモデル設定と、環境変数によるLLMプロバイダーの柔軟な切り替えが可能。

- アジュバント MCP サーバーに接続し、外部ツールに接続して機能を拡張する。

- コミュニティへの貢献とローカル展開をサポートするオープンソースプロジェクト。

ヘルプの使用

設置プロセス

ローカルでeasy-llm-cliを使用するには、以下のインストール手順を完了する必要があります。あなたのシステムが最小要件を満たしていることを確認してください: Node.js 20 以上。

- Node.jsのインストール

インタビュー Node.js公式ウェブサイト Node.js(推奨バージョン20.x以上)をダウンロードしてインストールする。以下のコマンドを実行して、バージョンを確認してください:node -v

2. **快速运行 CLI**

无需克隆仓库,可直接通过 npx 运行:

```bash

npx easy-llm-cli

これにより、ツールが自動的にダウンロードされ、クイックトライアル用に起動します。

3. グローバルインストール(推奨)

長期間使用する場合は、グローバルにインストールすることをお勧めします:

npm install -g easy-llm-cli

インストールが完了したら、以下のコマンドを実行して起動する:

elc

- ソースからのインストール(オプション)

コードのカスタマイズや貢献が必要な場合は、リポジトリをクローンすることができます:git clone https://github.com/ConardLi/easy-llm-cli.git cd easy-llm-cli npm install npm run start - APIキーの設定

easy-llm-cliはLLMプロバイダのAPIキーで設定する必要があります。例えば、OpenAIのAPIを使う:export CUSTOM_LLM_PROVIDER="openai" export CUSTOM_LLM_API_KEY="sk-xxxxxxxxxxxxxxxxxxxx" export CUSTOM_LLM_ENDPOINT="https://api.openai.com/v1" export CUSTOM_LLM_MODEL_NAME="gpt-4o-mini"将

sk-xxxxxxxxxxxxxxxxxxxx実際のキーと交換してください。実際のキーは.bashrc或.zshrcをクリックして、これらのコマンドを永続的なコンフィギュレーションに追加する。 - Dockerのインストール(オプション)

コンテナによるデプロイを好むなら、Dockerを使うことができる:docker build -t easy-llm-cli . docker run -d -p 1717:1717 --name easy-llm-cli easy-llm-cliポートが

1717無人。

主な機能

easy-llm-cliの中核は、テキスト生成、コード解析、自動化タスクのためにコマンドライン経由で大きな言語モデルを呼び出すことです。以下はその詳細な説明です:

1.テキスト生成

以下のコマンドを実行してテキストを生成する:

elc "写一篇 200 字的 Python 简介"

- 操作説明:

elcはツールの起動コマンドで、その後にプロンプトが続く。設定されたモデル(GeminiやOpenAIなど)がデフォルトで使用されます。環境変数でモデルを切り替えることができます。 - 輸出このモデルは、200語のPythonプロフィールをわかりやすいフォーマットで返します。

2.コード分析

プロジェクト・ディレクトリで以下のコマンドを実行し、コード・ベースを解析する:

cd my-project

elc "总结昨天的 Git 提交记录"

- 操作説明このツールは現在のディレクトリのGit履歴をスキャンし、コミットの要約を生成する。

- 輸出時間または機能ごとにグループ化された提出指示を返します。

3.マルチモーダル入力

easy-llm-cliは画像やPDFの処理をサポートし、例えばPDFからテキストを抽出します:

elc "提取 PDF 中的文本" -f document.pdf

- 操作説明:

-fパラメータはファイルパスを指定します。サポートされている形式は、PDFと画像(JPEG、PNGなど)です。 - 輸出抽出されたテキストの内容を返します。

4.自動化されたワークフロー

MCPサーバーを通して、このツールは外部のシステムに接続することができる。例えば、Gitの履歴チャートを生成する:

elc "生成过去 7 天的 Git 提交柱状图"

- 操作説明MCPサーバーを設定する必要があります。

@antv/mcp-server-chart).ツールはモデルを呼び出してチャートデータを生成し、MCPを介してそれをレンダリングする。 - 輸出棒グラフのデータまたは視覚化の結果を返します。

5.カスタマイズされたモデル構成

環境変数を使って、クロードなどの他のモデルに切り替えることができる:

export CUSTOM_LLM_PROVIDER="openrouter"

export CUSTOM_LLM_API_KEY="your-openrouter-key"

export CUSTOM_LLM_MODEL_NAME="claude-sonnet-4"

elc "分析这段代码的功能" < myfile.py

- 操作説明環境変数の設定後、コマンドを実行して機種を切り替える。

- 輸出リターン Claude コードのモデル分析。

注目の機能操作

1.マルチモーダルサポート

easy-llm-cliはイメージやPDFなどのマルチモーダル入力の処理をサポートします。例えば、ドラフトアプリケーションの生成:

elc "根据 sketch.jpg 生成 Web 应用代码" -f sketch.jpg

- 操作説明デザインスケッチをアップロードすると、モデルが対応するHTML/CSS/JavaScriptコードを生成します。

- 輸出ウェブアプリケーションのコードフレームワークを完全に返します。

2.自動化されたタスク

ツールは複雑な開発タスクを処理できる。例えば、Git操作の自動化などだ:

elc "处理 GitHub Issue #123 的代码实现"

- 操作説明このツールはIssueの説明を読み、実装コードを生成し、Pull Requestを提出します。

- 輸出生成されたコードとPRリンクを返します。

3.プログラマティック・インテグレーション

開発者はeasy-llm-cliをコードに統合することができます。例えば、Node.jsを使う:

import { ElcAgent } from 'easy-llm-cli';

const agent = new ElcAgent({

model: 'gpt-4o-mini',

apiKey: 'your-api-key',

endpoint: 'https://api.openai.com/v1'

});

const result = await agent.run('生成销售数据的柱状图');

console.log(result);

- 操作説明スルー

ElcAgent自動化スクリプトに組み込むのに適したクラス呼び出しモデル。 - 輸出チャートデータなどの処理結果を返す。

ほら

- APIキーが有効で、ネットワーク接続が安定していることを確認する。

- マルチモーダル機能には、モデルのサポートが必要である(公式テストフォームを参照)。例えば、Gemini-2.5-pro と GPT-4.1 はマルチモダリティをサポートしている。 DeepSeek-R1 サポートはない。

- 複雑なタスクを実行する場合は

CUSTOM_LLM_MAX_TOKENSで十分である(デフォルトは8192)。 - 問題が発生した場合は トラブルシューティング あるいは走る:

elc logs

アプリケーションシナリオ

- コードベース解析

開発者は新しいプロジェクトを実行できるelc "描述系统架构"また、コード構造を素早く理解できるため、不慣れなプロジェクトを引き継ぐのに適している。 - アプリケーション・プロトタイプの生成

デザイナーは、スケッチまたはPDFをアップロードし、以下を実行します。elc "生成 Web 应用"実行可能なコード・プロトタイプを素早く得ることができる。 - DevOpsタスクの自動化

DevOpsエンジニアはelc "生成最近 7 天的 Git 提交报告"チームの仕事の進捗状況を自動的に照合する。 - ファイル処理

研究者は以下を利用できる。elc "提取 PDF 中的关键信息" -f paper.pdf学術文書の内容を素早く整理する。

QA

- easy-llm-cliはどのモデルをサポートしていますか?

Gemini、OpenAI、Claude、Qwen、その他多数、OpenAI APIフォーマットに従ったカスタムモデルをサポートしています。詳細は公式テストフォームをご覧ください。 - マルチモーダル入力をどう扱うか?

利用する-fパラメータを使用して画像またはPDFをアップロードします。elc "提取文本" -f file.pdf.モデルがマルチモダリティをサポートしていることを確認する(例:Gemini-2.5-pro)。 - 有料のAPIは必要ですか?

リモートモデルでは、有効なAPIキー(OpenAIやOpenRouterの有料キーなど)が必要です。Qwen2.5-7B-Instructのようなローカルモデルでは、追加料金は必要ありません。 - エラーのデバッグ方法は?

うごきだすelc logsログを見る、または以下をご覧ください。 トラブルシューティング 助けを求める。