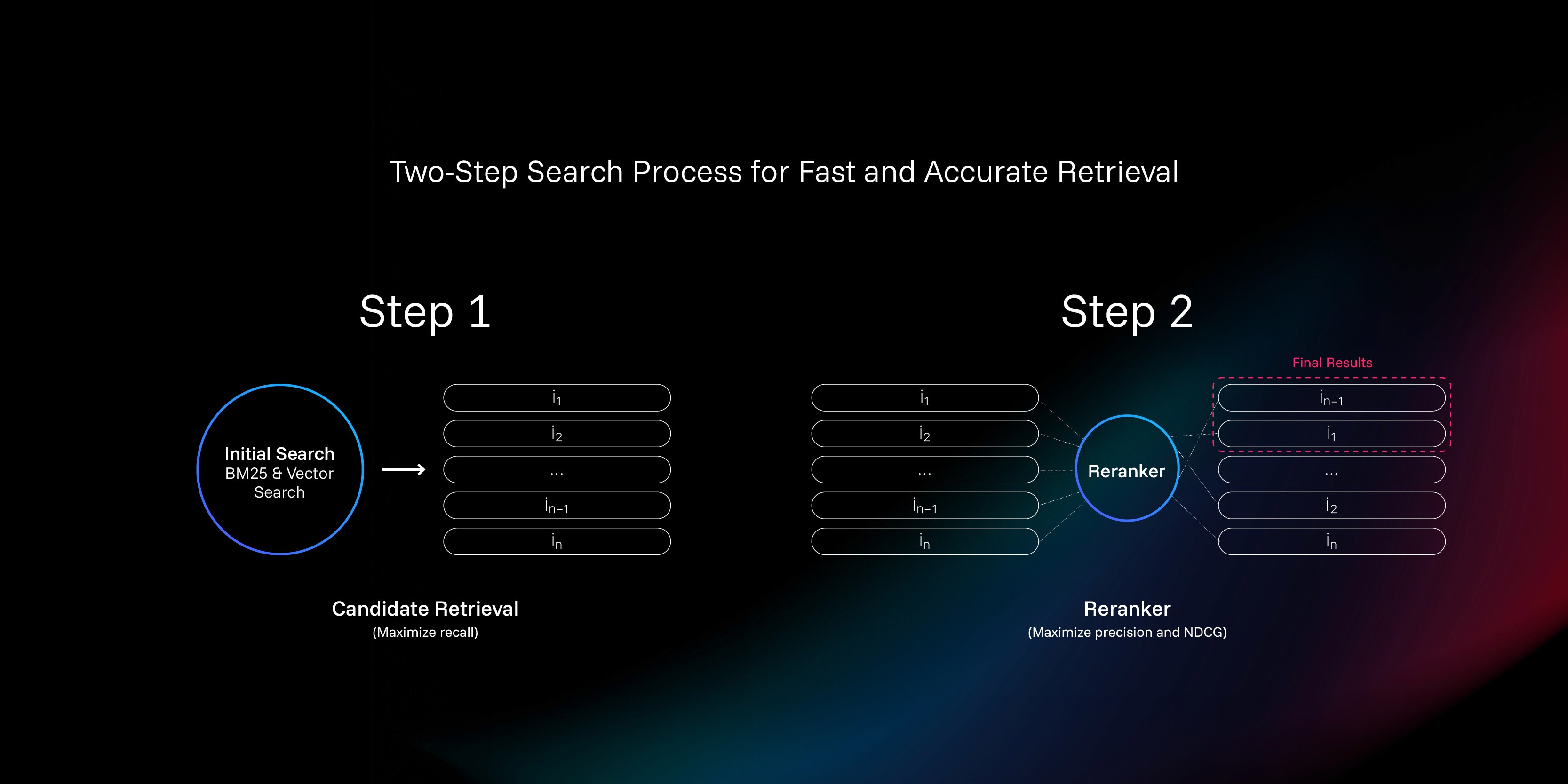

などの製品を製造している。 RAG 或 AI このようなAIシステムをエージェント化する場合、検索の質がシステムの上限を決定する鍵となる。開発者は通常、キーワード検索とセマンティック検索という2つの支配的な検索技術に頼っている。

- キーワード検索(例:BM25)。 高速で、完全一致が得意です。しかし、ユーザーの質問の文言が変わると、リコールは低下する。

- 意味検索。 ベクトル埋め込みによってテキストの深い意味を捉えることで、概念的なクエリの理解が可能になる。

一般的なやり方は、想起を最大化するためにこの2つを組み合わせることである。しかし、高いリコールは高い精度と同じではありません。たとえ正解が多くの想起された文書に含まれていたとしても、それが67位であれば、大規模な言語モデルやユーザーがそれを見ることは事実上不可能である。海の中のシンブル」の問題を解決するために。reranker (Resequencer)が開発された。

リランカーとは?

を置くことができる。 reranker 情報検索プロセスにおける「再試合レビュー」と理解される。

初歩的なキーワード検索や意味検索は「海の世論調査」のようなもので、大量の文書から何百もの関連候補が素早くフィルタリングされる。しかし、その選択プロセスは比較的粗雑で、文書はクエリとは無関係にエンコードされる。対照的に reranker レビュアーとして、ユーザーの「クエリ」と各「候補文書」の全文を入手し、洗練された比較とスコアをつけ、最終的に、より権威のある、ユーザーの本当の意図に沿ったランキングをつける。クエリとドキュメントの両方に触れるため、コンテキストに対する理解は、選択段階のそれよりもはるかに優れている。

本稿では reranker 伝統的な採点アノテーションを排除し、チェスやeスポーツで広く使用されているアノテーションを採用したトレーニング方法。 ELO 格付けサブシステム。

問題の核心:採点の信頼性の低さ

電車 reranker ゴールは、次の関数を作ることである。 f(q, d)どんな「クエリー」にも使える qと「ドキュメンテーション d「正確な関連性スコアの生成 s.理屈の上では、海がある限り (q, d, s) のデータから、教師あり学習によってニューラルネットワークを学習させることができる。

しかし、問題はこの「スコア」である。 s「入手は極めて困難

既存プログラムのジレンマ:二者択一のラベリングと「偽陰性」の大惨事

現在の主流は、手作業でラベル付けされた "ポジティブ"(関連)データと "ネガティブ"(無関係)データのペアを使用するアプローチである。ポジティブな例は簡単に見つかるが、ネガティブな例の構築は大きな問題である。

一つのアプローチは、全文書から無作為にサンプルを取り、おそらく関連性がないと仮定することだ。しかし、これはボクシングのチャンピオンに普通の人をボコボコにするように頼むようなもので、訓練されたモデルは「一見関係がありそうだが、実は役に立たない」というような微妙な状況に対処できない。

もう一つの方法は BM25 やベクトル検索の結果を否定的な例のソースとして使用することができる。しかし、これは「偽陰性」という災難につながる。「否定例」とラベル付けされた文書が本当に関連性がないことをどうやって知るのか?答えは「わからない」である。多くの場合、否定的な例としてラベル付けされた文書は、いわゆる「肯定的な例」よりも実際に関連性が高い。

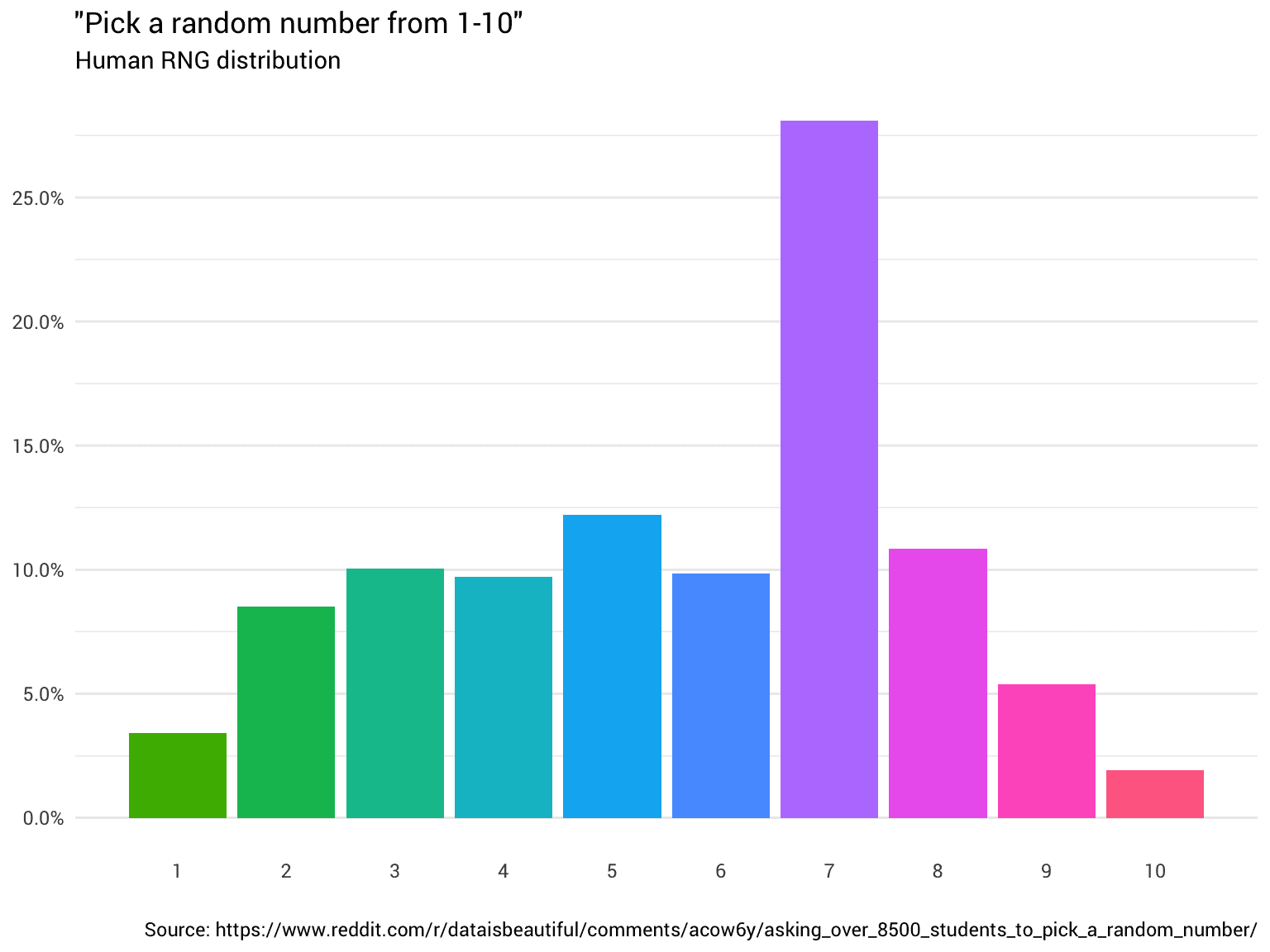

この採点システムの曖昧さが根本的な問題だ。人間の脳は本来、物事に絶対的な点数をつけるのが苦手だ。

查询: 「2017年のノーベル物理学賞受賞者は?

文档: 「重力波は2015年にLIGOによって初めて観測された。

この文書は何点であるべきか?年号が間違っていると感じて低得点にする人もいるかもしれないが、物理学マニアは2017年のノーベル賞がまさに重力波の発見者に授与されたことを知っているので、高得点にするだろう。この主観的な大きな違いが、絶対的な採点をノイズだらけにする。

解決策:"得点 "から "比較 "へ

絶対評価が信頼できないなら、比較すればいいのではないか?人間の脳は、絶対的な評価は苦手だが、相対的な判断は極めて得意だ。

查询: 「2017年のノーベル物理学賞受賞者は?

資料1. 2015年、重力波を発見した研究者にノーベル賞が授与された。

資料2. 重力波は2015年9月にLIGO重力波検出器によって初めて観測された。

文書1が文書2より関連性が高いことは、ほとんど誰もが同意するだろう。対比較によって、我々は非常に高い信号対雑音比を持つラベル付けされたデータを得る。これはまさに ELO レーティング・システムの核となる考え方は、「自分がどれだけ強いか」ではなく、「自分ともう一人の人間のどちらが強いか」を問うことである。多くの2対2の結果があれば、各「選手」(資料)に対して比較的正確なランキングを算出することができる。

さて、問題は、大量の一対比較結果をどのようにして絶対スコアの使えるベクトルに変換するかということになる。

トレーニング・プロセスの概要

これに基づき、革新的なトレーニング・パイプラインが設計された:

- 三元サンプリングとラベリング。 各クエリに対して、最初に100個の候補文書を取得する。ランダムに文書トリプルを選択

(q, d_i, d_j)大規模言語モデル(LLM)クラスタ判定が可能d_i和d_jどちらがより適切か。 - 一対比較モデルのトレーニング 利用する

LLMを訓練するために、ラベル付けされたデータのrerankerこれは、任意の2つの文書の相対的な長所を効率的に予測することを可能にする。 - ELOスコアの計算。 各クエリ候補文書に対して、前のステップで学習されたモデルを用いて、複数回の「シミュレーションマッチ」が実行される。

ELOアルゴリズムは各文書のランクスコアを計算する。 - 最終モデルを訓練する。 将

ELOの得点を「標準的な答え」として、標準的な一点突破のトレーニングを行う。rerankerこれは、文書の関連性スコアを直接予測することを可能にする。 - 集中学習の微調整。 教師あり学習の後、強化学習が導入され、モデルが自己試行錯誤を通じてランキング戦略をさらに最適化し、最終的なパフォーマンスを向上させる。

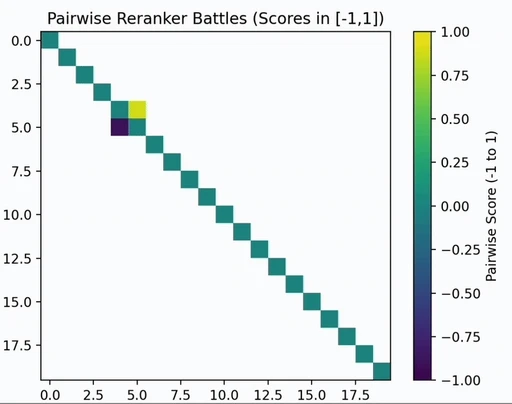

コア技術:ペアワイズ比較とELO評価

ペアワイズコンパレータのトレーニング

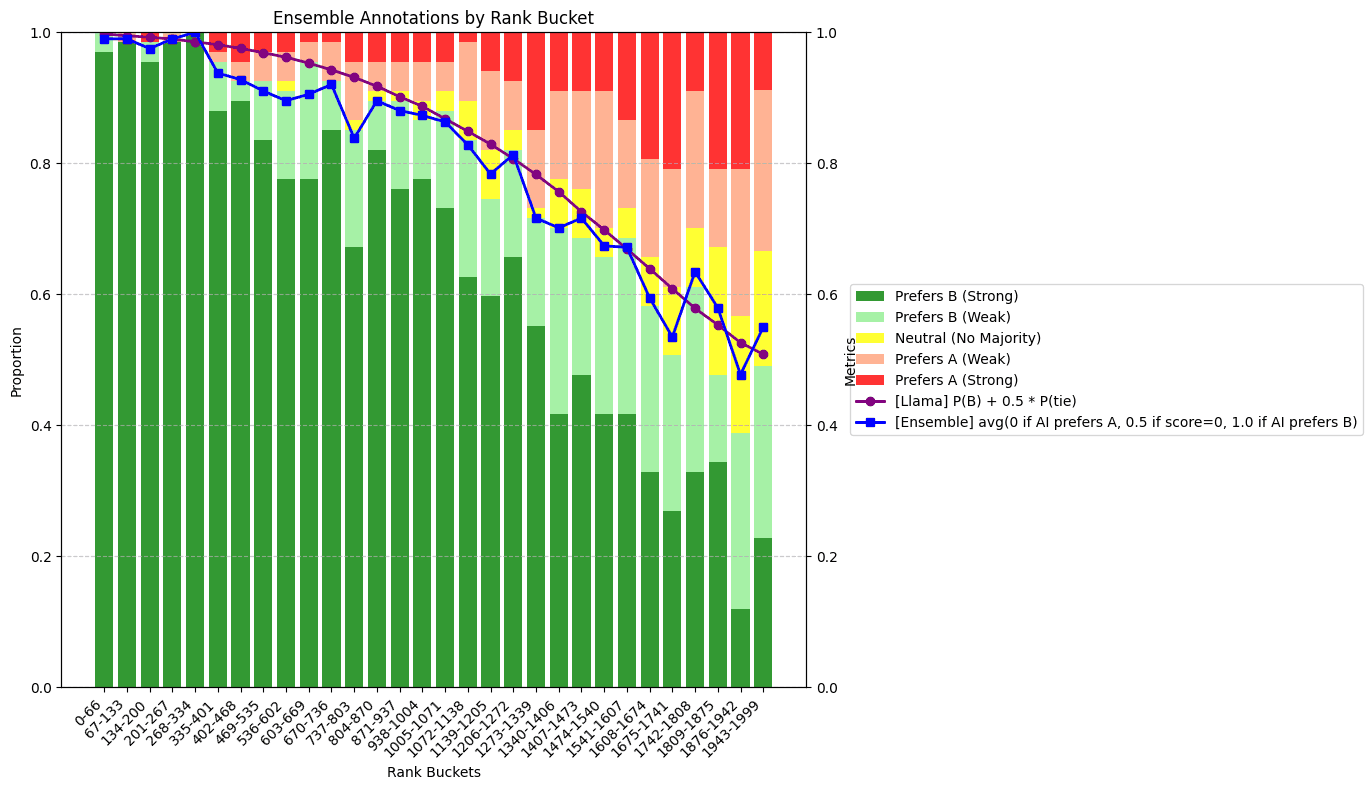

まず、調査チームは次の3つを使用した。 LLM 多数の文書ペアに対する、統合された構成モデル (d_i, d_j) メリットとデメリットを判断し [0, 1] を嗜好スコア間で比較する。このプロセスはコストがかかるので、直接適用するのではなく、高品質のトレーニングデータを生成することが目的である。

その後、このデータを使って、オープンソースの軽量モデルを微調整し、効率的な「ペアワイズコンパレータ」を訓練した。

ELO評価の取得

ELO モデルは選手を予測する i 勝者 j 確率はランクスコアの差に基づいている。 e_i - e_j.予測式はこうだ:

pij = pi / (pi + pj)

そのうちのひとつだ。p_i = 10^(e_i / 400).この式を使えば、確率とランクスコアの相関をとることができる。

(前のステップでコンパレータによって生成された)多数のペアワイズ・マッチ結果があれば、これらのマッチの結果を最もよく説明する最尤推定を以下のようにしてあてはめることが可能である。 ELO マーク e_i, e_j, ....損失関数は以下の通りである:

𝓁 = -∑i, jwijlog(pi/(pi+pj)) = ∑i, jwijlog(1+eej-ei)

実際には、各クエリに対する100の文書がすべて n² 亜比較は非現実的である。この研究では O(n) サブ比較(例えば、いくつかの無作為化されたトーナメント・ループを構築する)を行えば、完全な比較とほぼ同じ比較を得るのに十分だろう。 ELO スコア

クエリ間のバイアス調整

上記 ELO 計算は1つのクエリ内で行われるため、新たな問題が発生する:

- 良い答えがないクエリでは、最も悪い文書も高い相対値を得ます。

ELO得点(ディファレンシャルで1位)。 - 良い回答が多いクエリでは、かなり良い文書でも相対評価が低くなることがある。

ELO得点(優等生では最下位)。

これは、最終モデルのトレーニングを著しくミスリードする可能性がある。この問題を解決するために、「クロスクエリバイアス」を導入する必要がある。 b"を使用して、異なるクエリ間のスコアベンチマークを較正する。

核となるアイデアは、「同じ質問に対する2つの答え」だけでなく、「それぞれの答えを持つ2つの異なる質問」を比較できるモデルにすることである。 (q_1, d_1) 与 (q_2, d_2) どちらがより適切か。この "リンゴとオレンジ "の比較はよりノイズが多いが、異なるクエリの難易度を調整するのに必要な重要な情報を与えてくれる。より複雑な ELO モデルでは、各クエリに対して望ましいバイアスを計算することができる。 b式はおおよそ次のようになる:

P(P₁>P₂)=(p₁+b₁)/((p₁+b₁)+(p₂+b₂))。

一点モデルのトレーニング

以上のステップを踏むことで、高品質で意味のある絶対的なスコアを生み出すことができる。 f(q, d) = elo(q, d) + b(q) 関数が作成される。

最終段階は、この関数によって生成されたデータセットを使って、標準平均二乗誤差損失を通して、最終的な reranker モデリング。研究チームは Qwen モデル・ファミリーを微調整することで、最良の結果が得られる。 zerank-1 和 zerank-1-small モデル

数学的モデリングに焦点を当てる ELO 高品質なトレーニングデータを生成するためのシステムのアプローチは、次のようなものだ。 reranker 現場で探求すべきユニークで効果的な方向性。従来の方法では信頼性の低い手動の絶対採点に頼っていたために生じたノイズやボトルネックの問題を根本的に解決する。