CogVLM2は清華大学データマイニング研究グループ(THUDM)によって開発されたオープンソースのマルチモーダルモデルで、Llama3-8Bアーキテクチャをベースとしており、GPT-4Vと同等以上の性能を提供することを目指している。CogVLM2ファミリーは、テキストQ&A、文書Q&A、ビデオQ&Aなど、異なるタスクに最適化された複数のサブモデルから構成され、中国語と英語のバイリンガルだけでなく、中国語と英語のバイリンガルにも対応している。モデルはバイリンガルであるだけでなく、ユーザーがテストして適用できるように、様々なオンライン体験や展開方法を提供しています。

関連情報大型モデルで理解できる動画の長さは?スマートスペクトラムGLM-4V-Plus:2時間

機能一覧

- 図形理解高解像度画像の理解と処理をサポート。

- 重層的対話複数回の対話が可能で、複雑な対話シナリオに適しています。

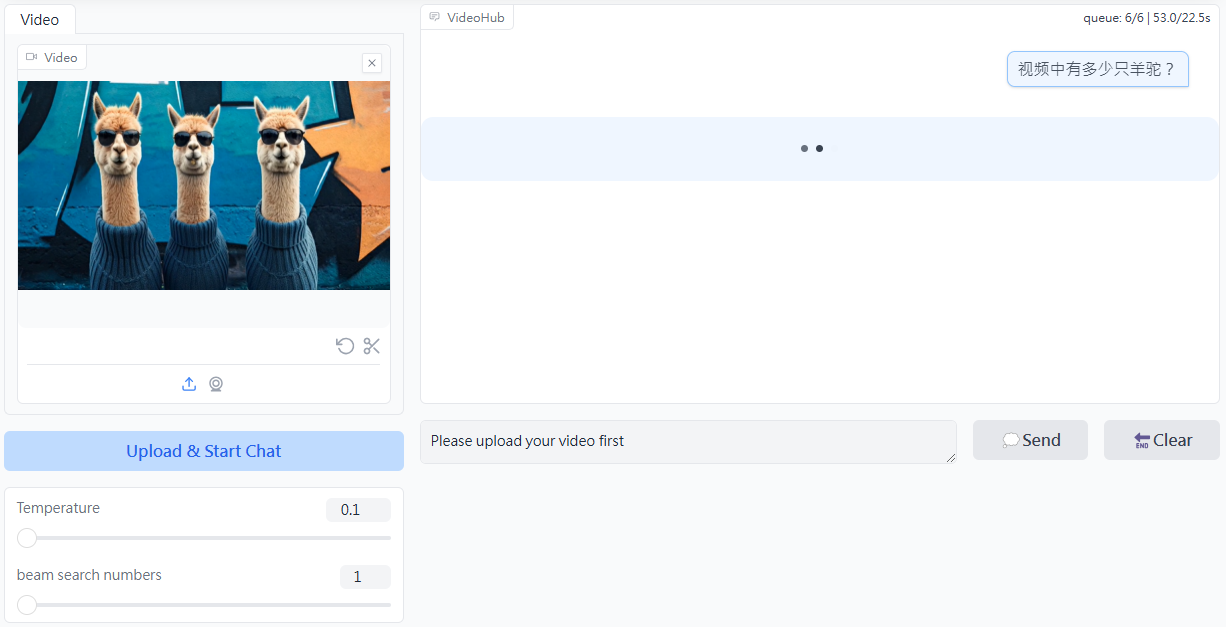

- ビデオ理解キーフレームを抽出することで、1分以内のビデオコンテンツの理解をサポートします。

- 多言語サポート異なる言語環境に適応するため、中国語と英語のバイリンガルをサポートする。

- オープンソース二次開発を容易にするために、完全なソースコードとモデルウェイトが提供されています。

- オンライン体験ユーザーがモデルの機能を直接体験できるオンライン・デモ・プラットフォームを提供します。

- 複数の配備オプションHuggingface、ModelScope、その他のプラットフォームに対応。

ヘルプの使用

インストールと展開

- クローン倉庫:

git clone https://github.com/THUDM/CogVLM2.git

cd CogVLM2

- 依存関係のインストール:

pip install -r requirements.txt

- モデルウェイトのダウンロード必要に応じて適切なモデルウェイトをダウンロードし、指定されたディレクトリに配置します。

使用例

図形理解

- 積載モデル:

from cogvlm2 import CogVLM2

model = CogVLM2.load('path_to_model_weights')

- プロセスイメージ:

image = load_image('path_to_image')

result = model.predict(image)

print(result)

重層的対話

- ダイアログの初期化:

conversation = model.start_conversation()

- ダイアログを開く:

response = conversation.ask('你的问题')

print(response)

ビデオ理解

- ビデオを読み込む:

video = load_video('path_to_video')

result = model.predict(video)

print(result)

オンライン体験

ユーザーはCogVLM2オンライン・デモ・プラットフォームにアクセスし、ローカルに配置することなくオンラインでモデルの機能を体験することができる。