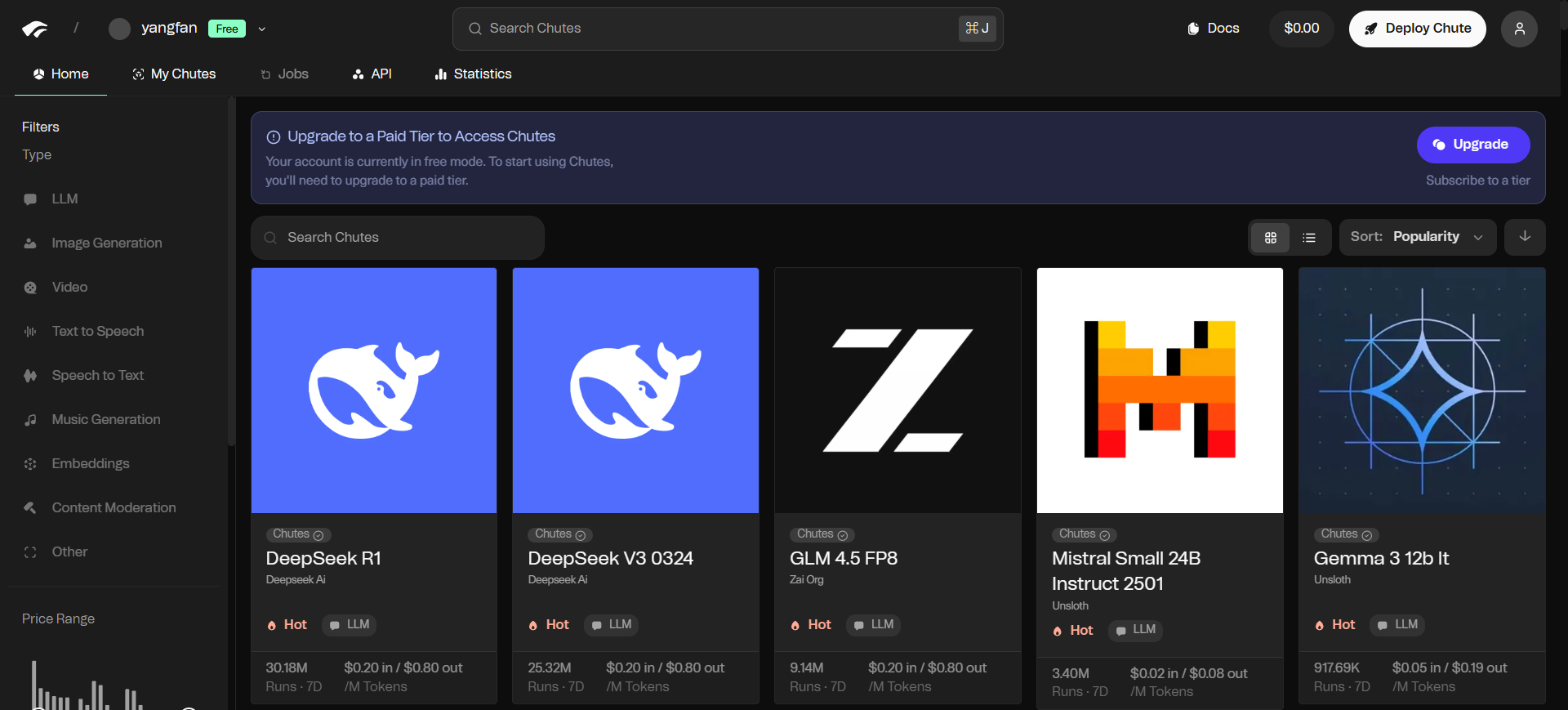

Chutesは、開発者向けのAIモデル・コンピューティング・プラットフォームである。 分散型のオープンソースアーキテクチャに基づいており、ユーザーは複雑なサーバーを自分で管理する必要がない。 このプラットフォームを利用することで、開発者は大規模な言語モデルや画像生成モデルなど、さまざまなオープンソースのAIモデルを迅速にデプロイし、実行することができる。 Chutes.aiはサーバーレス・コンピューティング環境を提供する。つまり、ユーザーはコードをアップロードするだけで、あとはプラットフォームが実行とスケーリングのタスクを処理する。 Chutes.aiは、利用した分だけ支払う従量課金モデルを採用しており、柔軟なコンピューティング・リソースを必要とする新興企業や個人研究者にとっては、コスト削減となる。 このプラットフォームは、世界中のGPUリソースを統合することで、AI推論タスクに安定的かつ効率的な計算サポートを提供する。

機能一覧

- サーバーレス展開ユーザーは、サーバーの設定や管理をすることなく、どのようなAIモデルでも導入することができます。

- 急速な拡大:: システムは、ワークロードの需要に基づいてコンピューティングリソースを自動的に調整することができます。

- 複数のモデルをサポートこのプラットフォームは、大規模言語モデル(LLM)に限らず、画像、動画、音声、音楽、3Dモデリングなど、幅広いAIアプリケーションをサポートしています。

- カスタマイズされた環境ユーザーは自分のコードをアップロードしたり、Dockerコンテナを使ってオープンソースのモデルを実行することができます。

- APIファーストあらゆるアプリケーションやシステムに機能を簡単に統合できる、クリーンなAPIインターフェースを提供します。

- モデルライブラリ:: このプラットフォームは最新のオープンソースモデルを提供し、リリース後すぐに稼働することが多い。

- 必要に応じて支払うお支払いは、実際の計算要求量に基づいており、さまざまなレベルのサブスクリプションプランをご利用いただけます。

- 分散型ネットワークBittensorネットワークの上に構築され、計算サービスを提供するために分散GPUリソースを利用します。

ヘルプの使用

Chutes.aiプラットフォームは、AIモデルのデプロイと利用のプロセスを簡素化し、クラウドサービス管理の専門知識がない開発者でもすぐに始められるようにする。その中核は、ユーザーがモデルとコード自体に集中するだけでよいサーバーレス環境を提供することだ。

APIキーの登録と取得

- Chutes.aiの公式サイトにアクセスし、アカウントを作成する。

- ログインしたら、アカウントダッシュボードまたは設定ページでAPI管理セクションを見つけます。

- 新しいAPIキーを生成します。このキーは、プラットフォームのコンピューティングリソースにアクセスするための認証情報ですので、安全に保管してください。

API経由でモデルを使用する方法

Chutes.aiはOpenAIのAPIフォーマットと互換性があるので、切り替えや統合がとても簡単です。OpenAIのAPIを使ったことがあれば、コードの変更はほとんど必要ありません。

ステップ1:リクエストアドレスの設定

あなたのコードで要求された宛先URLを、Chutes.aiが提供するプロキシアドレスに置き換えてください:

https://llm.chutes.ai/v1/chat/completions

ステップ2:APIキーの設定

リクエストのヘッダー(Headers)で、APIキーをBearer Tokenとして認証する。

Authorization: Bearer YOUR_CHUTES_API_KEY

ステップ3:モデルの指定

リクエスト本体(Body)のJSONデータではmodelフィールドは、使用するモデルを指定します。例えば、DeepSeek のモデルの 1 つを使用する場合は、次のように設定します:

"model": "deepseek-ai/DeepSeek-V3"

以下は、cURLを使ってリクエストを送信する例である:

curl -X POST https://llm.chutes.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_CHUTES_API_KEY" \

-d '{

"model": "deepseek-ai/DeepSeek-V3",

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello! Can you tell me a joke?"

}

]

}'

のコードを変更する必要があります。YOUR_CHUTES_API_KEYキーを自分のものと交換する。

サードパーティアプリケーションでの使用

Chutes.aiは、Janitor AIやKoboldAIなど、カスタムモデルのインターフェースをサポートするサードパーティ製アプリケーションにも簡単に統合できる。

セットアップの手順は通常以下の通り:

- アプリの設定オプションで、APIまたはモデルコンフィギュレーションポータルを見つけます。

- オプション

自定义或兼容OpenAIAPIの種類。 - API AddressまたはProxy URLフィールドに、Chutesリクエストアドレスを入力します:

https://llm.chutes.ai/v1/chat/completions。 - API Keyフィールドに、Chutes.aiアカウントから生成されたキーを入力します。

- モデル名フィールドに、使用するシュート・プラットフォームのモデル識別子を入力します。

deepseek-ai/DeepSeek-V3。

設定が保存されると、アプリはChutes.aiの計算ネットワークを介してAIモデルを実行する。

独自のモデルを展開する

カスタムモデルを実行する必要がある上級ユーザーのために、Chutes.aiは独自のコードやDockerコンテナをアップロードすることができます。カスタムの "Chute"(コンテナ)をパッケージングしてデプロイする方法については、公式ドキュメントに詳しい説明があります。このプロセスでは通常、モデルと関連する依存関係を標準のコンテナ・イメージにパッケージ化する必要があります。

アプリケーションシナリオ

- AIアプリケーションのラピッドプロトタイピング

アイデアを素早く検証する必要がある新興企業や開発者にとって、Chutes.aiは基盤となる設備を気にする必要のない環境を提供する。開発者はアプリケーション・ロジックとユーザー・エクスペリエンスに集中し、プラットフォームの既存のオープンソース・モデルを使用して、機能的なプロトタイプを素早く構築することができる。 - 既存のアプリケーションでAI機能を拡張する

既存のウェブサイトやアプリにAI機能(スマート接客、コンテンツ推薦、テキスト要約など)を統合する必要がある場合、開発者はChutes.aiのAPIインターフェースを呼び出すことで、高額なハードウェアやメンテナンスコストをかけることなく、製品に強力なモデリング機能を簡単に追加することができる。 - 学術研究と実験

chutes.aiの従量課金モデルと柔軟なモデルサポートは、学術研究を促進します。研究者は、いつでも、管理しやすいコストで、環境設定に時間を費やすことなく、実験のために最新のオープンソースモデルを呼び出すことができます。 - 大規模データタスクの処理

大規模なテキスト埋め込み、データ分析、画像処理を必要とするタスクには、Chutes.aiの近日リリース予定のロングジョブ機能を利用することができる。ユーザーはバッチタスクを送信し、プラットフォームの分散コンピューティングリソースを使用して効率的に作業を完了することができます。

QA

- Chutes.aiは、従来のクラウドプロバイダー(AWSやGoogle Cloudなど)が提供するAIサービスとどう違うのですか?

従来のクラウドサービスプロバイダーは通常、仮想マシン、コンテナインスタンス、ネットワークをユーザー自身で設定・管理する必要があり、これは複雑なプロセスだ。chutes.aiは、基盤となる技術的な詳細をすべてカプセル化したサーバーレスコンピューティングサービスを提供する。ユーザーはモデルを直接デプロイして呼び出すことができ、プラットフォームがリソースの割り当てとスケーリングを自動的に処理するため、利用の敷居が大幅に下がる。 - プラットフォームにおける「分散型」とはどういう意味ですか?

"分散型 "とは、Chutes.aiのコンピューティング・リソースが単一のデータセンターから提供されているのではなく、世界中に分散するGPUプロバイダーのネットワークから構成されていることを意味する。 この構造は、システムの安定性と耐障害性を向上させるとともに、理論的には競争メカニズムを通じてよりコスト効率の高いコンピューティング・サービスを提供する。 - モデルのデータをChutes.aiで実行しても安全ですか?

Chutes.aiは、ユーザーのコードを隔離された環境で実行することでセキュリティを確保する。 同プラットフォームはまた、Trusted Execution Environment(TEE)ベースの機密コンピューティング機能の導入も計画しており、機密データを扱うユーザーに、より高度なデータプライバシー保護を提供する。 - 使用したいモデルがプラットフォームで利用できない場合はどうすればよいですか?

Chutes.aiでは、ユーザーが独自のモデルを追加することができます。任意のオープンソースモデルをDockerコンテナにパッケージし、プラットフォーム上で実行するためにデプロイすることができます。