序文

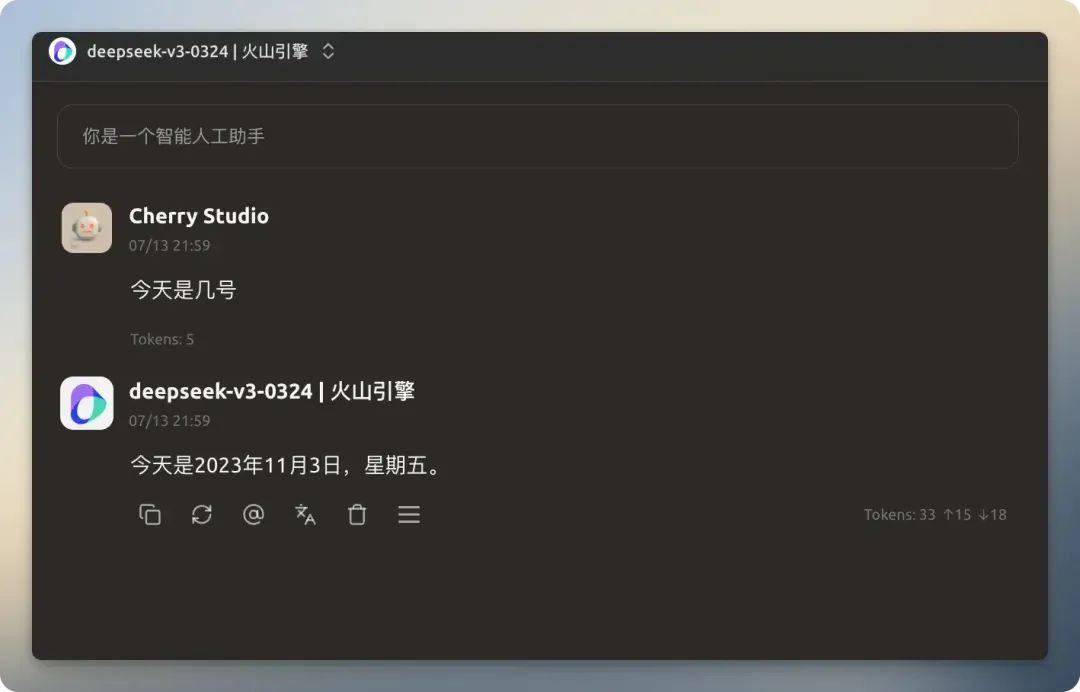

ラージ・ランゲージ・モデル(LLM)の知識は、学習データのカットオフ・デートによって制限される。例えば、2025年1月以前に学習したモデルは、それ以降に発生した事象、例えば現在の日付に関する質問には答えることができない。リアルタイムの情報に基づいた回答を可能にするネットワーク検索機能をモデルに与えることで、その適用シナリオを大幅に拡大し、回答の精度を向上させることができる。 Cherry Studio どのモデルでもインターネットに接続できるように設計された、ネットワーク検索機能のセットが提供されている。

この記事では、その詳細について説明する。 Cherry Studio ネットワーク検索機能では、詳細な設定と実践ガイドを提供しています。

機能構成

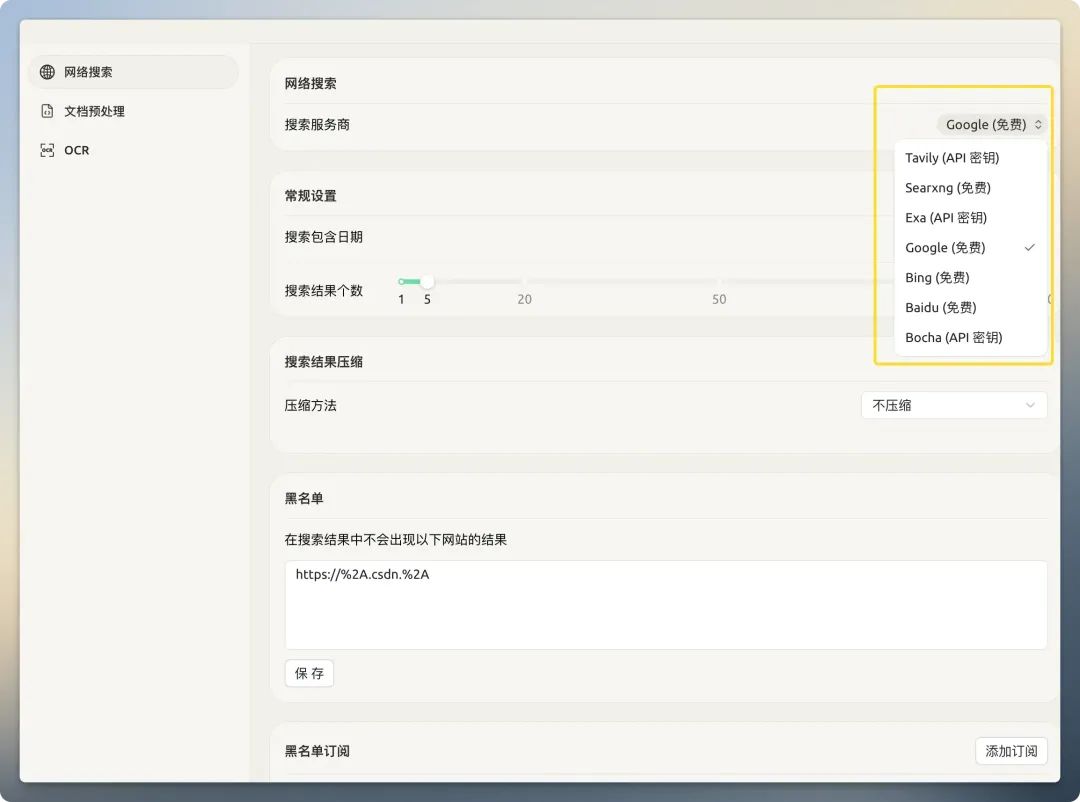

ネットワーク検索を使用する前に、適宜設定する必要があります。を開く。 Cherry Studio 設定画面では、右側のエリアにウェブ検索関連のすべてのオプションが集約されている。

検索サービスプロバイダー

Cherry Studio さまざまな検索プロバイダーが組み込まれている。それらは大きく2つのカテゴリーに分けられる:従来の検索エンジン(例 百度、谷歌、必应そしてAIネイティブ検索エンジン(例 Tavily、Exa)。

従来の検索エンジン返されるのは、人間が視覚的に読むためにデザインされた完全なウェブページであり、ナビゲーション・バー、広告、スクリプトなど、核となるコンテンツとは関係のない多くの「ノイズ」を含んでいる。このような情報を直接AIモデルに与えると、トークンのコストが劇的に増加するだけでなく、情報汚染によって回答の質も低下する。

AIネイティブ検索エンジン一方、彼らは大規模な言語モデルの提供を専門としている。バックエンドで検索結果を前処理して最適化し、機械が直接利用するのに適した、クリーンで洗練された構造化テキストデータを返す。

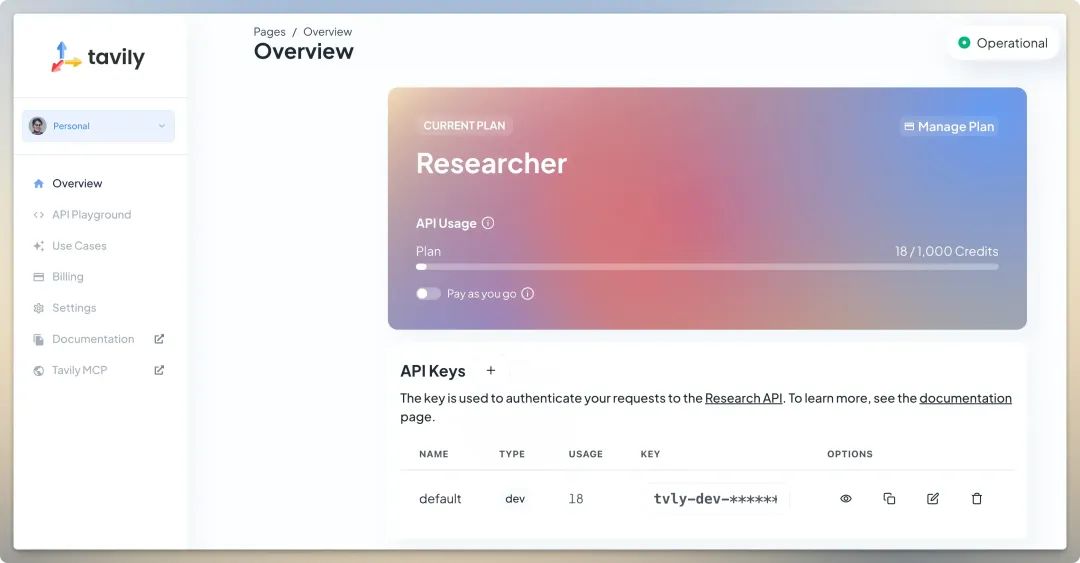

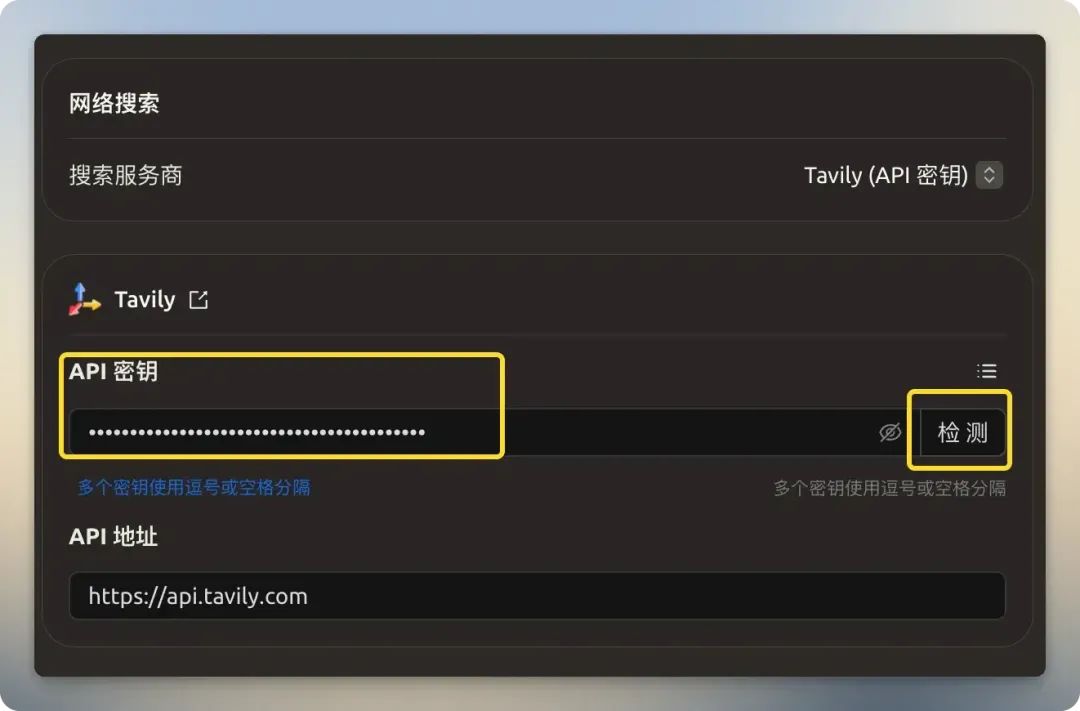

Tavily

Tavily は、大規模言語モデルの検索APIに特化したサービス・プロバイダーである。その中核となる強みは、高度に関連し、洗練され、構造化されたデータを返す能力であり、従来のウェブページから無関係な情報をフィルタリングし、モデルに供給されるコンテキストのサイズとコストを削減する。Tavily の無料プランでは、毎月1,000のAPIコールがクレジットカードのバインディングなしで提供され、中国国内での直接アクセスが可能だ。サインアップ後、バックエンドでAPIキーを取得し、適切なフィールドに入力するだけです。

Searxng

Searxng は、オープンソースのメタ検索エンジン (https://github.com/searxng/searxng)は、複数の検索サービスからの結果を集約する。ユーザーは、より高いプライバシーと制御のために、その公式ドキュメントを参照して、自分自身でサービスを展開することができる。

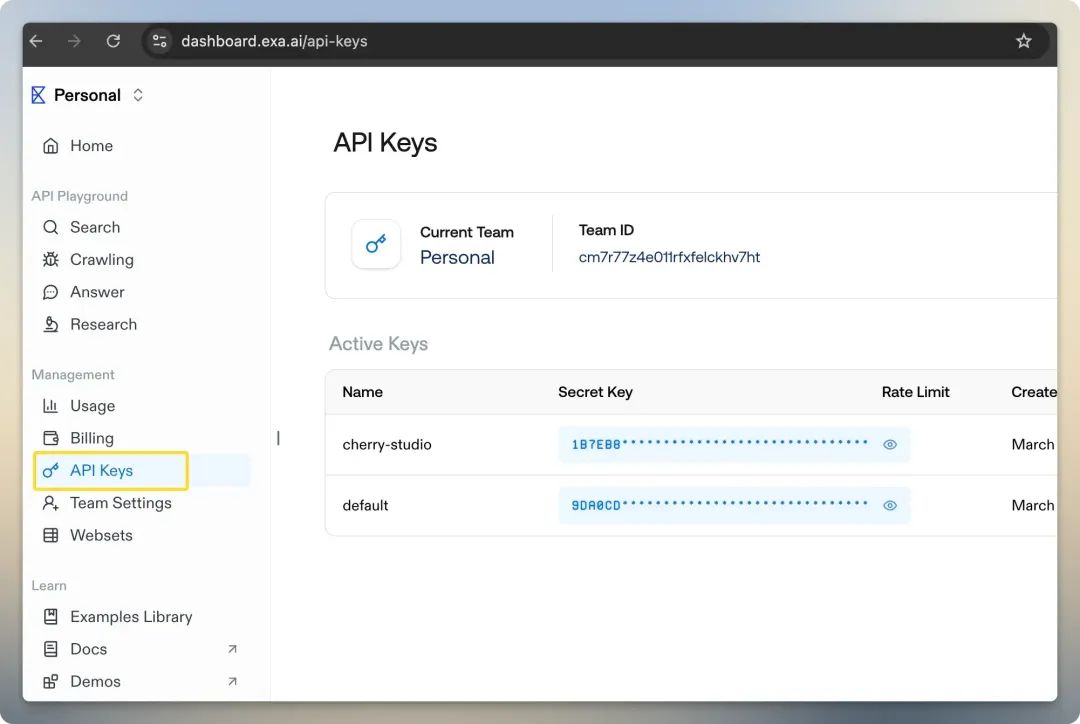

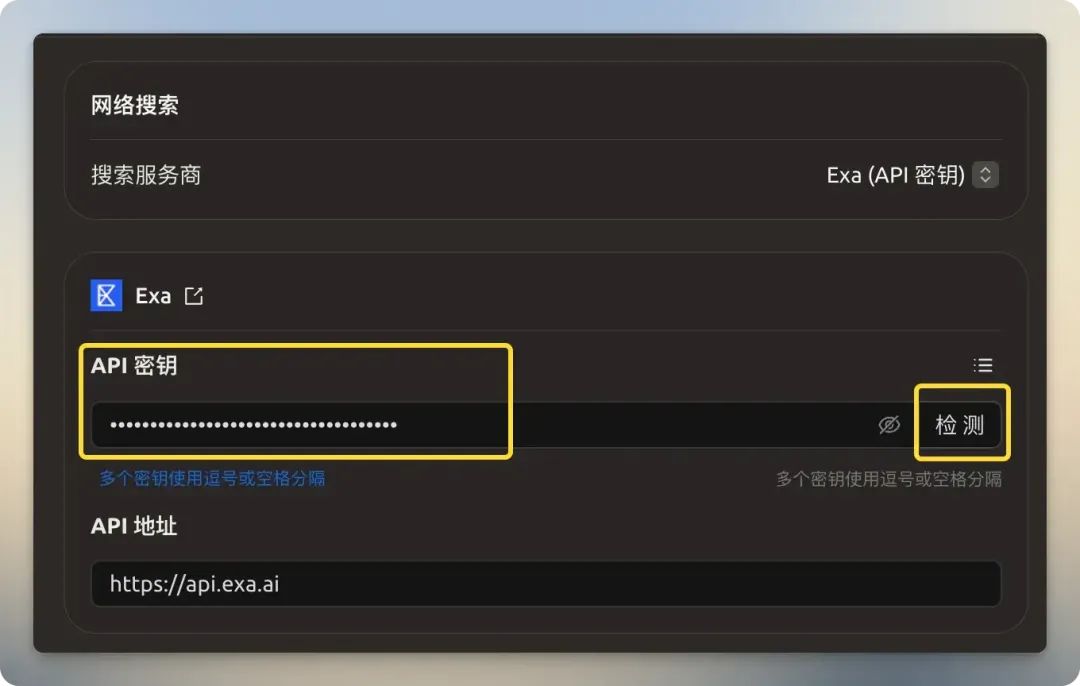

Exa

Exa (旧Metaphor)もAI指向の検索プロバイダーで、その最大の特徴は「セマンティクス」に基づくニューラル検索を提供していることだ。キーワードのマッチングに依存する従来の検索とは異なりExa クエリの背後にある真の意図をよりよく理解し(例えば、「AI携帯電話の未来はどうなるのか」と検索すると、これはオープンエンドで概念的な質問であることを理解する)、より深く、より関連性の高い結果を見つけることができる。また、エッセイのようなドメインに特化した検索もサポートしている、Github 倉庫とウィキペディア。新規ユーザーには10ドル分のクレジットが無料で提供される。

Bocha

国内 博查 また、マルチモーダルAI検索APIサービスも提供しているが、そのサービスは純粋な有料モデルであり、無料クレジットはない。

最近発表された Bing Search APIの廃止が迫る中、Secret Tower APIが新たな選択肢となる可能性はあるのだろうか?また、新しいオプションもある。

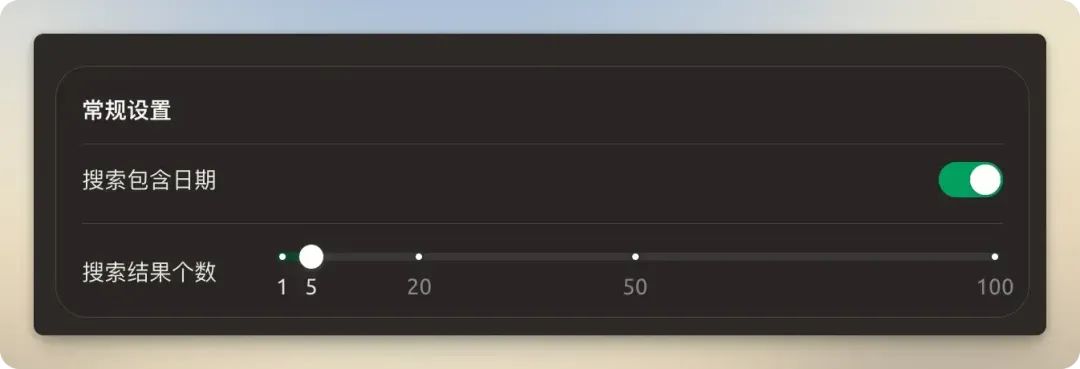

一般設定

スイッチオン推奨 「日付を含む検索 オプションで最新情報を確認できる。検索結果の数はデフォルトの5のままにしておくことを推奨します。検索結果の件数を多く設定しすぎると、トークンの消費量が増えるだけでなく、モデルのコンテキスト・ウィンドウを超えてしまい、処理に失敗する可能性があります。

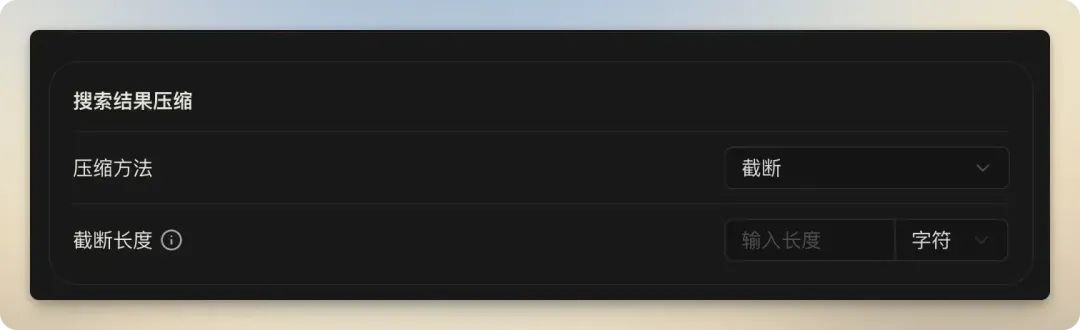

検索結果 圧縮

この機能は、検索されたウェブページのコンテンツを処理し、モデルの文脈上の制約に合うように絞り込むために使用される。これら3つのオプションの違いを理解することは、コネクテッド・サーチの効果とコストを最適化する上で非常に重要である。

| 圧縮方式 | バンテージ | 欠点 | 適用シナリオ |

|---|---|---|---|

| 非圧縮 | 導入が簡単で、処理が速い。 | モデルのコンテキストの制限を超える可能性が高く、トークンのコストが高い。 | モデルコンテキストウィンドウが非常に大きく、検索結果ページが非常にきれいな場合にのみ利用できる。 |

| 切り捨てる | コントロールはシンプルかつ直接的で、オーバーランを効果的に回避できる。 | 重要な情報が入手できる前にコンテンツが遮断され、結果として情報が失われる可能性がある。 | 限られたコンテキストウィンドウでモデルを高速、低コストで検索するが、不完全な情報のリスクを受け入れる。 |

| RAG | 最高の精度で、最も関連性の高い情報をピンポイントで提供し、「AIの錯覚」を効果的に抑える。 | コンフィギュレーションと計算は比較的複雑で、エンベッディングモデルにいくつかの要件がある。 | 答えの質が高い真剣な問い合わせには、この方法が断然先進的でお勧めだ。 |

- 非圧縮オリジナルのウェブコンテンツをモデルに直接提供します。

- 切り捨てる: 文字数やトークン数を設定することで、特別に長いコンテンツをハード 的に切り捨てる。これはシンプルで強引な制御方法だが、切り捨てられた部分に重要な情報が含まれている可能性があるというリスクがある。

- RAGこのオプションは単なる「圧縮」ではない。 検索強化世代(検索拡張世代)。

RAGは高度なAIフレームワークであり、まず外部の知識ベースから関連情報を取得し、次にこの情報をユーザーの元の質問とともにモデルに送信することで、より正確で信頼性の高い回答を生成するようモデルを導く。その動作原理は次のように単純化できる。 モデルの埋め込み 検索されたテキストチャンクとユーザーの質問はすべて数値ベクトルに変換され、ユーザーの質問に最も関連するテキストスニペットを見つけるために、ベクトル空間で類似度が計算される。最後に、これらの関連性の高いセグメントのみが、より大きなモデルのコンテキストとして提供されます。これは、モデルに「オープンブック試験」を受けさせ、正解のページを直接めくるようなもので、最新のデータを効率的に利用し、モデルが「幻覚」(事実をでっち上げること)を見る可能性を大幅に減らします。セレクションRAG圧縮方式を設定した後、次の設定も必要です。Embeddingモデルや埋め込み次元などのパラメータ。

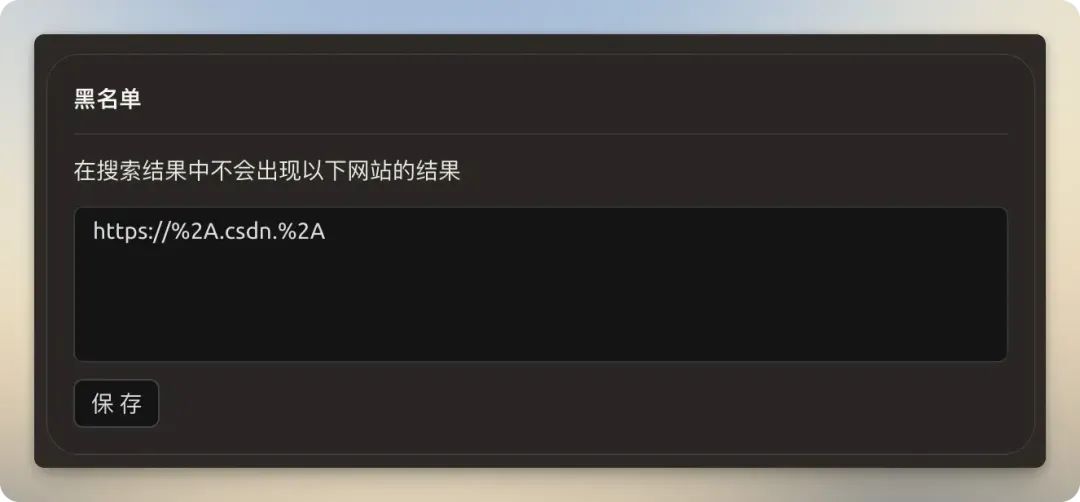

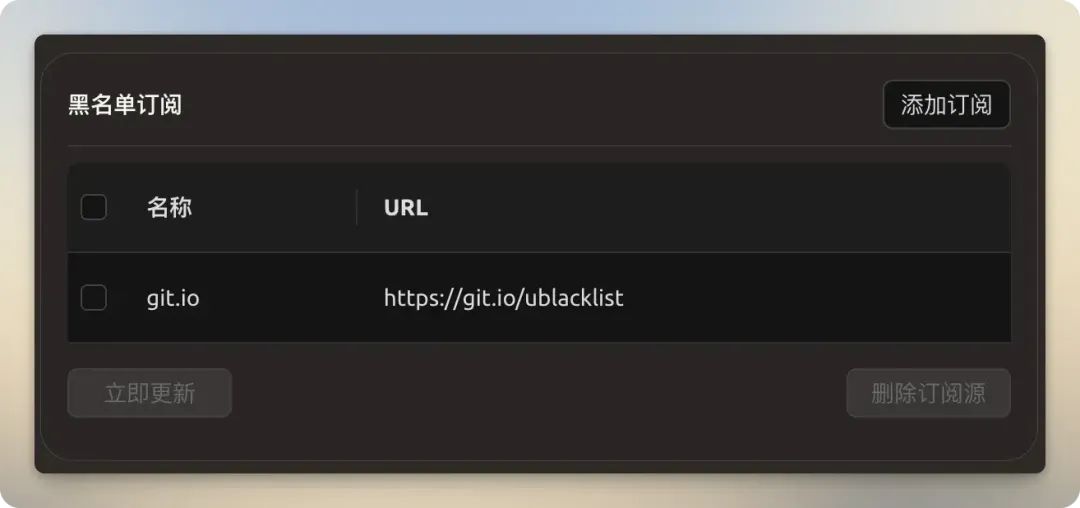

ブラックリストと購読

- ブラックリスト例えば、低品質なコンテンツを含むサイトをブロックするなど。

- ブラックリスト購読コミュニティが管理するブラックリストに登録されたリンク(例えば

https://git.io/ublacklist)、低品質なウェブサイトやスパムウェブサイトをひとつひとつ手動で追加することなく、一括してブロックすることができます。

実地訓練

Cherry Studio 接続された検索は、モデル内蔵の検索とサードパーティの検索サービスの2つに分類される。

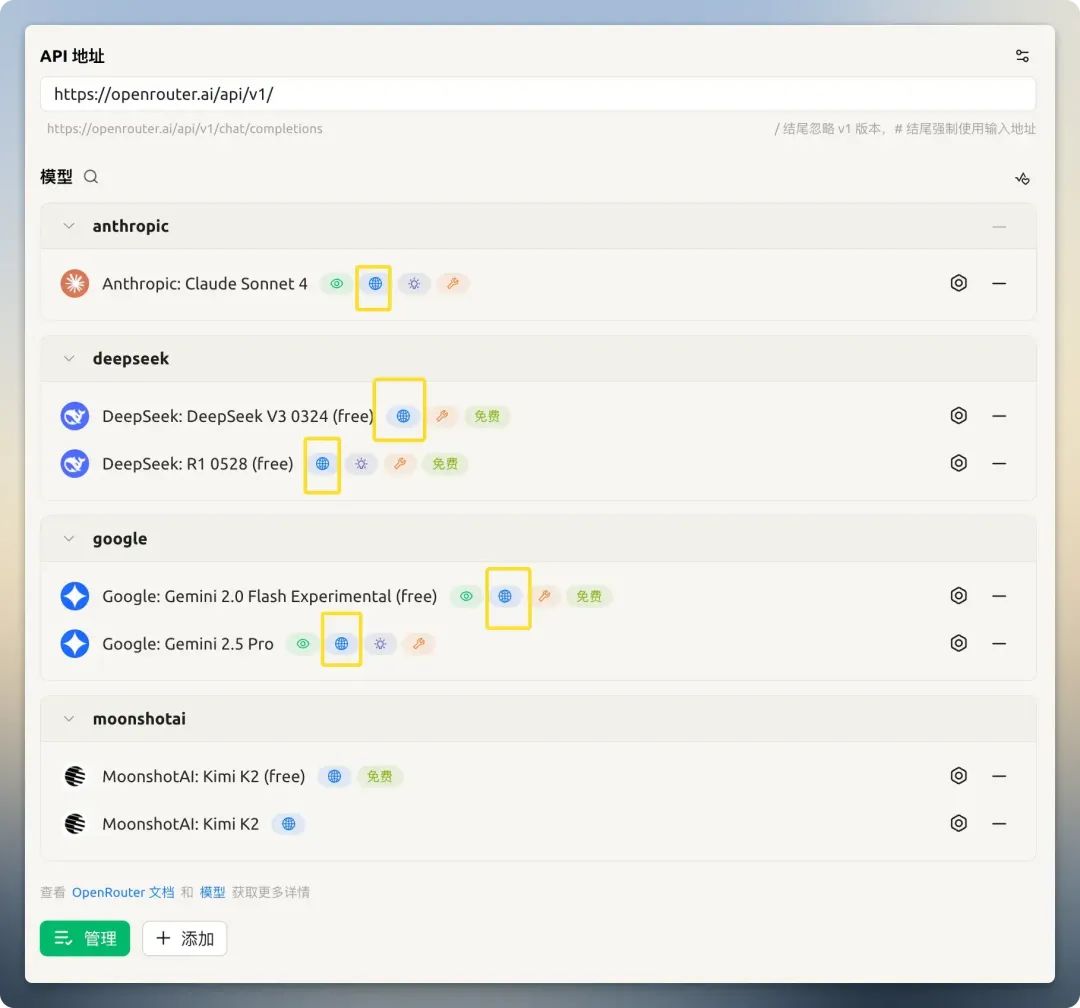

モデル内蔵検索

一部のモデルプロバイダー(例えば OpenRouter)は、そのモデルに内蔵されたネットワーク検索機能を統合した。この機能はモデル設定で直接オンにすることができる。

以 OpenRouter 無料モデル提供 Kimi K2 一例として、検索がオフの場合、現在の日付を答えることができない。検索がオンの場合、正しく答え、情報源を提供する。ネットワーキングをサポートすると言いながら、実際には効果がなかったり、正しく機能しなかったりするモデルもあることに注意することが重要である(例えば、特定の GitHub Models)。

適当な無料ビッグモデルAPIが見つからない場合は、ここで選ぶことができます:無料ビッグモデルAPIリスト

第三者検索サービス

検索機能が内蔵されていないモデルの場合、サードパーティの検索サービスがカギとなる。しかし、それを利用するには主に2つの問題がある:

- トークン消費の増加

- モデルコンテキストの制限を超える長い検索結果による失敗

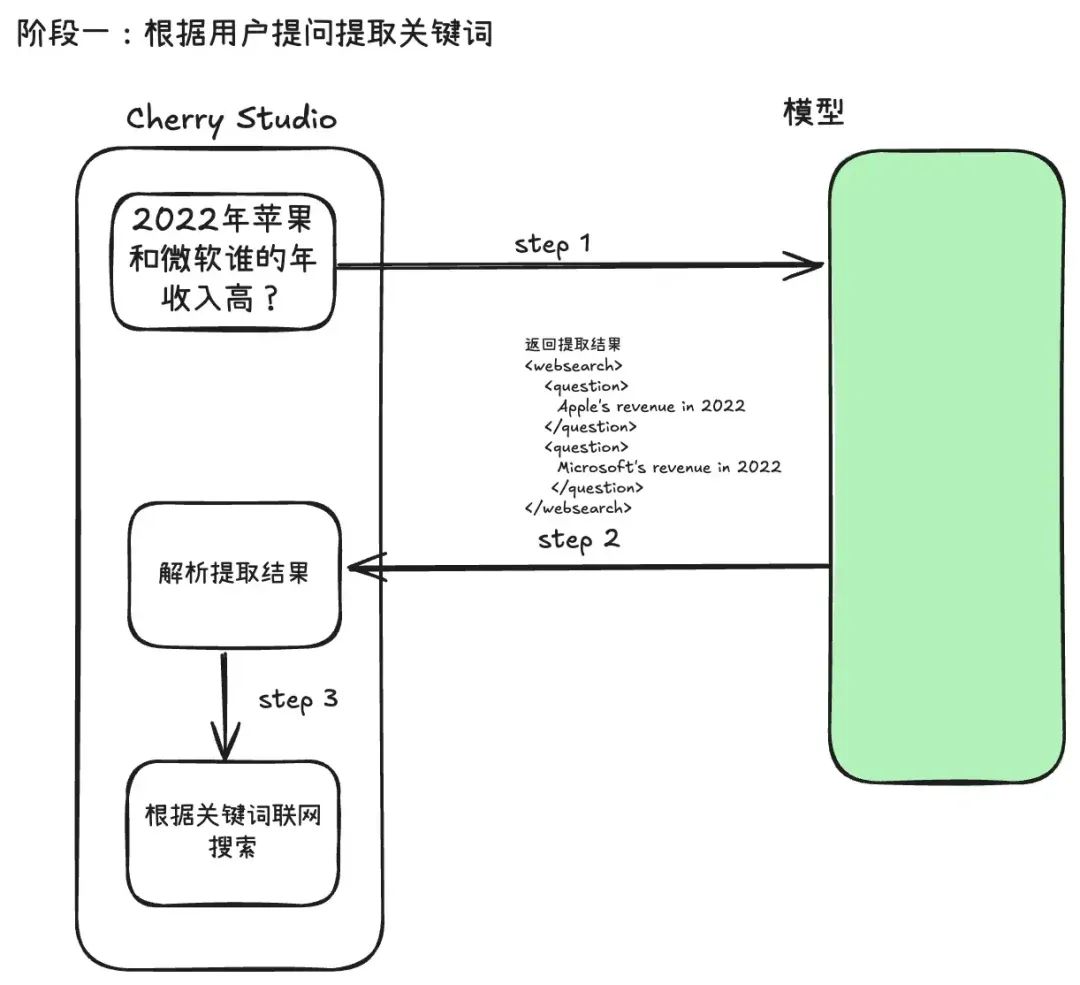

Cherry Studio サードパーティの検索プロセスは2段階に分かれている:

ステージ1:検索キーワードの抽出とコンテンツの獲得

ユーザーが質問を送信すると、システムは元の質問を直接検索エンジンに投げない。その代わりに、まず一度大きなモデルを呼び出し、精巧なプロンプト・テンプレートを使って、モデルがユーザーの意図を分析し、機械検索に最適な簡潔なキーワードを抽出する。このアプローチはクエリー・リライティング(クエリー・リライティング)これは、その後の検索の精度を大幅に向上させることができる。

以下 Cherry Studio キーワード抽出器 Prompt テンプレートです。ご覧のように、XMLタグ(たとえば<websearch>)を使って、プログラムによって直接パースできる構造化されたコンテンツをモデルに出力させることができる。

You are an AI question rephraser. Your role is to rephrase follow-up queries from a conversation into standalone queries that can be used by another LLM to retrieve information through web search.

**Use user's language to rephrase the question.**

Follow these guidelines:

1. If the question is a simple writing task, greeting (e.g., Hi, Hello, How are you), or does not require searching for information (unless the greeting contains a follow-up question), return 'not_needed' in the 'question' XML block. This indicates that no search is required.

2. If the user asks a question related to a specific URL, PDF, or webpage, include the links in the 'links' XML block and the question in the 'question' XML block. If the request is to summarize content from a URL or PDF, return 'summarize' in the 'question' XML block and include the relevant links in the 'links' XML block.

3. For websearch, You need extract keywords into 'question' XML block.

4. Always return the rephrased question inside the 'question' XML block. If there are no links in the follow-up question, do not insert a 'links' XML block in your response.

5. Always wrap the rephrased question in the appropriate XML blocks: use <websearch></websearch> for queries requiring real-time or external information. Ensure that the rephrased question is always contained within a <question></question> block inside the wrapper.

6. *use websearch to rephrase the question*

There are several examples attached for your reference inside the below 'examples' XML block.

<examples>

1. Follow up question: What is the capital of France

Rephrased question:`

<websearch>

<question>

Capital of France

</question>

</websearch>

`

2. Follow up question: Hi, how are you?

Rephrased question:`

<websearch>

<question>

not_needed

</question>

</websearch>

`

3. Follow up question: What is Docker?

Rephrased question: `

<websearch>

<question>

What is Docker

</question>

</websearch>

`

4. Follow up question: Can you tell me what is X from https://example.com

Rephrased question: `

<websearch>

<question>

What is X

</question>

<links>

https://example.com

</links>

</websearch>

`

5. Follow up question: Summarize the content from https://example1.com and https://example2.com

Rephrased question: `

<websearch>

<question>

summarize

</question>

<links>

https://example1.com

</links>

<links>

https://example2.com

</links>

</websearch>

`

6. Follow up question: Based on websearch, Which company had higher revenue in 2022, "Apple" or "Microsoft"?

Rephrased question: `

<websearch>

<question>

Apple's revenue in 2022

</question>

<question>

Microsoft's revenue in 2022

</question>

</websearch>

`

7. Follow up question: Based on knowledge, Fomula of Scaled Dot-Product Attention and Multi-Head Attention?

Rephrased question: `

<websearch>

<question>

not_needed

</question>

</websearch>

`

</examples>

Anything below is part of the actual conversation. Use the conversation history and the follow-up question to rephrase the follow-up question as a standalone question based on the guidelines shared above.

<conversation>

{chat_history}

</conversation>

**Use user's language to rephrase the question.**

Follow up question: {question}

Rephrased question:

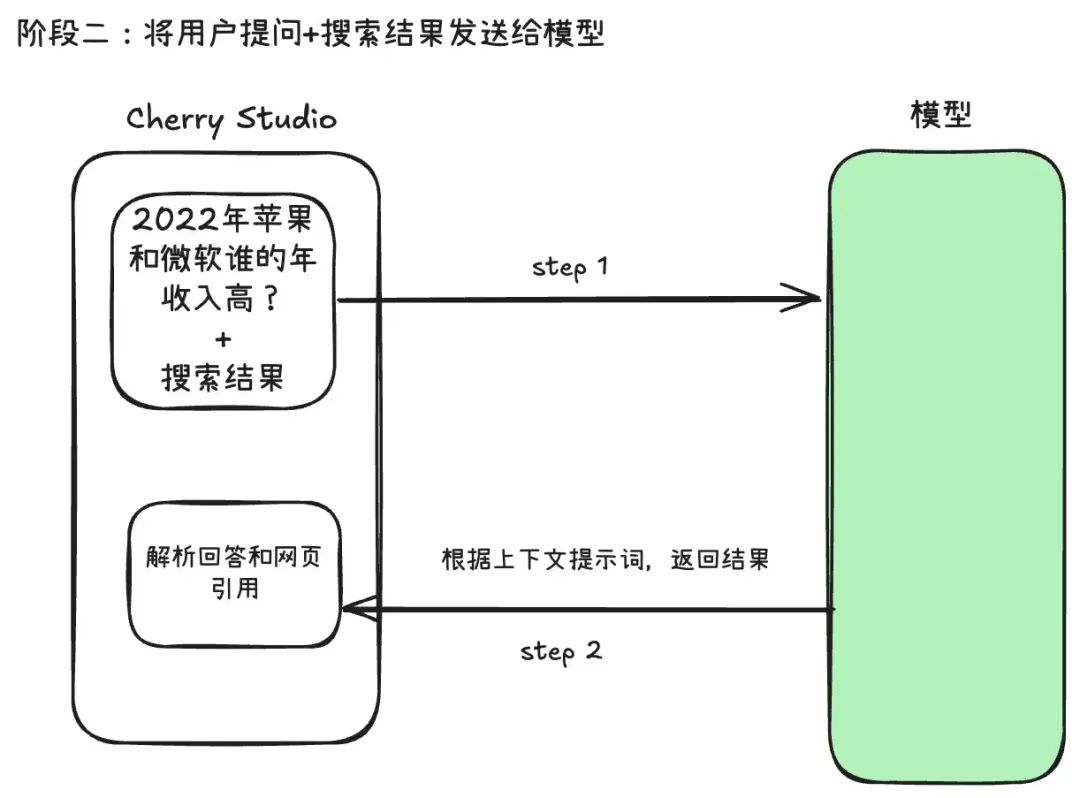

ステージ2:情報の統合と回答の生成

このシステムは、第一段階で得られたウェブコンテンツを「圧縮」し、ユーザーの元の質問と統合して再びモデルに送り、モデルがこのリアルタイムの情報に基づいて最終的な回答を生成する。

この2段階のプロセスにより、キーワード抽出のための1回のAPI呼び出しと、最終的な回答生成のための1回のAPI呼び出しという、トークンの消費量の増加が説明される。合計コストは2つの個別のダイアログのコストにほぼ等しく、2つ目のダイアログの入力には大量のウェブ検索結果も含まれます。

それが理由だ。 "圧縮方式" 設定は重要だ。選択 "カットオフ" 或 「RAG この問題に対処するためだ。

検索サービス・プロバイダーの選択が故障率に大きく影響することが、実践によって判明している。検索サービス Google、Baidu これらのような従来の検索エンジンが、処理されていない完全なHTMLページを返す場合、モデルコンテキストウィンドウが大きくてもオーバーランしやすい。代わりに Tavily 或 Exa AI用に設計されたこの種のサービス・プロバイダーは、よりクリーンで簡潔で、モデル処理に自然に適した前処理済みのデータを返すため、故障率がはるかに低い。

例えば、検索結果を20件に設定し、圧縮方法を「圧縮なし」とし、コンテキストウィンドウが小さいモデル(例えば、8,000トークン)を使用した場合、ネットワーク検索の失敗確率は大幅に増加する。

使用上の推奨事項

テスト済み。OpenRouter とグーグルの Gemini 内蔵のネットワーク検索で優れた体験を提供。サードパーティの検索サービスを使用する必要がある場合は、安定性と効率性を確保するために、以下の推奨事項に従ってください:

- モデル内蔵の検索機能の使用を優先する。モデル自体がそれをサポートしているなら、これが最もシンプルで簡単な方法だ。

- AIのために設計された検索サービスを選ぶ使用

Tavily、Exaやその他のサービス・プロバイダーよりもGoogle或Baidu.よりクリーンで関連性の高い結果を提供し、トークンの消費と処理失敗のリスクを低減します。 - 検索パラメータの合理化使用するモデルのコンテキストウィンドウのサイズに応じて慎重に設定する。 結果数 和 圧縮方式(品質を重視する場合は強くお勧めする)

RAG)を使用することで、コンテンツのオーバーランによる検索の失敗を避けることができる。