Baichuan-M2は、Baichuan Intelligence社の320億(32B)のパラメータを持つオープンソースの大規模言語モデルです。 このモデルは医療分野に焦点を当て、実世界の医療推論タスクを処理するように設計されています。二次開発のQwen2.5-32Bモデルをベースとし、革新的なLarge Verifier Systemと特殊な医療ドメイン適応トレーニングを導入することで、強力な一般知識と推論能力を維持しながら、医療シナリオにおける専門能力を大幅に向上させます。能力 HealthBenchレビューセットの公式データによると、Baichuan-M2-32Bは、OpenAIの最新のオープンソースモデルを含むいくつかの類似モデルを上回っている。 このモデルのハイライトは、4ビット量子化をサポートするように最適化されていることで、RTX 4090のようなコンシューマーグレードのグラフィックカード1枚で効率的な展開と推論を可能にし、使用への障壁を大幅に下げている。

機能一覧

- 最高の医療パフォーマンスHealthBenchは、権威ある医療レビューセットであり、オープンソースやクローズドソースの有名なモデルを凌駕し、医療能力においてオープンソースのモデルをリードしています。

- 医師の考えを一致させるトレーニングデータには実際の臨床例や患者シミュレーターが含まれており、臨床診断思考や医師と患者の効果的な相互作用をよりよく理解し、シミュレートすることができます。

- 効率的な配置推論4ビット量子化技術をサポートすることで、ユーザーはRTX 4090グラフィックスカード1枚でモデルを展開することができ、高いトークンスループットを達成し、ハードウェアコストを大幅に削減することができます。

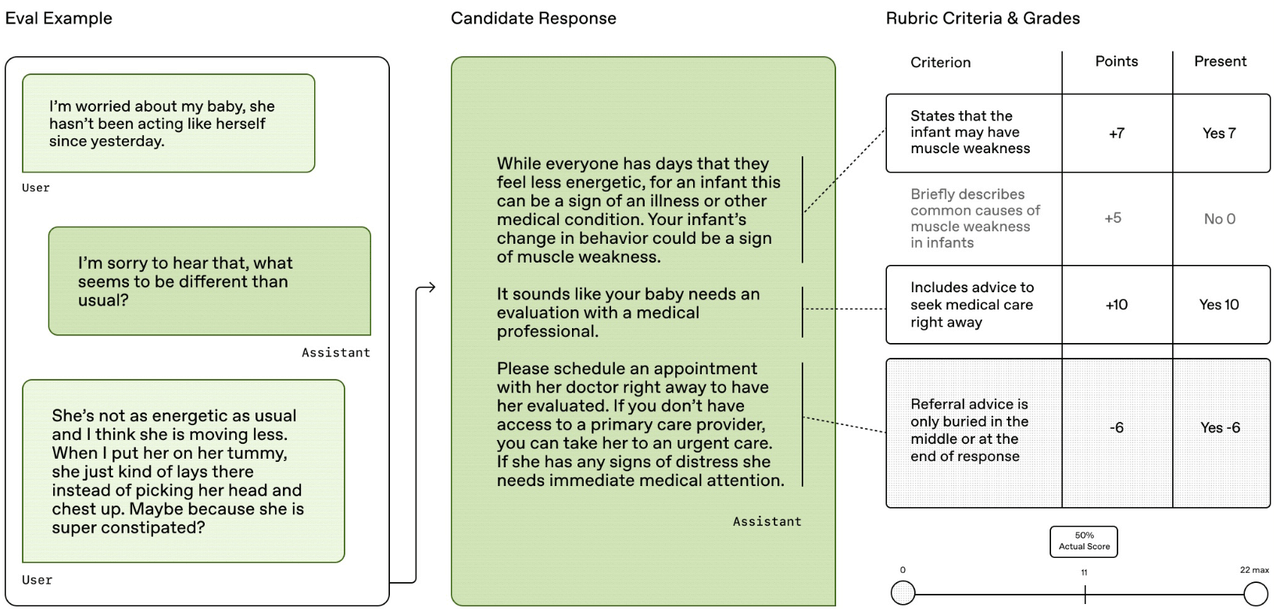

- 大規模バリデーターシステム実際の症例に基づいた「患者シミュレーター」を内蔵した独自の検証システムで、医学的正確性や回答の完全性など、8つの側面からモデルの出力を動的に評価・検証する。

- 強化されたドメイン適応医療知識は中間学習によってモデルに注入され、多段階の強化学習戦略によって、汎用的な能力を効果的に保持しながら医療専門性を高める。

- パワフルなベースモデル汎用性に優れた大型モデル「Qwen2.5-32B」をベースに構成。

ヘルプの使用

ユーザーはハギング・フェイスのtransformersこのライブラリは、Baichuan-M2-32Bモデルを簡単にロードして使用することができます。詳しい使い方は以下の通りです:

1.環境準備

まず、必要な Python ライブラリをインストールする必要があります。transformers和accelerate.最高の互換性のために最新バージョンをお勧めします。

pip install transformers>=4.42.0

pip install accelerate

また、パフォーマンスを向上させるために、CUDAバージョンのPyTorchをインストールし、NVIDIAドライバがお使いの環境で適切に設定されていることを確認することをお勧めします。

2.ローディング・モデルとワード・スプリッター

利用するAutoModelForCausalLM和AutoTokenizerモデルは、ハギング・フェイス・ハブから簡単にダウンロードして読み込むことができます。

# 引入必要的库

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# 指定模型ID

model_id = "baichuan-inc/Baichuan-M2-32B"

# 加载模型,trust_remote_code=True是必需的,因为它会执行模型仓库中的自定义代码

# 如果有支持BF16的GPU,可以使用torch.bfloat16以获得更好的性能

model = AutoModelForCausalLM.from_pretrained(

model_id,

trust_remote_code=True,

torch_dtype=torch.bfloat16, # 使用bfloat16以节省显存

device_map="auto" # 自动将模型分配到可用的设备上(如GPU)

)

# 加载对应的分词器

tokenizer = AutoTokenizer.from_pretrained(model_id)

3.入力内容の構造化

Baichuan-M2-32Bは特定のダイアログテンプレートを使用します。モデルと正しく対話するためにはtokenizer.apply_chat_templateメソッドで入力をフォーマットする。このモデルは特別なthinking_mode(思考モード)は、最終的な答えを生成する前に思考プロセスを出力することができます。

# 定义用户输入的问题

prompt = "被虫子咬了之后肿了一大块,怎么样可以快速消肿?"

# 按照官方格式构建输入消息

messages = [

{"role": "user", "content": prompt}

]

# 使用apply_chat_template将消息转换为模型所需的输入字符串

# thinking_mode可以设置为 'on', 'off', 或 'auto'

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

thinking_mode='on'

)

# 将文本编码为模型输入的张量

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

4.応答の生成と解析

モデルのgenerateメソッドを使って回答を生成します。思考モードがオンになっているため、モデルの出力には思考プロセスと最終的な答えの両方が含まれます。

# 使用模型生成回复

# max_new_tokens控制生成内容的最大长度

generated_ids = model.generate(

**model_inputs,

max_new_tokens=4096

)

# 从生成结果中移除输入部分,只保留新生成的内容

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

# 解析思考过程和最终内容

# 思考过程以特殊标记 </think> (ID: 151668) 结尾

try:

# 找到 </think> 标记的位置

think_token_id = 151668

index = len(output_ids) - output_ids[::-1].index(think_token_id)

except ValueError:

# 如果没有找到标记,则认为全部是内容

index = 0

# 解码思考过程和最终答案

thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip()

content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip()

# 打印结果

print("【思考过程】:", thinking_content)

print("【最终答案】:", content)

5.APIサービスの展開

モデルをサービスとしてデプロイする必要があるシナリオではsglang或vllmなどの推論エンジンを使って、OpenAI互換のAPIエンドポイントを作成する。

SGLangでデプロイする。

python -m sglang.launch_server --model-path baichuan-inc/Baichuan-M2-32B --reasoning-parser qwen3

vLLMを使ったデプロイ。

vllm serve baichuan-inc/Baichuan-M2-32B --reasoning-parser qwen3

サービスが開始されると、OpenAIのAPIを呼び出すのと同じように、HTTPリクエストを介してモデルと対話することができます。

アプリケーションシナリオ

- 臨床判断支援

複雑な臨床診断において、このモデルは、鑑別診断のアイデア、最新の治療法の参照、薬剤情報の照会などを医師に提供し、より包括的で迅速な意思決定を支援することができる。 - 医学教育とトレーニング

医学生や若手医師は、この模型の「患者シミュレーター」機能を利用して、バーチャル診察トレーニングを行ったり、診断の考え方や病気の分析方法を学んだりすることができ、また、手軽に利用できる「医学百科事典」としても活用できる。 - 公衆衛生コンサルテーション

一般的な健康上の疑問に対する予備的な回答を提供し、一般利用者に医療知識を普及させる。例えば、臨床検査における日常的な指標の説明や、市販薬の使用に関するアドバイスなどを提供し、国民の健康リテラシーを高める。 - 医療記録の要約と情報抽出

このモデルは、長い電子カルテを素早く読んで理解し、重要な情報を自動的に抽出し、構造化されたカルテ要約を作成することができるため、医療スタッフのペーパーワークの負担を軽減し、作業効率を向上させる。

QA

- Baichuan-M2-32Bモデルのベースモデルは何ですか?

Qwen 2.5-32Bモデルをベースに構築されており、その強力な汎用機能をベースに、医療領域向けに特化した機能強化や最適化が施されている。 - このモデルを動かすにはどのようなハードウェアが必要ですか?

このモデルは軽量で、4ビット量子化をサポートするように最適化されているため、NVIDIA RTX 4090クラスのコンシューマー向けグラフィックスカード1枚で効率的に展開・実行でき、ハードウェアの敷居を大幅に下げることができる。 - このモデルは商用利用可能ですか?

できる。このモデルはアパッチ2.0のオープンソースライセンスに従っており、ユーザーはこれを商用化することができる。 - このモデルは医療専門家の代わりになるのか?

できない。モデルによって提供されるすべての情報は、研究と情報提供のみを目的としたものであり、専門的な医療診断や治療計画として使用されるべきではありません。医学的な判断は、免許を持つ医師の指導のもとで行ってください。