ARGOは、"ローカルファースト "を基本設計コンセプトとするオープンソースのAIエージェント・プラットフォームであり、ユーザーは自分のPC上で強力な専用AIアシスタントを構築することができる。このプラットフォームには、AIが自律的に思考しタスクを計画することを可能にするマルチインテリジェンスシステム、ローカルの知識ベースへのアクセスを容易にするRAG技術、ローカルの大規模言語モデルのワンクリックでのダウンロードと管理など、AI分野における様々な先進技術が統合されています。ARGOは、Windows、macOS、Linuxなどの主要なデスクトップOSをサポートし、Dockerのデプロイ方法も提供します。スーパーAIインテリジェンスを誰もが簡単に持てるようにすることを目指している。

機能一覧

- ローカライゼーションとプライバシーソフトウェアは完全なオフライン操作をサポートし、すべてのユーザーデータ100%は、プライバシーとセキュリティを確保するためにローカルコンピュータに保存されます。すぐに使えるWindows、macOS、Linuxクライアントが用意されています。

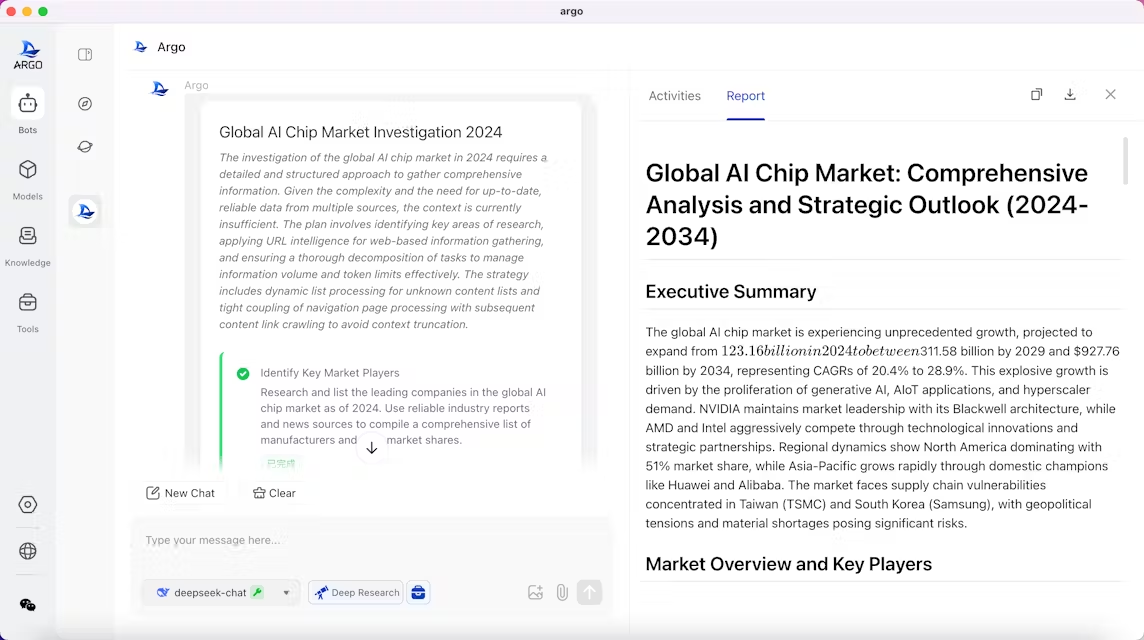

- マルチインテリジェンス・コラボレーションマルチインテリジェンス・タスクエンジンを内蔵し、チームのようなコラボレーションが可能。自律的にユーザーの意図を理解し、タスクのステップを計画し、多段階の作業を実行し、最終的にレポートを生成することができます。

- インテリゲンチャのカスタマイズ例えば、旅行計画アシスタント、業界アナリスト、法律アドバイザーなどです。簡単な説明で、特定のシナリオのためにAIアシスタントをカスタマイズすることが可能です。

- 多くの大型モデルに対応内蔵のOllamaを使えば、ワンクリックでオープンソースのビッグモデルをダウンロードして実行できます。また、OpenAI、Claude、DeepSeek、その他多くのクローズドソースモデルのAPIへのアクセスもサポートしており、ユーザーは必要に応じてローカルモデルとクラウドAPIモデルを柔軟に切り替えることができます。

- ローカルRAG知識ベースエンジンファイル、フォルダ、ウェブサイト、その他のチャネルからのナレッジのインポートをサポートします。ローカル・フォルダに関連付けられた場合、ナレッジ・ベースは動的に同期され、更新されます。PDF、Word、Webページなど、複数の形式のドキュメントを解析し、質問に答える際に参照内容をトレースすることができます。

- ビルトインツールセット統合されたウェブクローラ、ブラウザコントロール、ローカルファイル管理、その他のユーティリティ、およびユーザーが独自のツールの統合を拡張するためのサポート。

- 継続的学習の進化このソフトウェアは、ユーザーの作業習慣や好みを学習する機能を備えており、使用しているうちに最適化され、最終的にはユーザーをよりよく理解するインテリジェントな身体へと進化することができる(この機能は現在テスト中)。

- リッチなチャット・インタラクション数式やマーメイド図(フローチャート、シーケンス図など)の描画をサポートし、ダイアログを自由に分岐させることができるため、コミュニケーション記録の管理やトレースが容易になります。

ヘルプの使用

ARGOは、ローカルAIインテリジェンスの導入と使用のプロセスを簡素化するように設計されているため、非技術的なユーザーであろうと開発者であろうと、すぐに始めることができます。

基本的なハードウェア要件

ARGO をインストールする前に、コンピュータが以下の最小構成要件を満たしていることを確認してください:

- CPU最低4コア

- メモリー(RAM)少なくとも8GB

より高い性能を必要とする大規模な言語モデルを実行する予定がある場合は、GPUアクセラレーションを利用するために、より高い構成のハードウェア、特にNVIDIAグラフィックカードを搭載したコンピュータを使用することをお勧めします。

デスクトップクライアントのインストール(初心者におすすめ)

これは、追加設定なしで、ダウンロードして使用する、最も簡単でわかりやすい方法です。

- ARGOの公式GitHubリリースページ(リリース)をご覧ください。

- お使いのオペレーティングシステムに応じて、対応するインストールパッケージをダウンロードしてください:

- Windows接尾辞

.exeファイルのようなargo-0.3.1-windows-x64-installer.exe。 - macOS (Apple Silicon)接尾辞

osx-installer.dmgファイルのようなargo-0.3.1-osx-installer.dmg。 - macOS (Intel)接尾辞

mac-intel-installer.dmgファイルのようなargo-0.3.1-mac-intel-installer.dmg。

- Windows接尾辞

- ダウンロードが完了したら、インストールファイルをダブルクリックし、画面の指示に従ってインストールを完了します。

Dockerを使ったデプロイメント(開発者・上級者向け)

もしあなたがDockerに精通していたり、ARGOをサーバーやオールインワンなどの環境に展開したいのであれば、このアプローチを選択することができます。このアプローチはより柔軟で、他のサービスと簡単に統合できます。

その他のソフトウェア要件:

Docker >= 24.0.0Docker Compose >= v2.26.1

ニーズに応じて、以下の展開オプションのいずれかを選択します:

1.オプション1:ARGOのみの設置(外部Ollamaへの接続)

すでに Ollama サービスがローカルで動作している場合、または他のコンテナで Ollama が動作している場合、このコマンドを使って ARGO を既存のサービスに接続させることができます。

docker compose -f docker/docker-compose.yaml up -d

銘記するこのプログラムにはOllamaサービスが含まれていないため、HuggingFaceなどのモデルをダウンロードすることはできません。

2.オプション2:OllamaによるARGOのインストール(CPU版)

このシナリオでは、ARGOとOllamaの両方を導入し、モデルの推論にCPUを使用します。これは、NVIDIAグラフィックカードを持たないデバイス上でローカルモデルを実行するための推奨方法です。

docker compose -f docker/docker-compose.ollama.yaml up -d

指示Ollamaは、ARGOをサービス・アドレスとするサービスとして展開される。 http://ollama:11434ARGOインターフェースは、ARGOインターフェース内でのローカルモデルの自動ダウンロードと読み込みをサポートしています。

3.オプション3:OllamaによるARGOのインストール(GPU版)

NVIDIAグラフィックカードを搭載したマシンを所有し、GPUを使用してモデル推論を高速化したい場合は、このソリューションを使用してください。

docker compose -f docker/docker-compose.ollama.gpu.yaml up -d

前提条件このバージョンはGPUサポートを有効にし、Ollamaサービスもコンテナ内にデプロイされ、GPUアクセラレーションをサポートします。

アルゴを訪問する

Docker経由でデプロイに成功したら、ブラウザで http://localhost:38888 ARGOのユーザーインターフェースにアクセス可能。

基本機能操作

- モデル・マネージメントソフトウェアに入ると、モデル管理インターフェイスに統合されたOllamaが表示されます。コミュニティから人気のあるオープンソースモデルをワンクリックでダウンロードしたり、APIキーを設定してOpenAIのようなリモートモデルサービスに接続することができます。

- インテリジェンスの創造インテリジェンス・ファクトリを使用すると、新しいインテリジェンスの役割を定義し、作業目標を設定し、使用できるモデルとツールを結合し、独自のナレッジベースを構成できます。

- 操作するARGOのインテリジェントシステムは、このタスクを自動的に「最新情報の検索」「重要情報の照合」「報告書の作成」などの複数のステップに分解し、順次実行します。ARGOは、タスクを自動的に「最新情報の検索」、「重要情報の照合」、「報告書の作成」などの複数のステップに分解し、順次実行します。

- ナレッジベースの利用知識ベース管理モジュールでは、ファイルのアップロード、ローカルフォルダとの関連付け、またはURLの入力によって知識ベースを作成できます。作成後、インテリジェント・ボディとの対話中に対応するナレッジベースをマウントするよう選択でき、インテリジェント・ボディは提供された情報に基づいて質問に回答します。

アプリケーションシナリオ

- 個人アシスタント

ARGOは、ユーザーのスケジュール管理、買い物の提案、日々の雑務の処理などを支援する24時間365日のパーソナル・アシスタントとして使用できる。 - 研究と調査

学生や研究者はARGOを使って学習を支援することができる。複雑な学術概念の理解を助け、豊富な学習リソースを提供し、学習計画をカスタマイズし、必要に応じて復習のアドバイスを与えることができます。論文や教科書をマウントすることで、ARGOはプロの学術クイズアシスタントになることができます。 - コンテンツ制作

ライター、ブロガー、マーケティング担当者にとって、ARGOは記事原稿を自動生成し、コピーライティングスタイルを最適化し、クリエイティブなインスピレーションを提供し、コンテンツ作成の効率と質を大幅に向上させることができる。 - プログラミング開発支援

開発者はARGOを使って、コード・スニペットを生成したり、プログラムをデバッグしたり、技術的な問題の解決策を探したりすることができます。ARGOは、開発者がプログラミングの課題をより効率的に解決するための、疲れ知らずのプログラミング・パートナーとして機能します。 - 専門分野のコンサルタント

カスタマイズにより、ARGOは法律顧問や業界アナリストなど、特定の業界の専門家に変身することができる。ユーザーは、特定の専門分野のニーズを満たすために、特別な知識ベースを備えたインテリジェントなボディを作成することができます。 - データ分析と報告

ARGOは迅速にデータを分析し、チャートやレポートを作成し、ビジネス上の意思決定のためのデータサポートを提供します。ユーザーはデータファイルをインポートし、分析するための指示を与えるだけでよい。

QA

- ARGOは無料ですか?

はい、ARGOはオープンソースプロジェクトであり、LICENSEライセンスの下でリリースされています。 - 私のデータは安全ですか?

ARGOの特徴のひとつは、"ローカルファースト "であること。会話やナレッジベースのコンテンツ、モデルファイルなど、すべてのデータは自分のコンピューターに保存され、クラウドサーバーにはアップロードされない。 - どのようなAIモデルを使用できますか?

ARGOは非常に互換性があります。Ollamaを内蔵しており、GGUFフォーマットのネイティブなオープンソースモデルを簡単にダウンロードして実行できる。また、APIキーを介してOpenAI、Claude、DeepSeekなどの主要なクローズドソースモデルプロバイダーへの接続もサポートしています。 - 技術者でなくてもARGOを使えますか?

ARGOはWindowsとmacOSユーザー向けにグラフィカルなインストールパッケージを提供しており、複雑なコマンドライン操作なしにダブルクリックでインストールできるため、技術的なバックグラウンドを持たないユーザーにも最適です。 - このプロジェクトはまだ開発中ですか?

はい、ARGOプロジェクトは現在、急速な開発の初期段階にあります。開発チームは機能の改善や問題の修正に積極的に取り組んでおり、将来的にはグローバルパーソナライズドメモリーや時間制限付きタスクなどの機能を追加する予定です。