谷歌在相继推出面向单一云端或桌面加速器运行的开源模型 Gemma 3 与 Gemma 3 QAT 之后,再次拓展其普惠 AI 的版图。如果说 Gemma 3 为开发者带来了强大的云端与桌面端能力,那么此次于 2025 年 5 月 20 日发布的 Gemma 3n 预览版,则清晰地揭示了其在移动设备端实时 AI 的雄心——目标是让我们日常使用的手机、平板和笔记本电脑直接运行高性能 AI。

为了驱动下一代端侧 AI 并支持多样化的应用场景,包括进一步提升 Gemini Nano 的能力,谷歌工程团队打造了一种全新的尖端架构。这一新架构据称是与高通、联发科以及三星的 System LSI 业务等移动硬件领导者紧密合作的成果,专为实现闪电般的快速响应和多模态 AI 处理而优化,旨在设备端直接提供真正个性化和私密的智能体验。

Gemma 3n 正是首款基于这一突破性共享架构构建的开放模型,让开发者从即日起便能通过早期预览版体验该技术。值得注意的是,同样的先进架构也将赋能下一代 Gemini Nano,为谷歌应用及其端侧生态系统中的广泛功能带来增强,并计划于今年晚些时候正式上线。这意味着,开发者通过 Gemma 3n 入手,实际上是在为一个即将登陆 安卓 (Android) 和 Chrome 等主流平台的底层技术进行预研。

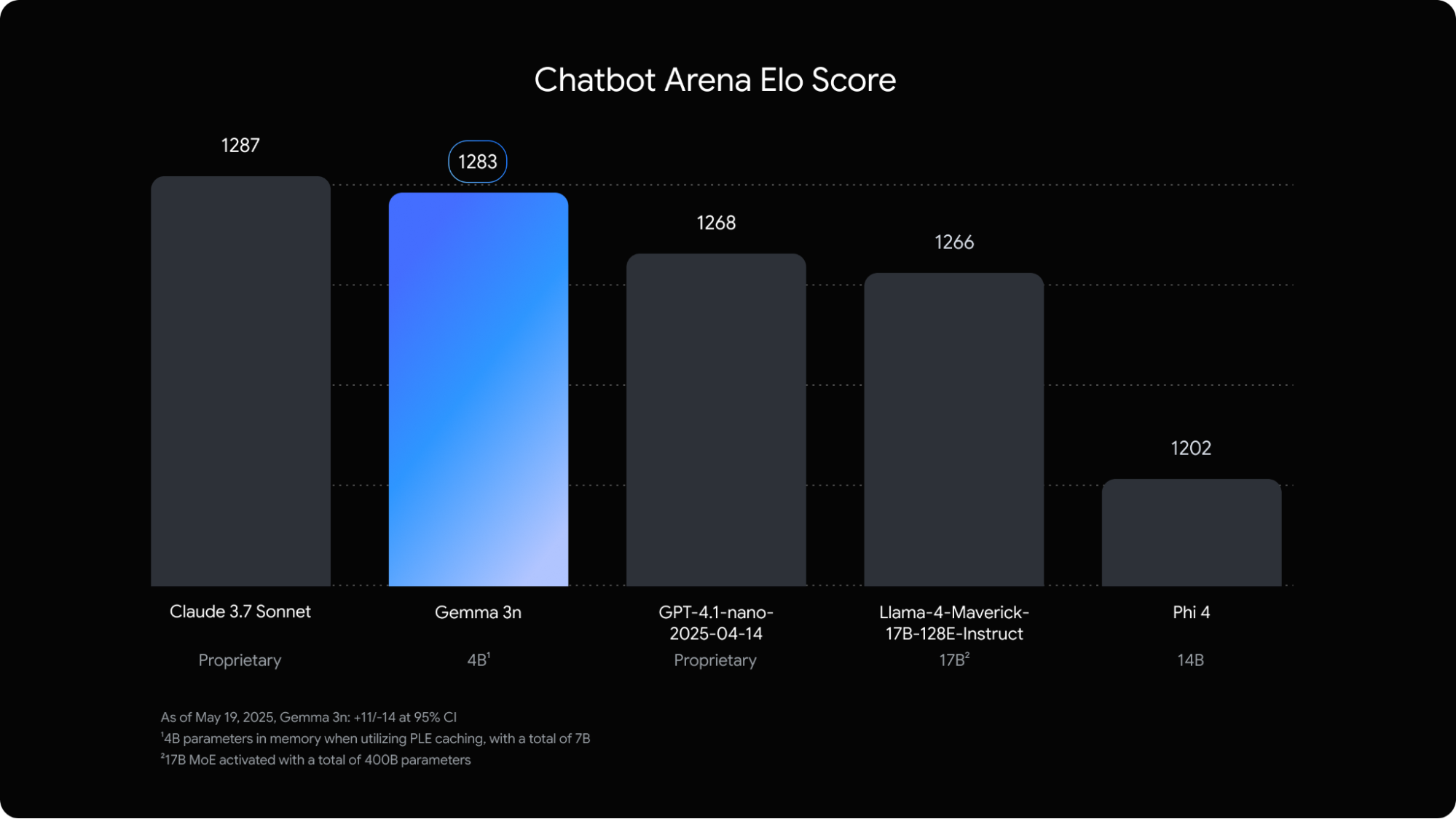

图注:此图表依据 Chatbot Arena Elo 分数对 AI 模型进行排名;分数越高(顶部数字)表明用户偏好度越高。Gemma 3n 在主流的专有模型和开源模型中均名列前茅。

Gemma 3n 的一个核心创新在于运用了谷歌 DeepMind 的“逐层嵌入 (Per-Layer Embeddings, PLE)”技术,这项技术显著降低了模型的内存 (RAM) 使用量。虽然模型的原始参数量分别为 50 亿 (5B) 和 80 亿 (8B),但 PLE 技术使得这些模型在实际运行时,其内存开销与 20 亿 (2B) 和 40 亿 (4B) 参数规模的模型相当。具体来说,它们能以仅 2GB 和 3GB 的动态内存占用运行。这一突破对于内存资源受限的移动设备而言,无疑是巨大的福音。更多技术细节可以在其官方文档中找到。

通过探索 Gemma 3n,开发者可以提前一窥这款开源模型的核心能力以及那些即将通过 Gemini Nano 应用于 安卓 (Android) 和 Chrome 平台的移动优先架构创新。

Gemma 3n 的关键能力剖析

Gemma 3n 专为在本地运行的快速、低资源占用的 AI 体验而设计,其主要特性如下:

- 优化的端侧性能与效率:相较于 Gemma 3 4B 模型,Gemma 3n 在移动设备上的响应启动速度提升了约 1.5 倍,同时模型输出质量也有显著改进。这得益于诸如逐层嵌入 (PLE)、键值缓存共享 (KVC sharing) 以及先进的激活量化 (activation quantization) 等创新技术,共同实现了内存占用的降低。

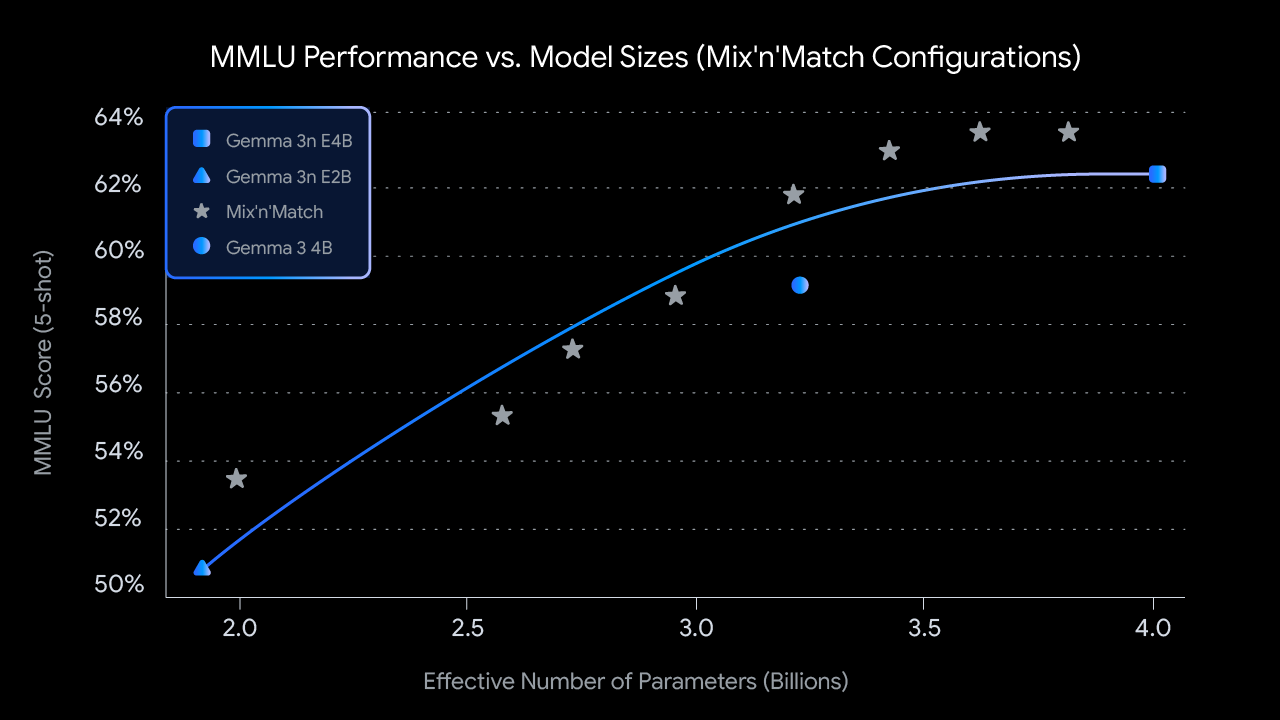

- “多合一”的灵活性 (Many-in-1 Flexibility):Gemma 3n 的 4B 活跃内存占用版本,借助 MatFormer 训练技术,其内部天然包含了一个嵌套的、业界领先的 2B 活跃内存占用子模型。这种设计赋予了模型动态权衡性能与质量的灵活性,无需托管多个独立的模型。更有趣的是,Gemma 3n 引入了“混搭 (mix’n’match)”能力,允许从 4B 模型中动态创建子模型,以最优地适应特定用例及其相关的质量/延迟需求。关于此项研究的更多细节,将在即将发布的技术报告中披露。

- 隐私优先与离线可用:本地执行的特性确保了功能在尊重用户隐私的前提下运行,并且即使在没有网络连接的情况下也能可靠工作。

- 扩展的音频多模态理解:Gemma 3n 不仅能理解和处理音频、文本和图像,还显著增强了视频理解能力。其音频功能使模型能够执行高质量的自动语音识别(转录)和翻译(语音到翻译文本)。此外,模型接受跨模态的交错输入,从而能够理解复杂的多模态交互。(公共实现即将推出)

- 增强的多语言能力:Gemma 3n 提升了多语言性能,特别是在日语、德语、韩语、西班牙语和法语方面表现更佳。其在 WMT24++ (ChrF) 等多语言基准测试中取得了

50.1%的成绩,反映了其强大的多语言处理实力。WMT (Workshop on Machine Translation) 是机器翻译领域的重要评测,ChrF 是一种常用的机器翻译评估指标。

图注:此图表展示了 Gemma 3n 的“混搭 (mix-n-match)”(预训练)能力在不同模型尺寸下的 MMLU 性能。MMLU (Massive Multitask Language Understanding) 是一项综合性的语言理解能力基准测试。

解锁移动新体验的潜力

Gemma 3n 有望通过以下方式,赋能新一波智能化的移动应用:

- 构建实时交互体验:能够理解并响应来自用户环境的实时视觉和听觉提示。

- 驱动更深层次的理解:利用音频、图像、视频和文本的组合输入,在设备端私密地处理信息,实现更具上下文的文本生成。

- 开发高级音频中心应用:包括实时语音转录、翻译以及丰富的语音驱动交互。

以下视频概述了您可以构建的体验类型:

负责任地共同构建

对负责任 AI 开发的承诺至关重要。与所有 Gemma 系列模型一样,Gemma 3n 也经过了严格的安全评估、数据治理,并根据其安全政策进行了微调校准。谷歌方面表示,他们以审慎的风险评估来对待开放模型,并随着 AI 形势的演变不断完善其实践。

Gemma 3n 模型参数深度解析

Gemma 3n 是一款专为在手机、笔记本电脑和平板电脑等日常设备上使用而优化的生成式 AI 模型。该模型包含了参数高效处理方面的创新,例如前面提到的逐层嵌入 (PLE) 参数缓存,以及 MatFormer 模型架构,后者提供了降低计算和内存需求的灵活性。这些模型具备音频输入处理能力,同时也能处理文本和视觉数据。

预览阶段与许可:Gemma 3n 目前处于早期预览阶段。用户可以在 Google AI Studio 和 Google AI Edge 中试用。与其他 Gemma 模型一样,Gemma 3n 提供开放权重,并授权用于负责任的商业用途,允许开发者在自己的项目和应用中进行微调和部署。

Gemma 3n 的关键特性,在技术层面可以进一步细化为:

- audio input:处理声音数据以进行语音识别、翻译和音频数据分析。

- 视觉与文本输入:多模态能力使其能够处理视觉、声音和文本信息,帮助理解和分析周围世界。

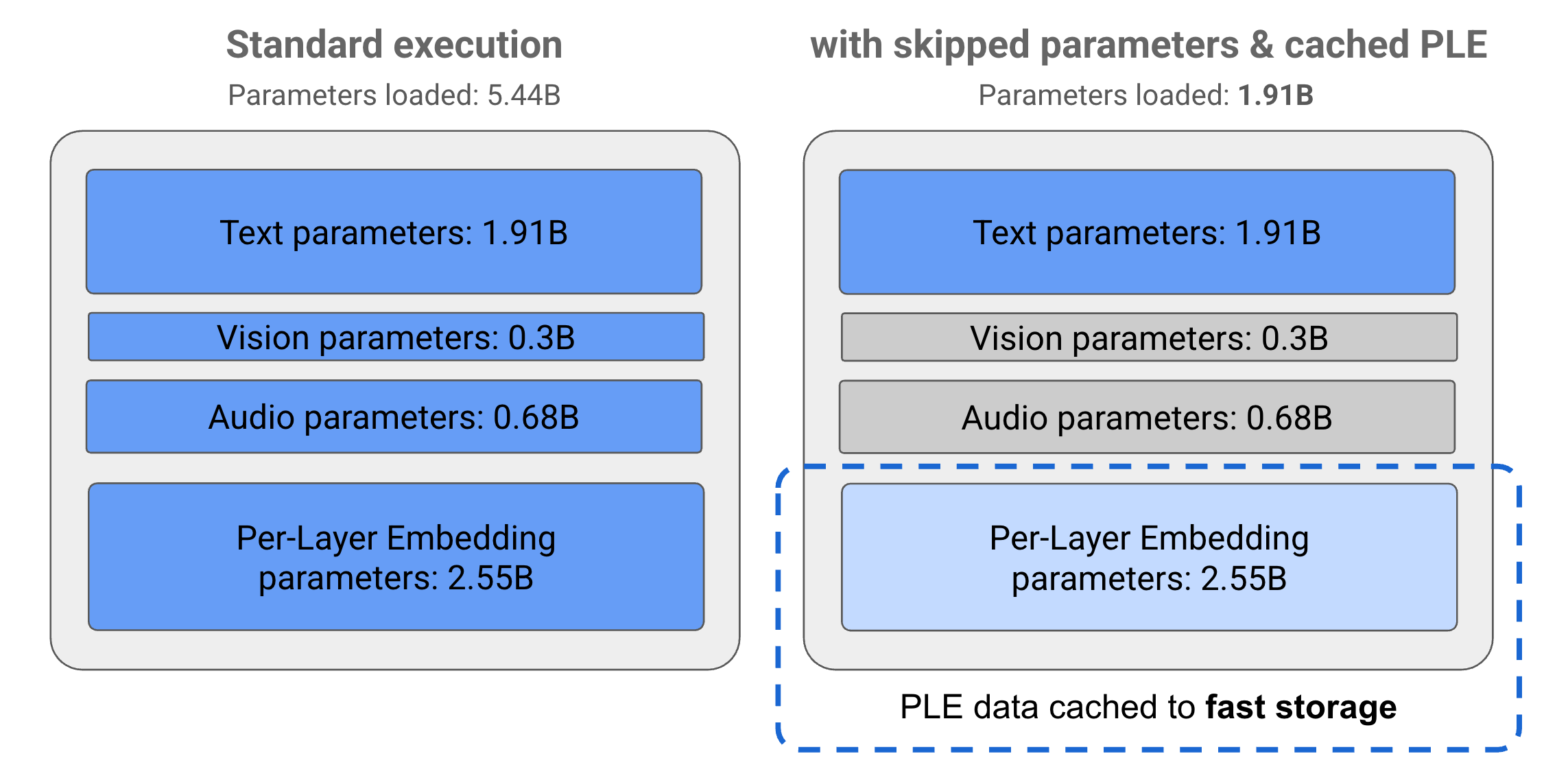

- PLE 缓存 (PLE caching):模型中包含的逐层嵌入 (PLE) 参数可以被缓存到快速的本地存储中,以降低模型运行时的内存成本。这些 PLE 数据在模型执行期间用于创建增强每个模型层性能的数据,通过将 PLE 参数排除在模型主内存空间之外,减少了资源消耗,同时提升了模型响应质量。

- MatFormer 架构 (MatFormer architecture):“套娃式” Transformer (Matryoshka Transformer) 架构,在一个较大的模型内部嵌套了较小的模型。这些嵌套的子模型可以在响应请求时被调用,而无需激活外层模型的全部参数。这种仅运行 MatFormer 模型内部较小核心模型的能力,可以显著降低模型的计算成本、响应时间和能耗。对于 Gemma 3n 而言,E4B 模型就包含了 E2B 模型的参数。该架构还允许开发者选择参数并在 2B 和 4B 之间组装中间大小的模型。更多细节可参阅 MatFormer 研究论文。

- 条件化参数加载 (Conditional parameter loading):类似于 PLE 参数,可以选择性地跳过加载模型中的某些参数(如音频或视觉参数)到内存中,以减少内存负载。如果设备具备所需资源,这些参数可以在运行时动态加载。总体而言,参数跳过可以进一步减少 Gemma 3n 模型所需的运行内存,使其能够在更广泛的设备上运行,并允许开发者针对要求不高的任务提高资源效率。

- Extensive language support:具备广泛的语言能力,在超过 140 种语言上进行了训练。

- 32K 令牌上下文 (32K token context):为分析数据和处理任务提供了充足的输入上下文长度。

draw attention to sth.:若有兴趣为 安卓 (Android) 移动应用构建生成式 AI 解决方案,可关注 Gemini Nano。更多信息请参阅 安卓 (Android) Gemini Nano 开发者文档。

模型参数与“有效参数”的奥秘

Gemma 3n 模型的命名中带有如 E2B cap (a poem) E4B 这样的参数计数,这些计数低于模型包含的总参数数量。前缀 E 表明这些模型能够以一组简化的“有效参数 (Effective parameters)”来运行。这种简化的参数操作可以通过 Gemma 3n 模型内置的灵活参数技术来实现,帮助其在资源较低的设备上高效运行。

Gemma 3n 模型的参数主要分为 4 组:文本参数、视觉参数、音频参数和逐层嵌入 (PLE) 参数。在 E2B 模型的标准执行模式下,运行时会加载超过 50 亿个参数。然而,通过运用参数跳过和 PLE 缓存技术,该模型能够以接近 20 亿 (1.91B) 个参数的有效内存负载运行,如下图所示。

图 1. Gemma 3n E2B 模型参数在标准执行模式下与使用 PLE 缓存和参数跳过技术实现有效较低参数负载的对比。

利用这些参数卸载和选择性激活技术,可以用非常精简的参数集运行模型,或者激活额外的参数来处理视觉和音频等其他数据类型。这些特性使得用户可以根据设备能力或任务需求灵活调整模型功能。

即刻上手:预览 Gemma 3n

对 Gemma 3n 的早期试用已经开放:

- 通过 Google AI Studio 进行云端探索:无需任何设置,直接在浏览器中访问 Google AI Studio 即可试用 Gemma 3n。可以即时探索其文本输入功能。

- 通过 Google AI Edge 进行端侧开发:对于希望在本地集成 Gemma 3n 的开发者,Google AI Edge 提供了相应的工具和库。目前可以开始使用其文本和图像理解/生成功能。

Gemma 3n 标志着在普及尖端、高效 AI 方面迈出的新一步。随着这项技术的逐步开放,从今天的预览版开始,它将为开发者社区带来怎样的创新,着实令人期待。

您可以在 5 月 22 日起,于 io.google 网站上探索此公告以及所有 Google I/O 2025 的更新。

对开始构建感兴趣了吗?不妨从 Gemma 模型的入门指南开始。